最着人工智能AI能力越来越强,对其进行安全风险进行评估和控制成为当务之急。DeepSeek就被Anthropic认为是在各个相关方面都不安全的模型,这种指责恐怕不能以妒忌的原因简单拒绝。

关键要点

- 人工智能安全等级评估(如Anthropic的ASL)是衡量AI系统风险的框架,研究表明它们帮助确保安全措施与风险相匹配。

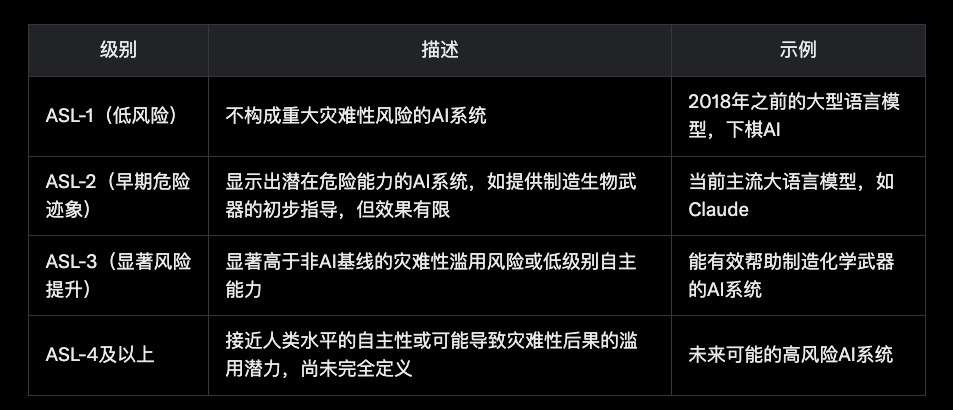

- Anthropic的AI安全等级(ASL)分为ASL-1(低风险)到ASL-4+(高风险),每个级别有相应的安全措施。

- 其他方案包括OpenAI的准备框架、欧盟AI法案的风险分类和NIST的AI风险管理框架,证据显示它们各有侧重。

- 这些框架存在争议,尤其是在如何平衡创新与安全方面,建议采用灵活的方法。

什么是AI安全等级评估

AI安全等级评估是用来分类AI系统潜在风险的框架,目的是确保在开发和部署AI时采取适当的安全措施。这些评估帮助识别AI可能造成的危害,如误用或失控,并制定相应的缓解策略。Anthropic的AI安全等级(ASL)是一个著名的例子,类似于生物安全等级(BSL),它根据AI能力分级风险。

Anthropic的AI安全等级(ASL)

Anthropic提出了ASL系统,分为以下几个级别:

- ASL-1(低风险):包括较早的大型语言模型或特定任务AI,如下棋机器人,风险较低。

- ASL-2(早期危险迹象):AI系统显示出潜在危险,如提供制造生物武器的初步指导,但效果有限。目前主流大语言模型(如Anthropic的Claude)通常在此类别。

- ASL-3(显著风险提升):AI系统可能显著增加风险,如帮助制造化学、生物、放射性或核武器,或具有一定自主能力。

- ASL-4及以上:针对更高风险的AI系统,目前技术尚未达到,具体标准尚未完全定义。

Anthropic的《负责任扩展策略》(RSP)确保在AI能力提升时,安全措施必须相应加强。如果安全技术跟不上,训练将被暂停。

其他评估方案

除了Anthropic的ASL,还有其他框架:

- OpenAI的准备框架:关注四个风险类别——说服力、网络安全、CBRN(化学、生物、放射性、核)和模型自主性,每个类别有定义的风险水平,用于评估前沿模型的风险。

- 欧盟AI法案:将AI系统分为不可接受风险(禁止)、高风险(严格监管,如医疗和交通AI)、有限风险(透明度要求,如聊天机器人)和最低/无风险(基本不受额外监管)。

- NIST AI风险管理框架(AI RMF):提供灵活的方法,贯穿AI生命周期,强调可信性考虑,但不是像ASL那样的分级系统。

这些框架各有侧重,旨在平衡创新与安全,但如何实施存在争议,尤其是在监管强度和全球一致性方面。

详细报告

AI安全等级评估是近年来随着AI技术快速发展而提出的重要概念,旨在衡量和控制AI系统可能带来的风险。以下是关于Anthropic的ASL及其他相关方案的详细分析,涵盖其定义、实施方式和比较。

Anthropic的AI安全等级(ASL)

Anthropic是一家专注于AI安全的公司,其ASL框架受到生物安全等级(BSL)的启发,旨在通过分级评估AI系统的潜在灾难性风险,并制定相应的安全措施。根据Anthropic的负责人扩展策略(https://www.anthropic.com/news/anthropics-responsible-scaling-policy),ASL分为以下几个级别:

ASL的实施基于“能力阈值”,如自主研发能力或武器制造协助能力,并辅以相应的防护措施,如高级红队测试(red-teaming)和模型权重保护。如果发现不可接受风险,训练或部署将被暂停。

OpenAI的准备框架

OpenAI的准备框架是另一种评估AI风险的方案,特别关注前沿模型的风险。根据OpenAI的安全性与责任页面(https://openai.com/safety/),该框架包括四个风险类别:

- 说服力:AI影响或操纵人类行为的能力。

- 网络安全:AI被用于网络攻击或创建漏洞的风险。

- CBRN:AI被用于开发化学、生物、放射性或核武器的风险。

- 模型自主性:AI模型独立行动可能导致失控的风险。

每个类别有定义的风险水平,OpenAI通过专用团队评估模型,特别是在部署前确保风险可控。

欧盟AI法案的风险分类

欧盟AI法案是首个全面的AI监管法律,根据欧盟AI法案的高级摘要(https://artificialintelligenceact.eu/high-level-summary/),它将AI系统分为以下类别:

- 不可接受风险:禁止的AI应用,如政府运行的社会评分系统。

- 高风险:如医疗、交通和执法AI,需遵守严格的透明度、人为监督和稳健性要求。

- 有限风险:如聊天机器人,需满足透明度义务,告知用户与AI交互。

- 最低/无风险:其他AI系统,仅需遵守一般法律,无额外监管。

该法案旨在平衡创新与安全,但实施细节仍在讨论中,特别是在跨国一致性方面。

NIST AI风险管理框架(AI RMF)

NIST的AI RMF提供了一个灵活的框架,旨在通过NIST AI风险管理框架页面(https://www.nist.gov/itl/ai-risk-management-framework)改善AI产品、服务和系统的可信性设计、开发、使用和评估。该框架不采用像ASL那样的分级系统,而是强调整个AI生命周期的风险管理,包括数据收集、模型训练和部署。它通过社区参与和公开评论开发,适用于各种行业。

其他相关框架

除了上述主要方案,还有其他框架值得一提:

- OECD AI系统分类框架:由OECD开发,帮助政策制定者评估AI系统的机会和风险,强调技术特征与政策影响的联系,详见OECD AI分类框架页面(https://oecd.ai/en/classification)。

- UNESCO AI伦理建议:2021年发布,倡导负责任AI,指导各国采用伦理AI风险评估框架,详见UNESCO AI伦理建议页面(https://www.unesco.org/en/artificial-intelligence/recommendations)。

这些框架虽然不完全等同于ASL,但都旨在通过分类和评估管理AI风险。

比较与争议

不同框架的侧重点不同:

- ASL和DeepMind的前沿安全框架更注重分级和能力阈值,适合前沿AI研究。

- EU AI法案和NIST AI RMF更注重监管和行业应用,强调法律合规和可信性。

- 争议主要集中在如何平衡创新与安全,特别是在监管强度和全球一致性方面。例如,EU AI法案的高风险分类可能限制某些AI应用的开发,而ASL的暂停机制可能延缓技术进步。

AI安全等级评估如Anthropic的ASL提供了一种系统化的风险分级方法,其他方案如OpenAI的准备框架、EU AI法案和NIST AI RMF则各有侧重。这些框架共同推动了AI安全的研究和实践,但实施中仍需灵活应对技术进步和伦理挑战。

中国AI安全监管法规体系

法规框架概述

中国建立了较为完善的AI监管法规体系,主要包括:

- 《网络数据安全管理条例》(2025年1月1日实行):首次在行政法规层面提出AI训练安全管理要求。条例第十九条规定:"提供生成式人工智能服务的网络数据处理者应当加强对训练数据和训练数据处理活动的安全管理,采取有效措施防范和处置网络数据安全风险。"

- 《生成式人工智能服务管理暂行办法》2023年5月23日通过,对生成式AI提出具体监管要求。

- 《互联网信息服务算法推荐管理规定》(2021年11月16日通过)和《生成式人工智能服务安全基本要求》(TC260-003)等一系列合规要求。

分类分级监管原则

中国的AI监管体系采用分类分级监管原则。《生成式人工智能服务管理暂行办法》第三条明确提出:"国家坚持发展和安全并重、促进创新和依法治理相结合的原则,采取有效措施鼓励生成式人工智能创新发展,对生成式人工智能服务实行包容审慎和分类分级监管。"

所谓分类分级监管,是指根据生成式人工智能应用的服务场景,对应用中可能出现的风险及影响从高到低进行排序,再根据不同风险等级划定不同的监管方式。这与《数据安全法》中的分类分级保护制度思路一致。

中国人工智能安全风险评估方法

中国学者提出了一种基于信息熵和马尔可夫链的人工智能全生命周期安全风险评估方法。该方法从数据、框架、算法模型、管理和基础设施5个层面构建评估指标体系,通过资产影响、威胁频度和脆弱性三个维度评估AI系统的安全风险。

评估过程包括构建隶属度、确定风险熵、确定权重向量、各类安全风险量化和整体安全风险评估5个步骤8。最终得出的安全风险值可对照预设的安全风险隶属度等级表进行判定,形成对AI系统安全风险的整体评估。

两种框架的比较分析

相似之处

- 分级监管思路:无论是Anthropic的ASL框架还是中国的监管体系,都采用分级监管思路,根据AI系统的风险程度采取不同的监管措施。

- 多维度评估:两种框架都强调评估的全面性,包括对技术、数据和应用环境等多方面的考量。

- 风险预防导向:两种框架都以预防潜在风险为核心,强调在AI系统开发和部署前进行风险评估和管控818。

差异之处

- 关注重点不同:Anthropic的ASL框架更侧重于预防"灾难性风险",特别关注AI自主性和滥用风险;而中国的监管体系更侧重于数据安全、个人信息保护和社会稳定。

- 框架性质不同:Anthropic的框架是企业自我规范,更具灵活性;中国的监管体系是国家法规,具有强制性和全局性。

- 技术细节程度不同:Anthropic的框架更具技术性和细节性,明确定义了不同等级的技术特征;中国的框架则更具宏观性和原则性,为行业提供整体指导。

- 实施主体不同:Anthropic的框架主要由企业自主实施;中国的监管体系则由政府部门主导,企业必须遵守。

人工智能安全评估对机构的启示

合规义务与责任

随着全球AI监管趋严,企业需要主动履行合规义务,尤其是针对高风险AI系统的安全评估和风险管控。中国机构组织需要特别关注《网络数据安全管理条例》和《生成式人工智能服务管理暂行办法》等法规对AI训练和应用的具体要求。

自我评估与第三方评估相结合

机构组织应建立AI系统安全自评估机制,同时引入第三方评估,提高评估的客观性和权威性。这与Anthropic的框架中强调的红队测试和独立审核思路一致。

全生命周期风险管理

机构组织应从AI系统的全生命周期角度构建风险管理体系,覆盖数据准备、模型训练、部署应用和运维阶段,实现"可管可控"的目标。

结论与展望

人工智能安全等级评估是保障AI安全发展的重要工具。Anthropic的ASL框架为行业提供了一个自我规范的范例,中国的监管体系则从国家层面为AI安全提供了法律保障。两种框架各有特点,相互借鉴,共同推动了全球AI治理的发展。

随着AI技术的不断演进,安全等级评估框架也将持续迭代,更加精细化和系统化。企业应积极适应监管要求,将安全合规纳入AI系统开发的全过程,实现技术创新与安全发展的平衡。

未来,全球AI治理可能会向着更加协同的方向发展,不同国家和企业的安全评估标准可能会趋同,形成更加统一的全球AI安全治理体系。这将为AI技术的健康发展和全球共享创造更好的条件。

留下评论