面对Anthropic提出的开源协议MCP(Model Context Protocol)星火燎原成为事实标准,OpenAI试图重新夺回领导权,在其大模型API调用已车给你喂事实标准基础上,推出智能体互联更加简单的方案:Responses API,开闭源大战即将打响。

关键要点

- OpenAI 的 Responses API 是构建智能代理的便捷工具,支持内置了成熟的工具如网络搜索、文件搜索和桌面电脑使用。

- 与之前的 API 相比,Responses API 结合了聊天补全的简单性和助手 API 的工具使用与状态管理功能。

- Anthropic 的 MCP 是一个开放标准,允许与各种数据源连接,提供更大的灵活性。

- 在开发智能代理应用时,Responses API 易用性强,而 MCP 更适合需要自定义数据源的场景。

- 两者在 AI 代理工具集成领域存在竞争关系,未来可能共存,但给用户带来一定不便,取决于社区采用和企业需求。

OpenAI Responses API 介绍功能概述

OpenAI 的 Responses API 是一种新的 API,旨在简化构建能够使用多种工具并维护状态的 AI 代理。它支持内置工具,如网络搜索、文件搜索和计算机使用,允许代理访问实时信息并执行复杂任务。API 是状态化的,能记住之前的交互,这对构建需要上下文记忆的对话代理至关重要。

使用方法

开发者可以使用 Responses API 创建 AI 代理,这些代理可以:

- 维护对话历史和状态。

- 使用托管工具如网络搜索和文件搜索。

- 处理多模态输入,包括文本、图像和音频。

例如,开发者可以通过单一 API 调用实现多轮交互,效率高于之前的聊天补全 API。

与过去 API 的不同

相比于之前的聊天补全 API(主要用于生成聊天格式的文本),Responses API 更适合需要工具使用和状态管理的代理体验。助手 API 虽然也提供类似功能,但可能更复杂。Responses API 简化了这一过程,提供更高效的方式来管理工具交互和状态。

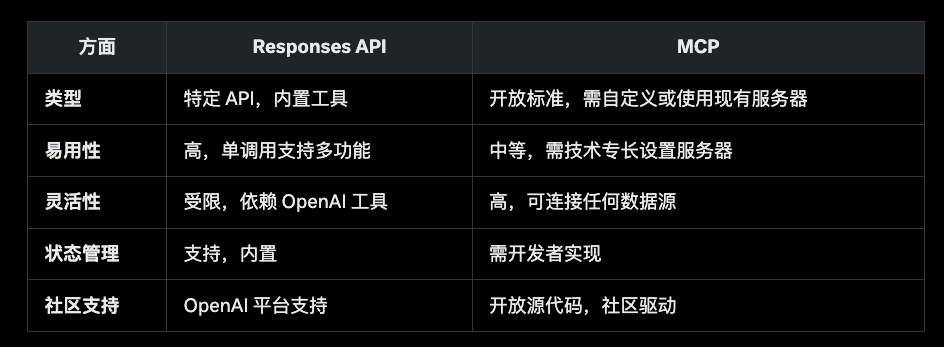

与 Anthropic MCP 的比较功能对比

Anthropic 的模型上下文协议(MCP)是一个开放标准,标准化 AI 应用与数据源和工具的连接。MCP 允许开发者构建自己的集成,连接到任何支持 MCP 的数据源,提供更大的灵活性。开发智能代理应用的优劣

- Responses API 的优势:易用性强,内置工具由 OpenAI 管理,确保可靠性和性能。适合快速构建使用 OpenAI 提供工具的代理。

- Responses API 的劣势:依赖 OpenAI 平台,工具受限,可能不适合需要特定工具的场景。

- MCP 的优势:灵活性高,能连接到任何有 MCP 服务器的数据源,适合企业或需要自定义集成的应用。

- MCP 的劣势:实现复杂,可能需要更多技术专长来设置或使用现有 MCP 服务器,服务器实现可能不一致。

竞争关系与未来前景

Responses API 和 MCP 在 AI 代理工具集成领域存在竞争关系。Responses API 是 OpenAI 的特定产品,而 MCP 是 Anthropic 的开放标准。当然两者共存也是没有问题的,Responses API 因易用性和 OpenAI 的市场地位而得到流行,而 MCP 可能在需要自定义数据源的场景中获得牵引,尤其是在模型私服或开源模型应用架构的企业环境中。

综述

OpenAI 的最新开放 Responses API 是 AI 代理开发领域的重要进步,结合了聊天补全 API 的简单性和助手 API 的工具使用与状态管理功能,发布于 2025 年 3 月 11 日。根据 OpenAI 开发者社区的公告,这款 API 旨在提供更快、更灵活的方式来创建代理体验,支持内置工具如网络搜索、文件搜索和计算机使用。

Responses API 的详细功能Responses API 专注于处理多个工具、多轮交互和多模态输入的单一 API 调用,这使其比之前的聊天补全 API 更高效。它的状态性允许维护对话历史,开发者可以通过client.responses.retrieve(response id=response.id)检索状态。例如,它支持网络搜索工具,使用 OpenAI Index 优化聊天应用,类似于 ChatGPT 的网络搜索功能。此外,它原生支持文本、图像和音频输入。

与聊天补全 API 相比,Responses API 在效率上更胜一筹,后者需要三个步骤(图像分析、网络搜索、总结),而 Responses API 可在一调用中完成。

与过去 API 的差异

之前的聊天补全 API 主要用于生成聊天格式的文本,适合简单的对话生成。而助手 API 提供工具使用和状态管理,但可能更复杂。Responses API 结合了两者的优点,简化了工具集成和状态管理的流程。根据 OpenAI 开发者社区的帖子,Responses API 是基于助手 API 测试版的反馈构建的,旨在更易用。

与 Anthropic MCP 的详细比较

Anthropic 的模型上下文协议(MCP)于 2024 年 11 月发布,是一个开放标准,旨在标准化 AI 应用与数据源和工具的连接。根据 Anthropic 的官方文档,MCP 类似于 USB-C 端口,为 AI 应用提供通用连接方式,允许与内容库、业务工具和开发环境等系统交互。其文档 URL 为MCP Documentation(https://modelcontextprotocol.io/),快速入门指南(https://modelcontextprotocol.io/quickstart/user)。

在开发智能代理应用时,Responses API 的优势在于易用性,内置工具如网络搜索和文件搜索由 OpenAI 管理,确保性能和可靠性。而 MCP 的灵活性更高,开发者可连接到任何有 MCP 服务器的数据源,如 Google Drive、Slack 和 GitHub 的预建服务器。根据开发者博客,MCP 使用 JSON-RPC 和 Server-Sent Events(SSE)进行通信,支持 TypeScript 和 Python SDK。

Responses API 的劣势在于对 OpenAI 平台的依赖,可能不适合需要特定工具的场景。而 MCP 的劣势是实现复杂,服务器一致性可能因不同实现而异。根据开发者讨论,MCP 适合企业级应用,但初期设置可能费时。

竞争关系与未来前景

Responses API 和 MCP 在 AI 代理工具集成领域存在竞争关系。Responses API 是 OpenAI 的产品,依托其市场地位,可能在通用场景中更受欢迎。而 MCP 作为开放标准,若社区广泛采用,可能在需要自定义集成的企业环境中占优势。根据 Medium 文章的比较,两者可能共存,满足不同需求。未来前景取决于社区采用和企业需求。Responses API 因易用性可能短期内更流行,而 MCP 的开放性可能带来长期影响,尤其在标准化的 AI 生态系统中。

留下评论