从工程角度看,小模型在自然语言处理(NLP)和多模态(包括计算机视觉)领域中逼近甚至超越大模型的策略与方法,主要集中于中低成本算力资源下的实用技巧。本文重点分析近一两年的发展趋势和实践经验,从模型架构优化、知识蒸馏与迁移学习、数据技巧、基座模型选择、低算力部署五个方面,探讨适用于本地或混合云端部署的最佳实践。

模型架构优化策略

小模型要取得与大模型相当的效果,首先要在模型架构上进行优化设计,使有限参数发挥最大效能:

- 轻量化与模块化设计:采用更浅、更窄的网络或共享参数等策略减少模型规模,例如DistilBERT将BERT模型参数削减40%但保留了约97%的语言理解能力,推理速度提升了60% 。又如ALBERT通过跨层参数共享显著减少参数量。对视觉任务,EfficientNet系列通过AutoML找到最优深度/宽度/分辨率组合,在大幅降低计算量的同时提升准确率。

- Mixture-of-Experts (MoE)稀疏化架构:MoE通过引入多个“专家”子模型并由门控机制选择性激活部分专家,使得模型拥有超大参数总量但每次推理只使用其中一部分,从而兼顾性能和效率。例如Google的Switch Transformer和LIMoE模型针对多模态任务将图像和文本分别由不同专家处理,取得了更好的模态分离表征。近期的一些衍生如Mixture-of-Depth (MoD)模型在每层通过二值门控决定是否跳过该层,从而对不同token动态分配计算,以更少FLOPs获得与深层Transformer相当的效果 ()。这类条件计算架构提高了小模型的参数利用效率。

- 剪枝(Pruning)与网络搜索:通过剪除冗余的连接和神经元,进一步压缩模型规模。2024年有研究展示了实用的LLM剪枝流程:对现有大模型(如LLaMA)进行深度、宽度、注意力头等多维度的剪枝,然后用不到原训练数据3%的数据进行蒸馏式再训练,即可将模型压缩2-4倍,同时在语言建模基准上性能仍优于同尺寸未剪枝模型。例如上述方法将原8B参数模型剪至4B左右,在使用训练样本数仅1/40的条件下,性能超越了未剪枝的LLaMA2-7B,并可媲美Mistral-7B等最新7B模型 。此外,结合NAS(神经架构搜索)自动探索最优的小模型结构(如MobileNet系列、EfficientNet)也是常用手段,其结果往往比人工设计的大模型更加高效。

表1:小模型在特定条件下媲美大模型的案例

上述表格列举了一些代表性案例:通过架构改进和压缩,小模型在特定任务上已逼近甚至超越体积大得多的模型。这些技术包括对模型进行层次和结构上的裁剪优,以及引入稀疏专家、动态深度等模块来提升推理效率。

蒸馏与迁移学习

知识蒸馏(Knowledge Distillation, KD)和高效微调等迁移学习技术,是让小模型取得媲美大模型性能的另一大利器。

- 知识蒸馏:由大型教师模型指导小模型学习其行为分布。蒸馏能够压缩大型模型的知识到小模型中,同时尽可能保持性能。例如,DistilBERT即通过在预训练阶段让小模型模仿BERT的预测分布,将BERT-base压缩为体积60%的模型且性能几乎不减。在视觉领域,常用ResNet-101等为教师,蒸馏出MobileNet之类的学生模型,用较少计算达到接近教师的准确率。

- 逐步蒸馏 (Step-by-Step Distillation):2023年的新方法表明,让大模型不仅提供答案,还提供中间推理过程(思维链)作为教学信号,可以大幅提升学生模型的效果。Hsieh等提出的“Distilling Step-by-Step”方法利用LLM产生的逐步推理“理由”作为额外监督,小模型同时学习问题->理由->答案的映射。在仅使用较少训练样本的情况下,该方法训练的770M参数T5模型在NLP基准上超越了5400亿参数PaLM的few-shot表现。这表明丰富的知识信号蒸馏(不仅限于最终答案)能让小模型弥补体量劣势。

- 大模型生成数据微调:一种实用的迁移学习是利用现有强大模型自动生成高质量训练数据,然后用来微调较小模型。Stanford Alpaca就是典型案例:用OpenAI的text-davinci-003模型生成了52K条指令-响应数据,来微调7B的LLaMA模型。结果得到的Alpaca-7B在单轮指令跟随上表现出与text-davinci-003(相当于GPT-3.5)相似的行为和质量。这一过程本质上是通过合成数据的离线蒸馏,以极低成本让小模型学会大模型的能力。工业上也出现了类似做法,将GPT-4产生的问答对用于训练较小的专用客服模型等。

- 参数高效微调:LoRA(低秩适配)、Prompt Tuning等方法允许在冻结大模型大部分参数的情况下,通过调整极少量新参数来迁移学习新任务。这类方法降低了微调开销,也避免了小模型从零开始学习。例如在资源受限场景下,可以对一个中等规模的预训练模型(如5亿参数)应用LoRA微调,仅增加千分之几的参数量,却足以让模型掌握特定任务知识。再比如Sparse Fine-tuning结合MoE思想,让小模型训练一组短小的软提示(prompt)来针对不同数据子集,也取得了比全参数微调更高的效率。这些迁移学习技巧在不显著增加推理成本的前提下,提升了小模型针对特定任务的性能。

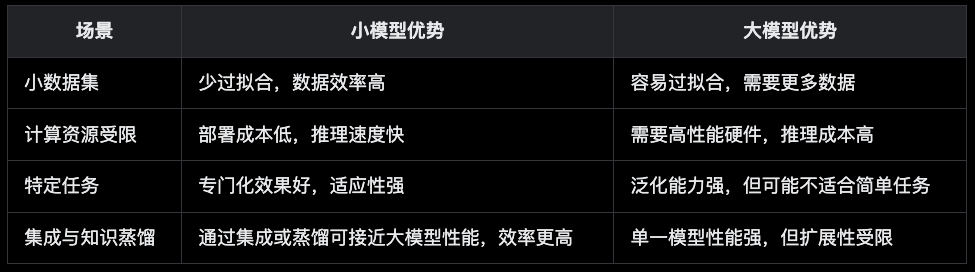

值得注意的是,经过精心微调的小模型在很多具体任务上的表现已超过通用的大模型。一项对比调查发现,对于大多数传统NLP基准任务(分类、问答等),ChatGPT这类未专门微调的大模型并不占优,反而是经过任务数据微调的小模型效果更佳。这再次证明了迁移学习的价值:针对性训练能让小模型释放更大潜力。

数据层面的技巧

有句话叫“数据即燃料”,对于小模型尤其如此。充分利用高质量的数据能够显著缩小小模型和大模型的鸿沟。

- 高质量小数据集:精心标注和清洗的小型数据集往往比海量但噪声较大的数据更能提升模型性能。例如,在领域专用的NLP任务中,一个几千条高质量标注的数据集微调的小模型,可能胜过在海量爬虫数据上训练但未见过该领域的大模型。高质量数据使小模型学得更精准,不被噪声干扰,从而提升泛化表现。

- 多任务训练:让小模型在多种相关任务上联合训练,学习更通用的特征和知识。Google的T5、FLAN等研究显示,将成百上千的NLP任务指令一起微调,可以极大提升模型的通用能力。尤其是小模型从多任务指令微调中受益相对更大:例如Flan-T5 Small在融合指令数据后,其零样本和少样本能力有质的飞跃,甚至可在某些任务上达到比未指令微调的数十亿参数模型更好的效果。这种“以任务丰富度弥补模型规模”的策略,是2023年后指令学习的核心趋势。

- 合成数据与数据增强:当真实数据不足时,可以通过数据合成和增强来扩充训练集。从NLP看,常见方法包括机器翻译的回译(生成同义问句)、利用大型语言模型自动问答生成练习数据等。以Alpaca为例,其52K指令就是完全由LLM合成的高质量伪数据,成功赋能了小模型。在视觉任务中,生成式模型可合成逼真的图像供小模型训练,或通过数据增强(裁剪、翻转、MixUp等)放大数据量。这些技巧能够丰富小模型的见识,避免过拟合,从而与大模型(见过海量数据)站在更接近的起跑线。

- 链式思维数据:前文提及,将大模型的中间推理步骤提供给学生模型学习。这个思路也可视作数据层面的增强:即为训练集样本配备人类或AI撰写的详解过程。2023年的研究证明,这种带有解释标签的数据能让小模型在推理题上取得远超自身基准的成绩。可以说,小模型通过学习大模型的“思路”而不仅是“结论”,真正触及了大模型性能的精髓。

总之,小模型要成功“以小搏大”,离不开数据方面的巧劲。正如实践经验表明的:“与其盲目增加模型参数,不如给予模型更好的养料(数据)”。高质量、多样化且契合任务的数据,往往能让小模型迸发出惊人的能力。

基座模型选择推荐

选择合适的预训练基座模型进行微调,是工程实践中小模型取得高性能的捷径之一。以下根据NLP和多模态任务分别给出推荐:

- NLP预训练小模型:优先考虑那些经过压缩或高效架构设计的开源模型。例如BERT系列的蒸馏版和裁剪版:

-

- DistilBERT(66M参数)适合文本分类、问答等常见任务,性能接近BERT-base但运行更快。

- TinyBERT和MiniLM系列(数千万参数级)通过层蒸馏和注意力蒸馏得到,在多项NLU任务上达到与BERT-base相当的效果。

- ELECTRA-Small/Base(14M/42M参数)使用替换检测预训练,在小模型中精读能力突出,Fine-tune后可媲美更大模型。

- 若需要生成能力,可选T5-Small或T5-Base以及其指令微调版(如Flan-T5)。这些模型仅有几千万到几亿参数,但经过指令数据微调后具备了一定的问答和推理能力,可用于对话、摘要等应用。

- 小型多模态与视觉模型:针对图像和多模态任务,选择轻量高效的视觉 backbone 和跨模态模型:

-

- MobileNetV3、EfficientNet-lite等是移动端首选,参数量远小于ResNet50但分类精度相当,在实时检测(如MobileNet-SSD、YOLOv5s)中广泛应用。

- Vision Transformer (ViT) 小型版:如DeiT-Tiny/Small,通过蒸馏训练的小型ViT,在ImageNet上达到ResNet水平,参数更少。

- CLIP模型提供了多种尺寸的视觉文本编码器,若需图文检索/识别,可选ViT-B/32这类较小模型(约0.1B参数)并微调,能取得不错的多模态表示效果。

- 新兴的多模态大模型也有小型化方案:例如MiniGPT-4利用Vicuna-13B(基于LLaMA的开源对话模型)结合一个冻结视觉编码器,实现了许多接近GPT-4 Vision的图文能力,例如详细的图像描述、根据手绘草图生成网页等高级多模态功能。这表明选择一个强大的中等规模语言基座(如LLaMA2-13B或Mistral-7B)并与视觉模块高效结合,能够打造出功能强大的小型多模态系统。

- 新兴开源基础模型:2023年大量开放的中小规模基础模型值得关注。例如Meta的LLaMA2-7B/13B、Mistral AI的Mistral-7B、以及Falcon-7B等。这些模型通过更好的训练策略和架构改进,在相对较小参数量上实现了高度性能:特别是Mistral-7B在各项基准上全面超越了LLaMA2-13B,甚至与未公开的LLaMA 34B性能相当。因此在需要构建对话生成类应用时,选择此类7B-13B等级的小模型进行指令微调或对齐(如RLHF)是务实的方案——既可达到接近GPT3.5/4的能力,又能在本地或专用服务中部署。

综上,基座模型的选择应综合考虑参数规模、预训练水平和社区支持。一个恰当的小模型起点,加上前述蒸馏和数据策略,往往比贸然训大模型事半功倍。

低算力部署实践经验

在本地设备或云端有限算力环境下部署模型,需要结合软硬件优化,让小模型充分发挥效率优势:

- 模型量化:将模型权重从浮点数压缩为低比特表示(如8-bit甚至4-bit整数),可极大减少内存占用和加速推理。实践证明,针对大型Transformer的量化能在基本不损失精度的前提下大幅降低资源需求。例如LLM.int8和GPTQ等方案将13B模型量化为8-bit或4-bit后,可在单张GPU甚至CPU上流畅运行。最新的SqueezeLLM框架更实现了3-bit的超低精度量化且近乎无精度损失——在LLaMA-30B上3-bit量化后,相比FP16基线困惑度提升不足2%,但显存占用下降8倍,推理速度提升2.3倍。这使得在消费级硬件上部署数十亿参数模型成为可能。很多工业部署会利用ONNX Runtime、TensorRT等工具对模型进行INT8量化,加速CPU/GPU推理。

- 高效推理引擎:选择优化良好的推理框架。例如CPP实现的

llama.cpp项目专为在多种硬件上高效运行LLM而设计。它支持Apple Silicon加速、x86指令集优化,以及1.5-bit至8-bit的灵活量化来减少内存并加快推理。使用llama.cpp,一个7B参数的模型在笔记本CPU上即可实时对话。这类高效引擎结合小模型,显著降低了部署门槛。此外,移动端可采用Core ML、TensorFlow Lite等针对ARM架构优化的引擎,将例如语音识别、小型NLP模型嵌入APP离线运行。实践经验表明,充分利用推理加速库和低精度算子,往往比直接跑原始模型快数倍且更省电。 - 蒸馏后端部署:在部署阶段进一步对模型进行蒸馏或剪枝也是可行的。例如先训练一个功能强的大模型,再以其为教师对一个小模型进行蒸馏专门针对部署环境优化。微软等公司的实战报告提到,通过在任务数据上蒸馏出一个小模型用于线上服务,可将延迟降低到原来的几分之一,同时服务指标几乎不变。这种“两阶段模型”架构在工业界并不罕见:在线上由小模型实时响应,在后台定期用大模型更新小模型(蒸馏)以保证性能。这样结合了大模型的精度和小模型的效率。

- 其余优化:包括模型裁剪后的稀疏加速、批量推理、缓存层输出结果等。在多模态部署中,还可以按需裁剪掉不使用的模态分支以减小模型。例如只需文本输出的场景,可冻结并裁剪掉视觉编码部分。再比如启用GPU/NPUs异构计算(如CPU跑embedding层,GPU跑Transformer层)来平衡负载。这些技巧在实际工程中需要根据硬件配置调整,但目的都是充分榨取小模型在有限资源下的性能潜力。

小模型要实现对大模型的性能逼近甚至超越,离不开模型结构优化+蒸馏迁移+数据策略+优秀基座+部署优化的通力配合。近年的趋势表明,通过上述多管齐下的措施,小模型在越来越多场景下达到“用小模型解决大问题”的实用效果。从开源社区的Mistral-7B、Alpaca,到工业界的定制小模型服务,无不验证了小模型路线的巨大价值。在可预见的未来,随着业界在架构创新、蒸馏算法、高效训练和优化部署方面的持续发力,尤其是DeepSeek的几个蒸馏模型的惊艳效果,让我们有理由期待小模型进一步缩小与巨型模型的差距,甚至在特定领域实现超越。对于企业和开发者而言,掌握并善用这些新技术,就能以更低的算力成本,更快地将AI模型落地到真实应用中。

留下评论