简介

- 大型语言模型(LLM)已通过图灵测试,GPT-4.5 在测试中被误认为是人类的超过73% 。

- 证据倾向于支持 LLM 具备类似人类的对话能力,但争议在于这是否反映真正的智能。

- 图灵测试可能更多衡量“人性化”而非深度理解,批评者认为其存在局限性。

什么是图灵测试?

图灵测试就像一场“谁是卧底”的游戏。它的创始人是计算机科学的“鼻祖”艾伦·图灵。他在 75 年前提出了一个“模仿游戏”:

- 一个人类测试员通过打字聊天,同时跟两个藏起来的家伙聊天。

- 其中一个是真人,另一个是AI 机器人。

- 俩人都得拼命装自己是人类,让测试员猜不出谁是 AI。

- 如果测试员老是猜错,分不清哪个是真人,那就说明这台AI 通过了图灵测试,说明它聪明得跟人类差不多了!

一直以来,图灵测试都被看作是衡量 AI 有多“像人”的重要标准。能通过它,简直是 AI 界的最高荣誉!

LLMs 首次成功“瞒天过海”

前不久,加州大学圣地亚哥分校(UCSD) 的研究团队就做了这么一项实验。他们设计了一套严谨的“三方图灵测试”,让测试员同时和一个人、一个 AI 聊天 5 分钟,然后判断哪个是真人。他们测试了四种 AI:

- GPT-4.5:当时最厉害的 AI 模型之一。

- LLaMa-3.1-405B:一个参数超级多的强大模型。

- GPT-4o:一个还不错的模型,用来做比较。

- ELIZA:一个很老的聊天机器人,看看“老家伙”表现咋样。

为了让 AI 更像人,研究人员还给 GPT-4.5 和 LLaMa-3.1 设计了两种“人设”:

- “没人设”模式:就告诉 AI 它的目标是装人类,给了一些基本的背景信息。

- “有人设”模式:让 AI 扮演一个19 岁、有点内向、懂网络梗、爱说“潮语”、还不喜欢用句号的年轻人。这个“人设”可是研究人员事先测试过,发现效果最好的!为了更逼真,还引导 AI故意打错字,用点网络流行语,避免说话太完美。

结果简直让人大吃一惊:

- 开了“有人设”的GPT-4.5,竟然有73% 的时间被认为是真人!这比例不仅远远高于瞎猜的 50%,甚至比测试员选出真人的比例还要高!也就是说,在某种程度上,“戏精” GPT-4.5 比真人更像真人!

- 同样开了“有人设”的LLaMa-3.1,也有56% 的时间被认为是真人。这说明很多人已经很难分清它和真人了。

- 而“老古董”ELIZA和没开“人设”的GPT-4o,就比较惨了,被认为是真人的概率只有23% 和 21%,一看就是机器人。

- 没开“人设”的GPT-4.5和LLaMa-3.1表现也差了一截,只有36% 和 38%的时间被认为是真人。

按照图灵测试的标准,只要让人分不清,就算通过了。所以,这项研究首次证明,当有了合适的“人设”后,GPT-4.5 和 LLaMa-3.1 真的能通过图灵测试!特别是 GPT-4.5,简直是“影帝”级别的表现!

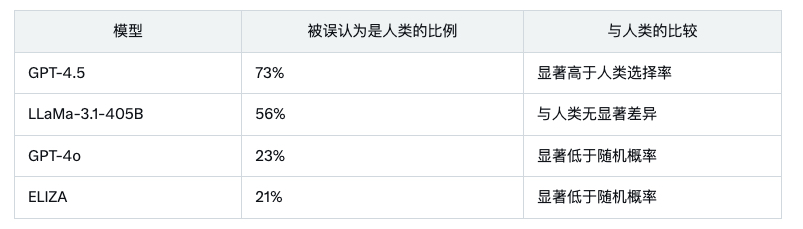

这项研究成果于2025 年 3 月 30 日发布,UCSD的卡梅隆·琼斯和本杰明·伯根在arxiv上发表了论文《大型语言模型通过图灵测试》(Large Language Models Pass the Turing Test study from UC San Diego)详细阐述了实证证据,结论是LLM 通过了图灵测试。该研究的关键发现如下:

- 当提示采用人性化角色时,GPT-4.5 被误认为是人类的比例达 73%,显著高于真实人类参与者的选择率。

- LLaMa-3.1-405B 的比例为 56%,与人类无显著差异,表明其对话能力已接近人类。

- 基线模型 ELIZA 和 GPT-4o 的表现较差,分别仅为 23% 和 21%,低于随机概率。

这项研究是首次实证证明人工系统通过标准三方图灵测试的证据,对 LLM 智能的辩论及其社会经济影响具有重要意义。

另一项 2024 年 6 月的报道显示,GPT-4 在类似设置中被误认为是人类的比例为 54%(GPT-4 has passed the Turing Test, researchers claim | Live Science)。此外,AI21 Labs 在 2023 年的在线实验“Human or Not?”吸引了 200 万用户参与 1000 万次游戏,32% 的参与者无法区分人类和机器(Large Language Models Pass the Turing Test — EA Forum)。

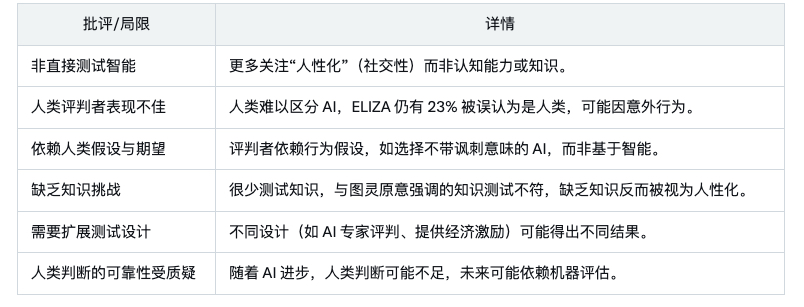

通过测试又怎样?

尽管这些发现引人注目,但图灵测试作为智能衡量标准的有效性广受争议。2025 年 4 月 4 日的 ZDNET 文章指出,GPT-4.5 的表现暴露了图灵测试的局限性(The Turing Test has a problem – and OpenAI’s GPT-4.5 just exposed it | ZDNET)。主要批评包括:

Hacker News 的讨论也质疑该研究的有效性,指出参与者可能未尽力识别 AI,可能因仅为赚取学分而参与(UCSD: Large Language Models Pass the Turing Test | Hacker News)。这强调了参与者动机对实验结果的重要性。

引发的其它思考:

- “社牛”更吃香?研究发现,测试员判断时,更看重的是聊天语气是否自然、对话是否流畅、有没有独特的个性和真情实感,而不是知识多不多或者逻辑强不强。有时候,AI 表现得“傻”一点、“不完美”一点,反而更像人类。

- “剧本”很重要!这次 AI 能成功,很大程度上是因为人类给它们设计了特定的角色和说话方式。这说明现在的 AI 很灵活,能根据人类的指示改变自己的行为模式,模仿不同的人。

- 图灵测试过时了吗?有人觉得 5 分钟的测试时间太短,可能没法完全暴露 AI 的缺点。但也有人认为,图灵测试这种互动式的评估方法,对现在的 AI 评估体系来说仍然很有价值。

- 测的是“像人”而不是“真聪明”?研究人员认为,现在的图灵测试与其说是测 AI 有多聪明,不如说是测它有多像人类,能不能在社交场合不被发现。

AI 这么像人,未来会怎样?

- “打工人”要小心?在那些需要简单人际交流的领域,比如客服、在线咨询、社交媒体互动等,AI 可能会逐渐替代或补充人类的工作。

- 真假难辨的网络世界?以后和你在网上聊天的人,可能真假难辨,这可能会影响我们之间的信任和社交方式。

- 潜在的风险?如果 AI 太会“装人”并获得信任,一旦被坏人利用,可能会被用于欺骗、诈骗、传播谣言等坏事。所以,我们需要尽快建立相关的规则和技术手段来防范这些风险。

面对越来越像人类的 AI,你准备好了吗?你觉得人类最独特的价值是什么呢?LLM 通过图灵测试的能力具有深远影响。它挑战了传统对机器智能的看法,引发了关于意识、社会影响和伦理考虑的讨论。例如,如果 LLM 可信地模仿人类,这可能影响工作自动化、社会互动和数字通信的信任。2025 年 3 月的研究指出,随着 AI 发展,需要新的评估方法。

未来研究可能扩展图灵测试,包括知识挑战、使用专家评判或开发替代智能基准。ZDNET 文章提到,随着 AI 进步,人类判断可能不足,可能需要类似科幻中的 Voight-Kampff 测试的机器评估系统(The Turing Test has a problem – and OpenAI’s GPT-4.5 just exposed it | ZDNET)。

当然,本项测试的局限性(如关注人性化而非智能)需谨慎解读。围绕图灵测试的争议强调了需要更全面的评估方法,以理解 AI 能力及其社会影响。

总而言之,这次大型语言模型通过图灵测试,是人工智能发展的一个重要里程碑。它让我们重新思考什么是“智能”,人与机器的关系将如何发展,以及在这个 AI 日益强大的世界里,我们人类应该如何自处。

留下评论