【本系列博文读者对象:对AI感兴趣的哲学社会人文学科的研究人员、相关学科研究生、文科科研管理人员】

第十五章:“黑箱”世界的“可重复性危机”:我们能信任专有LLM的研究吗?

回答问题:“黑箱”AI如何从根本上挑战科学研究的可重复性原则?

科学知识的基石在于其“可重复性”(replicability)——即不同的研究者在遵循相同方法的情况下,应能得到相同或相似的结果。然而,近年来,从心理学到医学,许多学科都深陷一场“可重复性危机”的泥潭,大量已发表的研究成果被发现难以复现,动摇了公众对科学的信任 73。正当学界艰难应对这场危机之时,大语言模型的兴起,尤其是那些由少数科技巨头掌控的、内部机制不透明的“专有LLM”(proprietary LLMs),正带来一场潜在的、更为严峻的挑战,可能使这场危机雪上加霜。

问题的核心在于科学的开放性与商业技术的封闭性之间的根本矛盾。科学研究的核心原则之一是透明度:研究者必须详细公开其研究方法、数据和工具,以便同行进行审查和验证 76。然而,目前性能最强大的LLMs,如OpenAI的GPT-4系列或Anthropic的Claude系列,都是“黑箱”模型。它们的具体架构、完整的训练数据集、以及复杂的训练过程,都属于公司的核心商业机密,外界无法得知 1。

当社会科学家越来越多地将这些强大的“黑箱”作为研究工具时,一个致命的问题便出现了。一个研究者可能在论文中精确地记录了他/她使用的模型名称(例如,“GPT-4”)、实验日期以及所有使用的提示语(prompts)。然而,当另一位研究者试图在六个月后重复这项研究时,几乎注定会失败。原因在于,尽管他们访问的API(应用程序编程接口)端点名称仍然是“GPT-4”,但其背后的实际模型很可能已经被其母公司悄无声息地更新了数次。这种持续的、不透明的更新,引入了一种全新的、隐蔽的“方法论漂移”(methodological drift)。

这种“漂移”对科学的可重复性构成了致命威胁:

1. 实验工具的易逝性:传统科学实验的工具(如显微镜或调查问卷)是稳定和可控的。而专有LLM作为一个研究工具,其在特定时间点的特定状态是“短暂”且“不可保存”的。这意味着,一项基于特定版本LLM的研究,在模型更新后,就从根本上变得无法精确重复。

2. 结果的不可归因性:当一项重复实验失败时,我们无法判断失败的原因是原始研究存在缺陷,还是仅仅因为模型本身发生了变化。这使得科学的自我修正机制——即通过重复实验来甄别和淘汰错误结论——变得难以奏效。

3. 知识积累的中断:如果基于这些工具的研究发现是不可重复的,那么科学知识的累积性就受到了威胁。研究可能退化为一系列孤立的、无法相互验证的“快照”,而不是一个能够稳步建立和发展的知识体系。

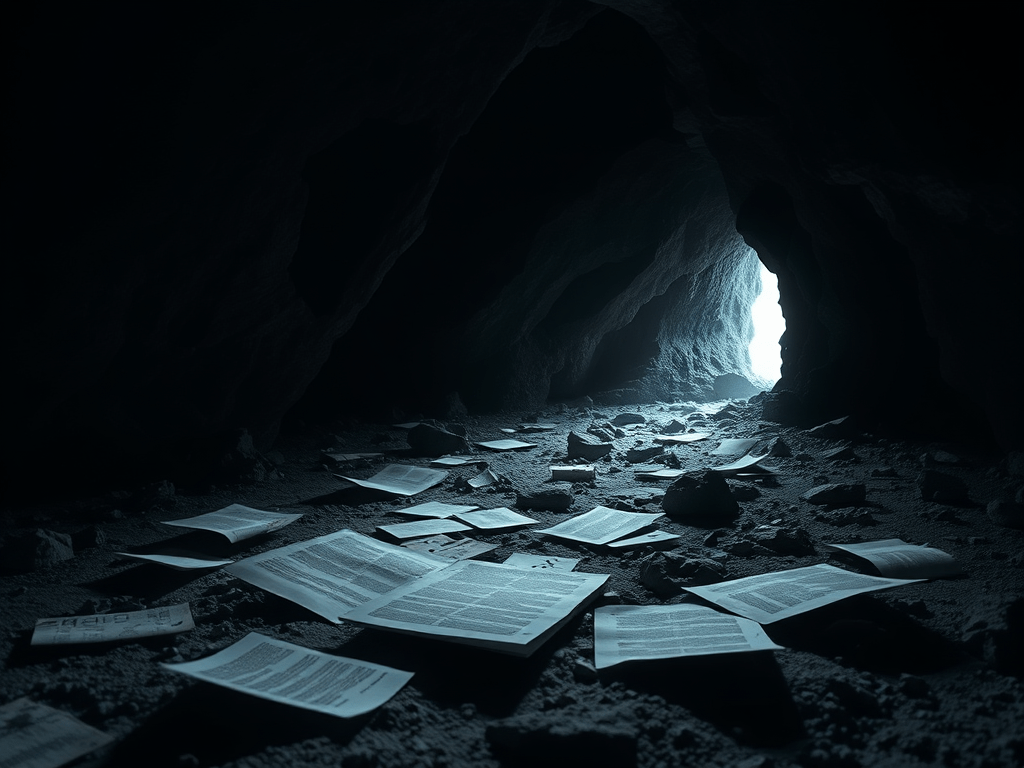

这种状况引起了研究界的严重关切。许多学者和机构,如AI Now研究所,指出这种不透明性不仅是技术问题,更是大型科技公司巩固其市场力量、规避外部问责的一种策略 72。为了应对这一挑战,学术界发出了强烈的呼吁,要求提高模型的透明度,并大力支持“开源LLM”的发展 1。只有当研究者能够访问和控制其研究工具的稳定版本,并了解其基本构成时,基于LLM的社会科学研究才能建立在坚实和可信的基础之上。否则,我们可能会发现自己在一个由算法驱动的、不断变化的“流沙”之上,试图建造一座名为“科学”的大厦。

留下评论