最近英伟达市值创下纪录,黄教主虽然失去了东大市场,失之东隅得之桑榆,赶上了“量子计算”一波热炒,虽然当初因为低估造成“量子大跌”。

但量子计算与并行计算(黄教主给了个含金量十足的名字“加速计算”)到底什么关系?这里粗浅地白活白活。

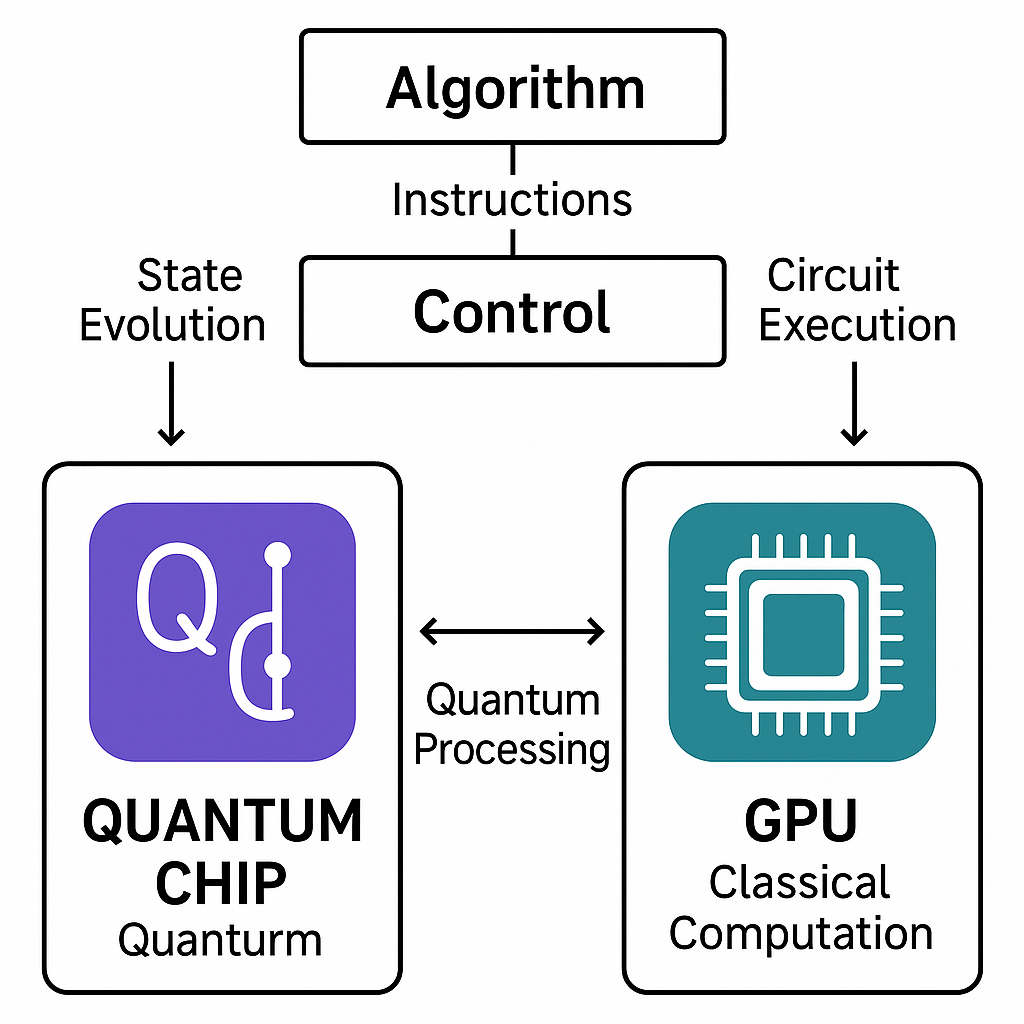

量子计算(Quantum Computing)与GPU(图形处理器,Graphics Processing Unit)本身分属不同计算范式:前者基于量子叠加与纠缠,后者属于经典并行计算架构。但在现实中,它们之间的结合却非常紧密,特别是在量子计算的模拟、编译与混合计算阶段。下面分步解释为什么量子计算要用到GPU。

一、量子计算机仍然“太小”,需要经典计算机辅助

目前的量子芯片(如IBM、Google、阿里达摩院、华为HiQ等)都只有几十到几百个量子比特。

但即使模拟几十个理想量子比特,计算量也会随比特数指数级增长(2ⁿ)。

例如:

- 模拟 30 个量子比特需要存储约 16 GB 的状态向量;

- 模拟 40 个量子比特需要约 16 TB;

- 模拟 50 个量子比特,经典计算几乎不可能完成。

因此,研究者用GPU来在经典计算机上“模拟”量子态演化,例如:

- NVIDIA 的cuQuantum SDK能用 GPU 加速量子线路模拟;

- Google Cirq、IBM Qiskit 也能调用 GPU 后端;

- GPU 并行矩阵乘法能力强,能高效计算量子门的张量运算。

👉简言之:在真正的量子计算机可用之前,GPU 是“量子计算的训练轮”。

二、量子计算的“编译”和“优化”本身需要大量并行计算

量子算法要在真实量子芯片上运行,必须经过量子编译器(Quantum Compiler)转换成底层可执行的量子门序列。

这个过程涉及:

- 电路优化(Circuit Optimization)

- 参数搜索(Parameter Tuning)

- 噪声建模(Noise Simulation)

这些都非常耗时、计算量庞大。GPU 的并行矩阵计算和矢量化优化正好适合这些任务。

例如:

- 量子编译器使用 GPU 加速求解大规模优化问题;

- 量子化学和量子机器学习任务往往依赖 GPU 做经典部分的梯度下降;

- 在变分量子算法(VQE, QAOA)中,经典优化器通常运行在 GPU 上。

👉 换句话说:GPU 是“量子算法与量子硬件之间的桥梁”。

三、GPU 在“混合量子-经典架构”中承担关键角色

目前工业界主流的做法是Hybrid Quantum-Classical Computing(混合量子-经典计算),即:

- 量子芯片负责计算难以并行化或具有量子加速潜力的部分;

- GPU/CPU 负责执行经典优化、梯度更新和数据预处理部分。

例如:

- 量子神经网络(QNN)、量子强化学习中,GPU 负责反向传播;

- 量子化学计算中,GPU 负责积分计算与波函数近似;

- NVIDIA 推出的DGX Quantum平台,将 Grace Hopper 超级芯片与量子处理单元(QPU)通过 NVLink 直接连接,实现量子-经典协同。

👉GPU 是量子-经典“协同计算”的大脑,帮助量子计算机发挥最大效能。

四、未来趋势:GPU 不仅是“模拟器”,还是“调度器”

随着量子计算进入分布式量子云时代,GPU 将进一步承担:

- 多量子设备的任务调度与资源分配;

- 跨量子节点的状态融合;

- 大规模量子网络仿真。

NVIDIA、AMD、Intel 都已在布局“量子+GPU 超算平台”,目标是让 GPU 成为量子-经典异构超算的中心控制器。

✳️ 总结

| 阶段 | GPU 的作用 | 典型例子 |

|---|---|---|

| 量子模拟 | 模拟量子态演化 | NVIDIA cuQuantum、Qiskit Aer |

| 量子编译 | 优化量子门序列 | Cirq + GPU 优化器 |

| 混合计算 | 执行经典优化任务 | VQE/QAOA 算法 |

| 量子云调度 | 任务分配与集群仿真 | DGX Quantum、Quantum Cloud SDK |

留下评论