本号刚总结完2025智能体领域进展,Langchain便发表了一份基于扎实调查的报告,有很多发现可圈可点。这里总结如下。

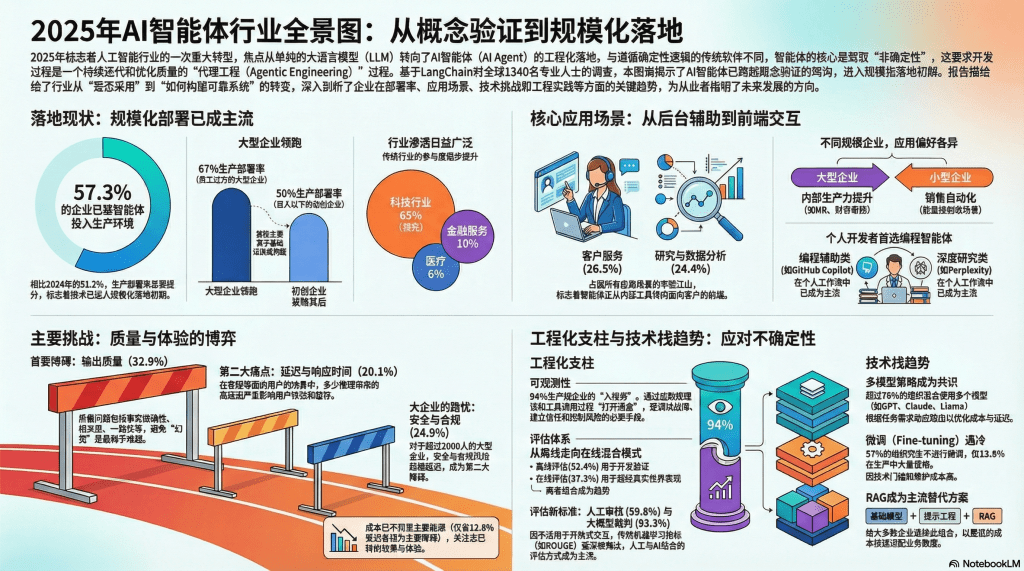

主要结论:2025年标志着人工智能行业重心的根本性转移——从单纯的大语言模型(LLM)狂热,转向了智能体(AI Agent)的工程化落地。LangChain 团队近期对全球 1340 名专业人士进行的深度调查显示,企业关注的焦点已从“是否采用 Agent”转变为“如何构建可靠、高效且可扩展的 Agent 系统”。本文将基于该调查数据,详细剖析 Agent 的落地现状、核心应用场景、面临的技术挑战以及工程化实践的关键趋势。

一、“智能体工程”时代已经到来

回顾过去三年,AI 行业经历了大模型的爆发(2023年)和工具链的整合(2024年),而在2025年,行业正式迈入了“代理工程(Agentic Engineering)”时代。与传统软件开发不同,代理工程的核心在于驾驭“非确定性”。传统软件遵循“输入A必得结果B”的确定性逻辑,而 AI Agent 则根据上下文和工具调用结果动态调整决策路径。

这种非确定性特征决定了代理工程不是一次性的开发任务,而是一个持续迭代、打磨质量的过程。调查显示,绝大多数从业者已意识到,要将大模型转化为可靠的系统,必须在系统设计、工具集成和故障排查上投入巨大的工程努力。

二、 规模化部署的加速与分化

1. 生产环境部署成为主流

本次调查最显著的发现是 Agent 生产部署率的飞跃。数据显示,57.3%的受访组织已将 Agent 投入生产环境,这一比例较 2024 年的 51.2% 有了显著提升。与此同时,仅处于探索阶段的企业比例从 19.7% 下降至 12.3%,。这表明,Agent 技术已跨越了概念验证(PoC)的鸿沟,正式进入规模化落地初期。

2. 大型企业的“马太效应”

在落地进程中,企业规模成为了一个关键的分水岭。员工规模在 1 万人以上的大型企业中,高达67%已实现生产部署,而百人以下的初创企业这一比例为 50%,。这种差异主要源于基础设施的成熟度。大型企业在平台建设、安全性及可靠性基础设施上拥有更深厚的积累,使其能更快地将试点项目转化为稳定的生产系统。相比之下,初创企业虽开发意愿强烈,但在从 Demo 到 Production 的跨越中面临更多资源限制。

3. 行业渗透的广泛性

从行业分布来看,科技行业以 63% 的占比遥遥领先,这符合其技术敏感度高的特点。然而,金融服务(10%)、医疗(6%)、教育及制造业等传统行业的参与度也在稳步提升,。这说明 Agent 正从科技圈的“玩具”转变为各行各业的生产力工具。

三、 应用场景演变:从后台辅助到前端交付

调查揭示了 Agent 应用场景的深刻变化:企业正逐渐通过 Agent 重塑客户交互与内部流程。

1. 两大核心场景:客服与数据分析

客户服务(26.5%)和研究与数据分析(24.4%)占据了所有主要部署场景的半壁江山,。

- 客户服务:这一场景的登顶标志着 Agent 已从内部辅助工具转向直接面向客户的前端工具。企业利用 Agent 处理标准化程度高的服务需求,以降低人工成本并提升响应速度,。

- 数据分析:Agent 擅长处理海量信息和跨源推理,能够有效解决人工处理数据耗时且易遗漏的问题,成为知识密集型任务的首选助手,。

2. 企业规模决定的应用偏好

不同规模的企业在场景选择上表现出截然不同的优先级:

- 大型企业(10k+员工):首选内部生产力提升(26.8%),如 HR 简历筛选、财务报销审核等,。大企业组织架构复杂,优化内部流程带来的规模化收益远超小企业,因此它们倾向于“先内后外”。

- 小型企业:更倾向于直接产生营收或获客的场景(如销售自动化),追求立竿见影的投入产出比。

3. 个人开发者的日常选择

在个人层面,编程智能体(Coding Agents)如 Cursor、GitHub Copilot 等已主导日常工作流。其次是用于探索新领域的深度研究 Agent(如 Perplexity)。此外,基于 LangChain 构建的定制化内部工具(如自动化测试、知识库查询)也日益普及,,。

四、 核心挑战:质量与延迟的博弈

尽管落地迅速,但在将 Agent 推向生产的过程中,企业仍面临严峻挑战。

1. 输出质量:最大的“拦路虎”

32.9%的受访者将“输出质量”列为首要障碍。这里的质量不仅指事实准确性,还包括相关性、一致性、语态合规性等。对于大型企业而言,如何在大规模上下文中避免“幻觉”并保持输出一致性,是目前最棘手的难题,。由于 Agent 的非确定性,同一输入可能产生不同输出,这在金融、医疗等高合规要求行业是不可接受的风险。

2. 延迟与响应时间:用户体验的痛点

20.1%的受访者对延迟表示担忧,这一问题在面向用户的场景(如客服)中尤为突出,。这反映了工程设计中的核心权衡:更智能的 Agent 往往需要进行多步骤推理和多次工具调用,但这必然导致响应变慢。对于缺乏基础设施优化能力的小型企业,延迟问题直接影响用户留存。

3. 安全与合规:大企业的隐忧

对于 2000 人以上的大型企业,安全与合规(24.9%)超过延迟成为第二大障碍,。随着 Agent 深入核心业务,数据泄露和违规操作的风险呈指数级上升。

值得注意的是,成本管理的关注度较往年明显下降(12.8%)。模型价格的持续走低和效率的提升,使得企业不再将原始支出视为主要瓶颈,转而更关注效果与体验,。

五、 工程化支柱:可观测性与评估体系

为了应对上述挑战,企业正在构建以“可观测性”和“评估”为核心的工程体系。

1. 可观测性(Observability):从可选项变为必选项

报告将可观测性称为 Agent 开发的“入场券”(Table Stakes)。89%的组织已实施了某种形式的可观测性,而在生产级企业中,这一比例更是高达94%,。由于 Agent 决策过程如同“黑盒”,缺乏可观测性意味着无法追踪推理链和工具调用过程。一旦出现故障(如理解错误、工具调用失败),团队将无法进行有效调试。可观测性工具通过“打开黑盒”,帮助工程师建立信任并控制风险。

2. 评估(Evaluation):正在追赶的关键能力

相比可观测性,评估体系的建设相对滞后,但正在快速成熟。

- 混合评估模式:约四分之一的团队采用“离线+在线”的混合评估策略。离线评估(52.4%)用于开发阶段的基本验证,在线评估(37.3%)用于监控真实世界的表现,,。

- 评估指标的革新:传统的机器学习指标(如 ROUGE、BLEU)因不适用开放式交互而逐渐被抛弃(仅16.9%采用)。取而代之的是人工审核(59.8%)和大模型裁判(LLM-as-a-Judge, 53.3%)。前者保证深度和细致度,后者解决规模化和标准化问题,。

六、 技术栈趋势:多模型与反微调

在基础设施选择上,企业表现出了明显的实用主义倾向。

1. 多模型策略(Multi-Model)

单一模型统治的时代已经结束。尽管 OpenAI 的 GPT 模型使用率高达 67.8%,但超过四分之三的组织在开发或生产中混合使用多个模型,。企业根据任务需求(如复杂推理用 Claude/GPT-4,简单任务用开源模型)动态路由,以优化成本、延迟并降低供应商锁定风险。Google Gemini、Anthropic Claude 以及开源模型(如 Llama、Mistral)均占据了重要市场份额,。

2. 微调(Fine-tuning)的遇冷与 RAG 的兴起

与市场热度相反,微调并未成为主流。57% 的组织完全不进行微调,仅 13.8% 在生产中大量使用,。微调的高门槛(数据标注、训练设施、维护成本)使其仅适用于极少数特定场景。绝大多数企业选择了性价比更高的路径:基础模型 + 提示工程 + 检索增强生成(RAG)。这种组合既能快速适配业务数据,又避免了沉重的维护负担。

七、 结论与展望

2025年的调查报告清晰地描绘了 AI Agent 从“新奇技术”走向“工业基础设施”的轨迹。

- 规模化已成事实:大企业凭借基础设施优势领跑,Agent 已深入客服、数据分析及内部流程优化等核心业务。

- 可靠性是核心命题:面对输出质量及延迟的挑战,建立完善的可观测性和评估体系已成为企业部署 Agent 的必要条件。

- 技术路线务实化:企业不再盲目追求单一最强模型或昂贵的微调,而是转向多模型路由和 RAG 架构,追求最佳的效能与成本平衡。

虽然“Agentic Everything”(万物代理化)的时代尚处于早期阶段,但随着代理工程方法论的成熟,AI Agent 正逐步构建起新一代智能软件的基石。对于企业而言,现在的关键不再是犹豫是否入局,而是尽快建立起支持 Agent 持续迭代与评估的工程能力。

参考来源:本综述基于 LangChain "State of AI Agents" 报告文本及相关视频解读整理而成。所有数据引用均对应源文件中的段落索引。

留下评论