前言

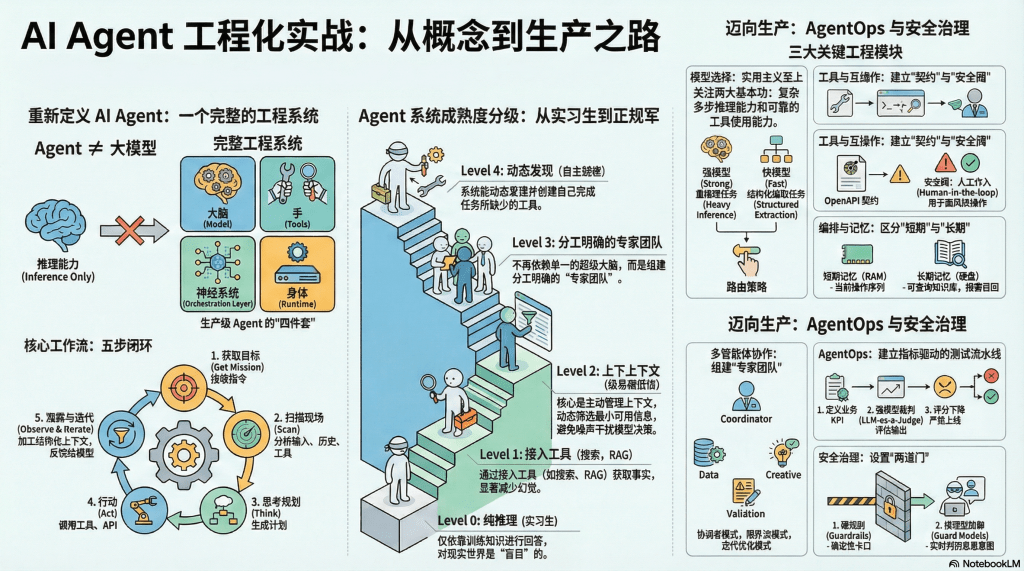

在过去的一年里,AI Agent(智能体)无疑是技术圈最热门的词汇。从简单的“Tool-using LLM”到复杂的“Agentic Workflow”,无数开发者在探索如何让大模型在真实世界中稳定地工作。然而,随着 Demo 变成产品,行业痛点也从“能不能跑通”变成了“能不能稳定运行”。

近日,Google 与 Kaggle 联合发布了一套重量级的《Introduction to Agents》系列白皮书(共五篇),并配套了 Google ADK (Agent Development Kit) 和 Vertex AI 的最新实践。这不仅是一套技术文档和教程,更像是 Google 试图为混乱的 Agent 开发领域制定的一套“行业标准”。

当我们把目光投向整个行业,会发现Anthropic、OpenAI、LangChain等巨头也都在同一张棋盘上落子。它们或许叫法不同——Agentic Workflow、Tool-using LLM或是Assistant,但本质都在解决同一个核心命题:如何让一个“无状态”的模型,在复杂的真实世界里长期、可靠地运行?

本文将按“工程栈分层”的视角,以Google的工程栈为坐标系,将 Google 的这套方法论与 Anthropic、OpenAI、LangChain 等主流玩家的方案进行“同构对齐”。深度解析各家大厂在架构、协议、评估与运维上的异同,为您呈现一张清晰的Agent技术路线图。通过对比,我们试图回答一个问题:在 Agent 的标准化进程中,巨头们各自把边界画在了哪里?

一、 工程地图:从“拼接字符串”到“软件工程”

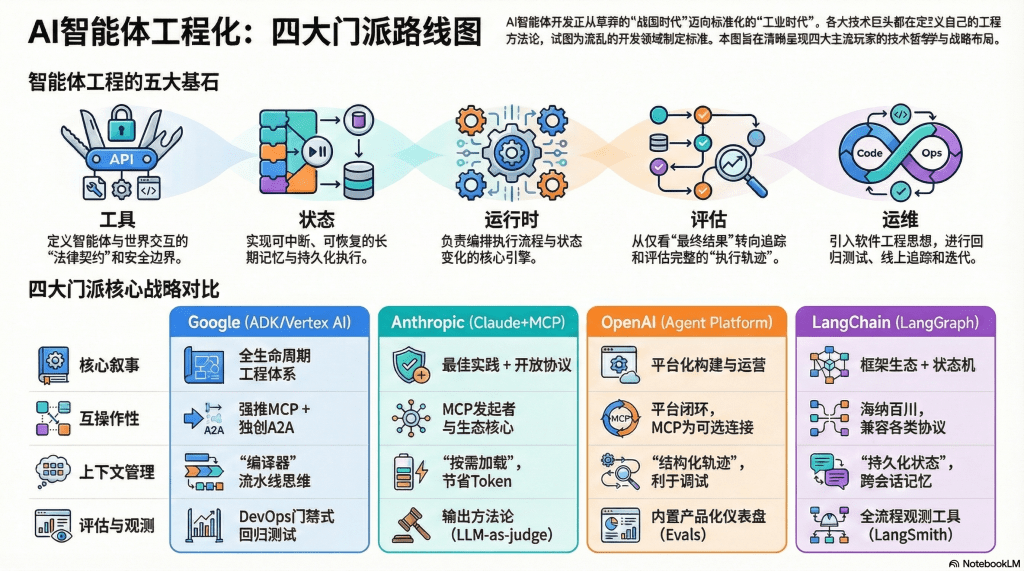

不管各家厂商如何包装概念,Agent的工程本质必须引入五个核心要素:工具(Tools)、状态(State)、运行时(Runtime)、评估(Evaluation)与运维(Ops)。

各家对于这些要素的理解,决定了其技术路线的差异:

- Google (ADK/Vertex AI):走的是严谨的软件工程路线。Google明确提出,Context(上下文)不应只是简单的字符串拼接,而是一个对结构化状态的“编译视图(Compiled View)”。运行时负责编排执行与状态变化,像管理传统软件一样管理Agent。

- LangChain (LangGraph):将“状态”视为一等公民。其核心理念是Durable Execution(持久化执行),强调工作流的可中断、可恢复、以及Human-in-the-loop(人在回路)的交互能力。

- OpenAI (Agents SDK):侧重于产品的可观测性。他们将Agent的运行抽象为“轨迹(Trajectory)”,内置了Tracing、Handoff(交接)和Guardrails(护栏),配合仪表盘供开发者进行调试与线上观测。

- Anthropic (Claude):致力于协议标准化。一边强推MCP(Model Context Protocol)作为开放标准,一边在平台侧强化Tool Use的严格Schema和并行能力,强调在多智能体系统中“过程与结果并重”。

二、 行业共识:大家都在解决什么难题?

尽管路线不同,但头部玩家在“Agent = 模型 + 工具 + 编排 + 运行时 + 评估运维”这一公式上已达成高度共识,尤其是在以下两个痛点上:

1. 工具契约:从“函数调用”到“权限边界”

过去我们认为Agent调用工具只是简单的Function Call,但现在各家都意识到,工具是安全与业务的边界。

- Anthropic推出了Strict Schema,确保模型输出严格匹配参数。

- OpenAI在Agent Builder中强调,使用MCP工具必须配合“工具审批(Tool Approvals)”和安全护栏。

- Google 和 LangChain 同样将工具视为“审计点”,强调输入输出规范和权限控制。结论: 工具不再是代码片段,它是Agent与世界交互的“法律契约”。

2. 评估体系:从“看结果”转向“看轨迹”

只看最终答案对错已经不够了,开发者需要知道Agent是“怎么做出来的”。

- OpenAI和LangSmith都建立了详细的Tracing机制,记录每一次工具调用、每一次Guardrail拦截。

- Google提出将Context构建视为可测试的流水线。

- Anthropic在多智能体研究中强调,评估必须允许“条条大路通罗马”,只要过程合理即为通过。

三、 关键分歧:Google的“工业规范” vs 诸侯割据

通过Google发布的五篇白皮书主线(架构→互操作→上下文→质量→生产),我们可以清晰地看到各家策略的分野。

差异 1:互操作性——MCP与A2A的双层博弈

这是Google架构中最具特色的一点。Google将互操作性明确切分为两层:

- 下层互操作(MCP):解决Agent如何连接外部工具和数据。Google完全支持Anthropic发起的MCP标准。

- 上层互操作(A2A, Agent to Agent):解决Agent之间如何协作。Google明确指出,A2A与MCP互补,前者负责“找同伴、分工”,后者负责“拿工具、干活”。

对比来看:Anthropic更专注于把MCP这一层做深做透;OpenAI则更倾向于打造自家的闭环平台,MCP只是可选的连接层;而LangChain则是“海纳百川”,提供框架适配各种协议。

差异 2:上下文工程——“编译器” vs “状态机”

- Google将上下文工程比作编译器管线:Session是源数据,通过Processor编译,最终生成发给模型的Working Context。这是一种非常“硬核”的工程思维。

- LangGraph将其视为有状态图:强调循环、分支和记忆的持久化。

- Anthropic强调按需加载:警告开发者不要把成百上千个工具一股脑塞进Prompt,而应动态发现与装载,以节省Token。

差异 3:质量与评估——“产品化” vs “门禁化”

- OpenAI & LangSmith的方案非常产品化,直接提供仪表盘、在线Debug工具和可视化界面,对开发者最友好。

- Google的方案更像CI/CD门禁,强调在代码合并前用“黄金数据集”跑回归测试,带有浓厚的DevOps色彩。

- Anthropic则输出方法论,教导开发者如何从小样本开始,利用LLM-as-judge进行评分。

差异 4:运行时——云原生 vs 自由组装

- Google依托Google Cloud,提供从底层Runtime到上层托管的一条龙服务。

- LangChain给你自由,支持自建云或混合部署。

- OpenAI提供“平台+SDK”的半托管模式。

四、 全景对照表:一图看懂四大流派

| 维度 | Google (ADK/Vertex) | Anthropic (Claude+MCP) | OpenAI (Agent Platform) | LangChain (LangGraph) |

|---|---|---|---|---|

| 核心叙事 | 全生命周期工程体系 (强调云原生与规范) |

最佳实践+开放协议 (强调模型能力与MCP) |

平台化构建与运营 (Builder+SDK+Evals) |

框架生态 (编排+状态机+观测) |

| 工具互操作 | 强推MCP | MCP发起者,生态核心 | SDK支持MCP,侧重审批流 | 兼容MCP,作为连接器 |

| 多智能体 | A2A (Agent2Agent) 明确与MCP分层 |

提供Prompt策略与方法论 | Handoff/工作流为核心能力 | 图编排原生适配多Agent |

| 上下文管理 | 编译视图 (Compiled View) 流水线思维 |

按需加载 (On-demand) 避免Token膨胀 |

结构化轨迹 利于调试迭代 |

持久化状态 (Durable) 跨会话记忆 |

| 评估/观测 | AgentOps 强调工程门禁与回归 |

LLM-as-judge 强调过程评估方法 |

内置闭环 Tracing+Grading+Evals |

产品化工具链 LangSmith全流程覆盖 |

结语:如何用Google的“尺子”丈量你的Agent?

Google这套《Introduction to Agents》白皮书的价值,不仅在于它推广了Google自家的Vertex AI,更在于它提供了一份详尽的“验收清单”。

无论你现在使用的是OpenAI的Assistant API,还是用LangChain手搓代码,都可以试着问自己以下四个问题:

- 架构完整吗?你的系统里只有模型和Prompt,还是具备了明确的编排层、运行时和状态管理?

- 协议标准吗?你的工具连接是私有硬编码,还是采用了像MCP这样的标准化协议,具备可扩展性?

- 协作清晰吗?如果涉及多Agent,它们是简单的轮询,还是有类似A2A的明确分工与通信机制?

- 敢上线吗?你的质量体系是只能跑通Demo,还是拥有了像软件工程一样的回归测试、门禁和线上追踪(Tracing)能力?

2025年,Agent开发正在告别草莽时代,进入标准化的工业时代。理解这些大厂的工程哲学,将帮助我们在技术选型时不再迷茫。

留下评论