第四篇 能力图谱:图书馆员在AI时代的九维坐标

2023年秋,美国图书馆协会(ALA)发布了一份里程碑式的文件——《图书馆从业者AI能力框架》(AI Competencies for Library Workers)。这份文件的意义,不仅在于它为图书馆员勾勒出AI时代的职业画像,更在于它回答了一个被焦虑裹挟的行业最迫切的问题:当AI可以秒级完成文献检索,当算法能够推荐比人更精准的阅读书单,图书馆员的价值何在?

答案藏在框架的底层逻辑中:图书馆员不需要成为AI工程师,但必须成为AI生态中不可替代的"枢纽节点"——既是工具的熟练向导,也是伦理的守门人,更是连接技术与人文的摆渡者。本文将这个九维能力框架拆解为可操作的"图书馆员AI能力图谱",并论证为何这些能力恰恰是AI无法取代的。

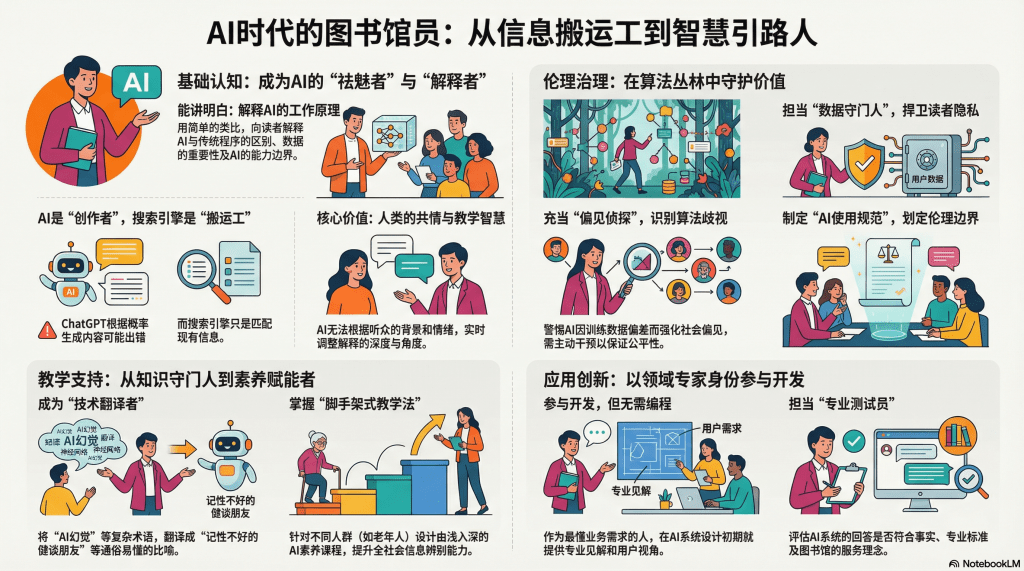

能力象限一:基础认知——站在巨人肩膀上看清脚下

ALA框架的前两个维度——"AI基础知识"和"AI工具认知"——构成了能力金字塔的基座。这看似是最"低阶"的能力,实则是最容易被误解的。

许多图书馆员的第一反应是:"我又不是程序员,为什么要学这些?"这种抵触情绪源于对"基础知识"的误读。ALA要求的不是掌握反向传播算法,不是能从头训练一个神经网络,而是理解AI的工作原理到足以"解释给读者听"的程度。

打个比方:你不需要懂得汽车发动机的每个零件如何运作,但如果你是驾校教练,你至少要知道油门控制的是燃料供给,刹车作用于轮毂,变速箱决定动力传输——这样才能给学员讲清楚"为什么坡道起步要配合离合"。

对图书馆员而言,AI基础知识的核心是三个"能讲明白":

能讲明白AI与传统程序的区别。当读者问"为什么搜索引擎不会犯错,ChatGPT却会胡说八道",你需要解释:"搜索引擎是在已有的网页库中匹配关键词,ChatGPT是根据概率预测下一个词——前者是'搬运工',后者是'创作者',而创作就有可能出错。"这种类比式的解释,比任何技术文档都有效。

能讲明白数据对AI的决定性作用。"垃圾进,垃圾出"(Garbage In, Garbage Out)是计算机科学的铁律,在AI时代更甚。一个用偏见数据训练的招聘AI会歧视女性,一个只学过英文的翻译AI翻中文就会离谱——这些例子能帮助读者理解:AI不是神谕,它是人类社会的镜像,包括那些我们不愿承认的阴暗面。

能讲明白AI的能力边界。最常见的误区是把AI当成"全知全能"。图书馆员需要成为"祛魅者",用具体案例告诉读者:AI不能进行真正的逻辑推理(它模拟推理,但不理解因果),不能处理训练数据之外的新情况(所以问它"明天的彩票号码"注定失败),不能进行道德判断(它只能复述人类的道德观,无法形成自己的价值体系)。

这种"能讲明白"的能力,恰恰是AI无法替代的。AI可以生成关于AI的科普文章,但它无法根据读者的困惑程度、知识背景、情绪状态,实时调整解释的深度和角度——这需要人类的共情力和教学智慧。

能力象限二:伦理治理——在算法丛林中守护价值

ALA框架的第三到第五维度——"伦理与责任""隐私与数据治理""公平性与可及性"——构成了图书馆员的"价值护城河"。这是技术人员往往忽视,但图书馆职业传统最为看重的领域。

图书馆自诞生之日起,就承载着"知识民主化"的使命。《图书馆权利法案》(Library Bill of Rights)宣示的核心价值——平等获取、隐私保护、智力自由——在AI时代面临前所未有的挑战。算法推荐可能加剧信息不平等,用户画像威胁阅读隐私,内容审核可能侵犯表达自由。图书馆员必须成为这些价值的捍卫者。

在隐私维度,图书馆员需要成为"数据守门人"。当图书馆考虑引入AI驱动的个性化推荐系统时,你需要追问:这个系统收集了读者的哪些数据?数据存储在哪里?会与第三方共享吗?读者能否选择退出?这些问题不是技术问题,而是价值问题——你在代表读者行使"知情同意权"。

一个具体的案例:某公共图书馆引入了AI语音助手,帮助读者查找图书。技术供应商承诺"完全免费"。图书馆员的职责就是挖掘"免费"背后的代价:供应商是否会收集读者的语音数据用于模型训练?这些数据中可能包含什么敏感信息(如通过声纹识别身份)?如果被滥用,读者面临什么风险?

在公平性维度,图书馆员需要成为"偏见侦探"。AI偏见是当前最受关注的伦理问题之一。一个经典案例是亚马逊的招聘AI,因为训练数据中男性简历占多数,系统学会了"降低包含'女子大学''女子俱乐部'等关键词的简历评分"。

图书馆场景中同样存在这种风险。假设你使用AI来优化馆藏采购——系统分析历史借阅数据,预测哪些书会受欢迎。听起来很合理,但陷阱在于:历史数据反映的是过去的馆藏结构和读者构成。如果过去你的馆藏偏向某个族裔或阶层,AI会强化这种偏向,进一步边缘化少数群体的需求。图书馆员的职责就是识别这种"算法歧视",并主动干预——比如为冷门但重要的主题设置采购配额,而不是完全听命于算法。

在责任维度,图书馆员需要建立"AI使用规范"。技术不会自己设定伦理边界,需要人来划线。ALA框架建议图书馆制定明确的AI政策,回答诸如此类的问题:允许馆员用AI写报告吗?如果允许,必须如何标注?允许用AI回答读者咨询吗?如果出错,责任由谁承担?允许读者使用图书馆的AI工具吗?如何防止滥用(如生成不当内容)?

这些规范的制定,不是技术问题,而是需要平衡多方利益、考量长远后果的治理问题。而图书馆员,作为连接技术供应商、机构管理层和读者的中间层,恰好处于最合适的位置来主导这个过程。

能力象限三:教学支持——从知识守门人到素养赋能者

ALA框架的第六、七维度——"教学与培训""沟通与协作"——标志着图书馆员角色的转型:从"收藏和组织信息"转向"培养信息能力",从"回答问题"转向"教会提问"。

在AI时代,这种转型更加迫切。读者面对的已经不是"信息匮乏",而是"信息过载"+"真假难辨"。一个不懂AI的读者,可能被AI生成的虚假学术论文引用所误导,可能在AI聊天中无意泄露隐私,可能因为过度依赖AI而丧失独立思考能力。图书馆员的新使命,就是提升全社会的AI素养。

在教学能力上,图书馆员需要掌握"脚手架式教学法"。不是一次性灌输所有知识,而是根据学习者的当前水平,提供恰到好处的支持。

以教老年人使用AI为例。第一步不是解释什么是机器学习,而是让他们体验"AI能帮我做什么"——比如用语音助手查天气、用AI翻译阅读外文新闻。建立信心后,第二步才是引入批判意识:"你注意到AI有时会说错吗?我教你怎么验证。"最后才是伦理教育:"有些信息不要告诉AI,比如你的身份证号。"

在沟通能力上,图书馆员需要成为"技术翻译者"。AI领域充斥着术语黑话:大语言模型、微调、幻觉、提示工程……这些词对普通读者是天书。图书馆员的价值就在于能把这些概念"翻译"成日常语言。

比如,如何解释"AI幻觉"?不要说"由于概率生成机制的局限性导致的事实性错误",而是说:"AI就像一个健谈但记性不好的朋友,它会流畅地讲故事,但有时会无意中编造细节,自己都不知道说错了。所以你不能完全信它,需要找其他资料核实。"

这种"降维打击"式的解释,需要同时具备技术理解和人文素养——既要懂AI,也要懂教育学和传播学。这正是图书馆员的跨界优势。

能力象限四:应用开发——在不编程的前提下参与创新

ALA框架的最后两个维度——"评估与选择AI工具""参与AI系统开发"——是最容易引起误解的。很多图书馆员一看"开发"二字就想:"这不是IT部门的事吗?"

但ALA所说的"参与开发",不是要求你写代码,而是要求你能以用户和领域专家的身份,介入AI应用的设计和评估过程。这是一种被称为"参与式设计"(Participatory Design)的理念——最了解业务需求的人,应该在技术方案确定之前就发声,而不是被动接受一个成品。

举个例子:你的图书馆打算开发一个AI驱动的"智能问答系统",读者可以用自然语言提问,系统自动给出答案和相关馆藏推荐。如果这个项目完全交给外包公司或IT部门,很可能出现以下问题:

- 系统只能回答事实性问题("XXX这本书在哪个书架"),无法处理开放性咨询("我想了解气候变化,该从哪本书开始读")——因为开发者不理解参考咨询的复杂性。

- 系统推荐的都是热门书,冷门但高质量的馆藏被埋没——因为算法只看借阅量,不懂学科价值。

- 系统给出的答案缺乏人文关怀——比如读者问"我最近很焦虑,有什么书能帮我",AI冷冰冰地推荐《焦虑症自救手册》,而不是像人类馆员那样先询问情况、提供情绪支持。

作为图书馆员,你的"参与开发"体现在:

在需求阶段,你要提出关键问题。"这个系统的目标是减少咨询台工作量,还是提升咨询质量?""我们如何定义'成功的回答'?""如果系统回答错误,有补救机制吗?"这些问题决定了系统的设计方向。

在测试阶段,你要提供专业判断。当系统给出一个答案,你需要评估:"这个答案在事实上正确吗?在图书馆学意义上恰当吗?是否符合我们的服务理念?"这不是技术测试,而是专业测试。

在部署阶段,你要制定使用规范。什么情况下可以依赖AI给答案,什么情况下必须人工介入?如何向读者解释系统的局限性?如何收集反馈持续改进?

这些工作,都不需要你会编程,但需要你懂图书馆业务、懂读者需求、懂服务伦理。这种"领域知识+批判思维"的组合,正是图书馆员的核心竞争力。

绘制你的个人能力图谱

ALA的九个维度,不是"每个都必须精通"的清单,而是"根据岗位选择侧重"的工具箱。一个学科馆员、一个少儿服务馆员、一个技术部馆员,他们需要的AI能力组合完全不同。

为了帮助读者自我评估,我提出一个简化的"图书馆员AI能力雷达图":

基础认知:你能向非专业读者解释AI的工作原理吗?(1-5分自评)工具应用:你能熟练使用至少3种AI工具辅助工作吗?(1-5分)伦理判断:你能识别AI应用中的隐私和公平风险吗?(1-5分)教学设计:你能为不同人群设计AI素养课程吗?(1-5分)批判评估:你能评估一个AI系统是否适合图书馆使用吗?(1-5分)

将这五个维度的分数在雷达图上标出,连线形成的面积,就是你当前的"AI能力覆盖面"。这个图谱不是用来评判高下,而是用来发现短板:哪些能力是你岗位必需但目前欠缺的,应该优先提升;哪些能力虽然有趣但对你的工作不紧要,可以暂时搁置。

更重要的是,通过定期(比如每半年)重新评估,你可以看到自己的成长轨迹——这种可视化的进步,是对抗职业焦虑的良药。

重新定义图书馆员的价值主张

ALA框架的深层意义,不在于列出了九个维度,而在于重新定义了图书馆员在AI时代的价值主张:你的价值不在于比AI更快地检索信息,而在于提供AI无法替代的人文关怀、专业判断和伦理坚守。

AI可以推荐书单,但它不知道一个刚经历丧亲之痛的读者此刻需要的不是"悲伤主题书籍",而是有人倾听;AI可以回答问题,但它不理解为什么有时"不直接给答案,而是引导读者自己探索"才是更好的服务;AI可以优化流程,但它无法在效率与公平之间做出符合图书馆价值观的权衡。

这些"软技能"——共情、教育、价值判断——恰恰是最难被AI复制的。当我们拥抱AI作为工具,解放自己从重复性劳动中,我们才有更多时间去做这些真正需要"人"的工作。

从这个意义上说,AI不是图书馆员的威胁,而是一个机会——一个重返职业初心的机会:不是信息的搬运工,而是智慧的引路人。

留下评论