第十篇 诚信重构:在“人机共创”时代为学术划定新边界

2023年秋,一则新闻在中国学术圈引发热议:某985高校撤销了一名本科生的学位,理由是“毕业论文大量使用AI生成内容且未声明”。但很快,质疑声四起:“多少算‘大量’?”“如果只用AI润色语法,算违规吗?”“学校有没有明确告知学生AI使用规范?”

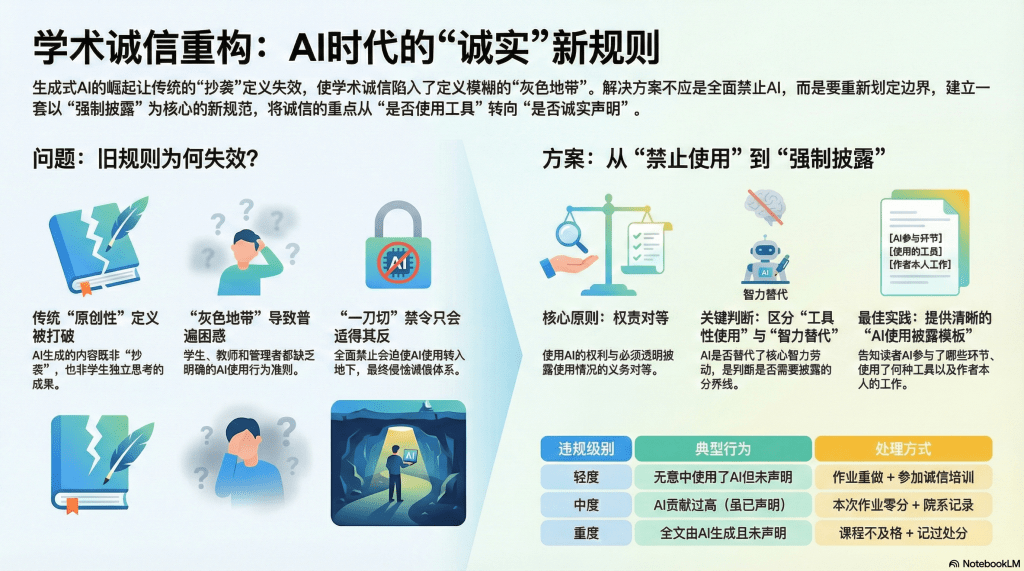

这个案例暴露了一个尖锐的矛盾:技术的进步速度,远超制度的适应能力。当AI可以在几秒内生成一篇结构完整、论据充分、文笔流畅的论文,传统的“抄袭”定义——复制他人文字——已经不敷使用。因为AI生成的内容,严格说不是“抄袭”(它是原创的组合),但又显然不是学生独立思考的成果。

这种“灰色地带”让所有人都困惑:学生不知道用到什么程度算作弊,教师不知道怎么界定和处理,管理者不知道如何制定规则。而在困惑和混乱中,最坏的结果可能是:学术诚信体系的全面崩溃——反正大家都在偷偷用AI,明文禁止只会逼人撒谎。

本文认为,解决之道不是“一刀切”地禁止AI(那既不可能也不合理),而是重新定义学术诚信的边界。在“人机共创”成为常态的时代,我们需要一套新的规范:明确什么可以做、什么不能做,以及最关键的——如何透明地声明你做了什么。

而图书馆,作为学术诚信教育的传统阵地,应该牵头制定这套新规范,并将其转化为可操作的实践指南。

旧规范的失效:当“原创性”遭遇“生成式AI”

传统学术诚信的核心概念是“原创性”(Originality)——你提交的作品,应该是你独立思考、独立完成的,而非抄袭他人或请人代劳。

这个概念建立在一个前提上:创作是纯粹人类的活动。你可以参考文献(但要引用),可以和他人讨论(但要致谢),但最终“写下这段话”的行为,必须由你亲手完成。

AI打破了这个前提。当你输入“请论述康德的绝对命令”,AI在10秒内给你一篇800字的小论文,这篇文章的“作者”是谁?

从技术角度说,作者是OpenAI(或百度、阿里)——是他们训练了模型。但模型是基于无数人的文本训练的,那些文本的作者也有贡献。而你,作为提示词的设计者、话题的选择者,也参与了创作。所以这是一个“分布式作者身份”的产物,无法简单套用“一个人写的”框架。

更棘手的是程度问题。使用AI有很多层次:

- 用AI纠正拼写和语法错误(类似Grammarly);

- 用AI改写句子,让表达更流畅(比如“帮我把这句话改得更学术一些”);

- 用AI生成文章大纲,你再填充内容;

- 用AI生成段落初稿,你再修改润色;

- 用AI生成全文,你只改几个词或者干脆不改。

哪些是可接受的?哪些踩了红线?

如果说5肯定不行、1应该可以,那2、3、4呢?不同人会有不同判断。而在缺乏明确规范的情况下,学生只能“猜”老师的底线在哪——保守的学生完全不敢用,冒险的学生肆无忌惮,诚实的学生如实声明后反而被处罚(因为“暴露了”),撒谎的学生蒙混过关。

这种混乱,对学术诚信的腐蚀是致命的。

新边界的原则:从“禁止使用”到“强制披露”

面对这个困境,国际学术界正在探索新的路径。以美国为例,哈佛、斯坦福等高校在2023年纷纷更新了学术诚信政策,核心思路从“禁止AI”转向了“规范使用+透明披露”。

这个转向基于一个务实的认识:AI已经成为知识生产的一部分,全面禁止既不可能(无法有效监管),也不合理(剥夺了学生利用技术的正当权利)。关键不在于“用不用”,而在于“怎么用”“说不说”。

我提出一个适用于中国高校的“AI使用披露规范”,核心原则是:

原则一:权责对等——使用AI的权利与披露的义务对等。

你可以使用AI辅助学术写作,但作为对价,你必须清楚地告知读者(教师、审稿人)AI参与了哪些环节、做了什么、你又做了什么。这不是为了“自证其罪”,而是为了让评价者有足够的信息做判断。

类比:你可以引用他人的观点,但必须标注出处。AI使用声明,就是“数字时代的引文规范”。

原则二:智力贡献为本——区分“工具性使用”与“智力替代”。

不是所有AI使用都需要披露。关键看:AI是否替代了你的核心智力劳动?

- 用AI翻译一段外文、纠正语法错误、调整格式——这些是工具性使用,类似使用字典或拼写检查,通常不需披露(但具体政策由任课教师或期刊决定);

- 用AI生成论文大纲、撰写段落、进行论证——这些涉及核心智力活动(构思、论证、表达),必须披露。

判断标准:如果去掉AI的参与,这个作品的核心价值会显著降低吗?如果答案是“是”,就必须披露。

原则三:语境决定规则——不同场景有不同标准。

AI使用的边界,不应该“一校一策”,而应该“一课一策”,甚至“一作业一策”。

比如:

- 思维训练型作业(如哲学课的伦理论证、文学课的文本细读),应该严格限制AI使用,因为目的是锻炼学生的思维能力,AI的介入会削弱训练效果;

- 工具应用型作业(如让学生用AI分析一组数据、生成可视化图表),不仅允许、甚至鼓励使用AI,因为教学目标就是“学会使用工具”;

- 开放探索型作业(如“用任何方法完成一个创意项目”),可以允许AI深度参与,但要求学生详细说明“AI做了什么、我做了什么、为什么选择这样协作”。

教师有权在教学大纲中明确规定本课程的AI使用政策,学生必须遵守。图书馆的职责,是帮助教师制定这些政策,并教会学生如何正确声明。

一套可操作的“AI使用披露格式”

空谈原则不够,必须给出具体的操作指南。我提出一套“AI使用声明”的标准格式,可以附在论文末尾(类似“致谢”或“利益冲突声明”):

AI工具使用声明

本文在以下环节使用了AI工具:

- 文献检索与摘要生成

- 工具:ChatGPT 4.0

- 用途:输入研究主题“气候变化与粮食安全”,要求AI列出相关核心文献,并生成每篇的200字摘要

- 本人的工作:筛选了AI推荐的文献,实际阅读了其中15篇原文,摘要仅作为初步了解,所有引用都基于原文

- 论文大纲构建

- 工具:Claude 3

- 用途:向AI描述了我的研究问题和已读文献,要求它帮我生成一个论文结构建议

- 本人的工作:AI给出了5个结构方案,我选择了其中一个并进行了调整(增加了“政策建议”部分,删除了“历史回顾”部分)

- 段落初稿生成

- 工具:文心一言

- 用途:在第三章第二节,我让AI根据我提供的3篇文献和我的观点,生成一段800字的初稿

- 本人的工作:对AI生成的初稿进行了大幅改写(改写比例约60%),包括:补充了两个案例,修改了因果逻辑,调整了学术表达

- 语言润色

- 工具:Grammarly

- 用途:检查全文的语法错误和表达优化建议

- 本人的工作:接受了约70%的修改建议,拒绝了可能改变原意的建议

声明:除上述环节外,论文的研究问题提出、文献批判性分析、数据解读、核心论证均由本人独立完成。

这种格式的优点:

- 透明:清楚告知AI做了什么、你做了什么;

- 可验证:教师可以根据声明,重点检查“本人独立完成”的部分,看是否展现了思维深度;

- 可比较:不同学生的声明放在一起,能看出AI使用的差异,有助于公平评价。

从“抓作弊”到“教规范”:图书馆的新角色

传统上,学术诚信教育聚焦于“如何识别抄袭”“违规的后果”——这是一种惩罚导向的模式。

在AI时代,图书馆应该转向规范导向:不是等学生犯错后抓,而是事前就教清楚“规则是什么”“如何合规操作”。

具体行动一:制定并推广“AI使用披露模板库”

图书馆可以联合教务部门、各学院,共同制定一套分学科、分作业类型的AI使用声明模板。

比如:

- 理工科实验报告模板;

- 人文社科论文模板;

- 商科案例分析模板;

- 艺术设计作品说明模板。

每个模板都给出示例,告诉学生“如果你在XX环节用了AI,应该这样写声明”。

这些模板放在图书馆网站、选课系统,甚至打印成小册子放在自习室,确保每个学生都能轻松获取。

具体行动二:开设“学术诚信工作坊:AI时代版”

传统的学术诚信课讲“什么是抄袭”“如何正确引用”,现在要加入新内容:

- AI使用的伦理边界:什么情况下用AI是合理的,什么时候是不当的?通过案例讨论培养判断力;

- 声明的写作技巧:如何准确描述AI做了什么、避免模糊其辞?让学生练习写声明,馆员点评;

- AI作弊的识别:反过来,也教学生“如果你是老师,怎么判断一篇论文是不是AI代写的”——这种“换位思考”能强化他们的诚信意识。

具体行动三:建立“AI使用咨询服务”

学生在写作业时,经常拿不准“这样用AI算不算违规”。图书馆可以提供实时咨询:

- 在线咨询(邮件、即时聊天):“老师,我想让AI帮我分析这组数据,然后我自己写结论,这样需要声明吗?”

- 面对面咨询:“老师,这是我的论文草稿和AI使用声明,您能帮我看看有没有问题?”

这种服务不是“帮学生钻空子”,而是帮学生建立规范意识——让他们养成习惯:遇到不确定的情况,主动求证,而不是侥幸蒙混。

具体行动四:推动“AI使用政策”的制度化

单靠图书馆的倡导还不够,必须从校级层面建立正式政策。图书馆可以:

- 牵头起草《XX大学学生AI工具使用与披露规范(试行)》,提交学术委员会讨论通过;

- 推动在《学生手册》《课程教学大纲模板》中增加“AI使用政策”条款;

- 每学期初,组织全体教师的“AI政策培训”,确保教师理解如何在自己的课程中执行。

三个真实场景的处理方案

让我们用三个具体场景,展示新规范如何运作:

场景一:学生A在论文中大量使用AI,但做了详细声明

论文提交后,附有完整的AI使用声明,清楚说明“第二章完全由AI生成初稿,本人进行了约30%的修改;第三、四章由本人独立完成”。

教师的处理:

- 重点评估第三、四章(学生声明为独立完成的部分),看是否展现了批判性思维和学科理解;

- 对第二章,可以给较低分(因为AI贡献过大),但不应判定为作弊(因为学生诚实声明了);

- 在反馈中明确告知:“你的声明很好,但下次作业应该更多独立写作,AI应只用于辅助”。

场景二:学生B完全用AI代写,且未声明

教师通过多项指标怀疑作弊(文风突变、内容超纲、细节追问答不上来),将论文提交学术委员会审查。

学校的处理:

- 找学生谈话,询问创作过程。如果学生承认“全文AI生成,我没写”,视为严重违反学术诚信,按作弊处理(重修、记过等,具体依校规);

- 关键不是“用了AI”(这本身不违规),而是“用了不声明”(这是欺骗)。

场景三:学生C用AI辅助查资料和润色,且声明了,但教师认为“根本不该用AI”

处理原则:如果教师在教学大纲中明确规定“本课程禁止使用AI”,学生违反,应承担后果(扣分或重做)。

但如果教师课前没有明确政策,只是事后觉得“你不该用”,则不应追溯处罚。应该:给学生一次补救机会(如重新提交不使用AI的版本),并在下次课程开始前明确AI政策。

这个场景强调:教师有权设定规则,但必须事前告知。学生不是读心术专家,不能期待他们“猜”出每个老师的偏好。

从“零容忍”到“分级响应”:重新思考违规处理

传统学术诚信体系是“零容忍”:只要抄袭,就是严重违纪,后果可能是挂科、处分、甚至开除。

这种严苛在“抄袭 = 复制他人文字”的时代是合理的,因为那是明确的、有意的欺骗。

但在AI时代,很多“违规”可能源于无知而非恶意——学生真的不知道“用AI生成然后修改算不算抄袭”,或者知道应该声明但不知道怎么声明。

因此,我建议采用“分级响应”机制:

轻度违规(如使用了AI但未声明,经调查确认是不懂规范而非故意隐瞒):

- 后果:本次作业给低分或要求重做;

- 教育:要求学生参加学术诚信培训,重新学习规范;

- 记录:不记入档案,给改过机会。

中度违规(如AI使用比例过高,虽然声明了但明显违背作业要求):

- 后果:本次作业零分,并影响总评;

- 教育:约谈,签署承诺书;

- 记录:院系内部记录,但不上报学校。

重度违规(如完全AI代写且不声明,或多次违规):

- 后果:课程不及格,记过处分;

- 教育:强制参加学术诚信再教育课程;

- 记录:记入学生档案。

这种分级处理,既维护了学术诚信的严肃性,又给了“初犯”和“无知者”改正机会,避免一棒子打死。

结语:诚信的本质是诚实,而非拒绝工具

学术诚信的核心,从来不是“不使用外部资源”——否则我们早该禁止图书馆、禁止讨论、禁止引用。

学术诚信的核心是诚实:诚实地告知你做了什么、怎么做的、谁帮了你、你的贡献在哪。

AI作为一种新的“外部资源”,本质上和书籍、讨论、导师指导没有区别——关键在于如何使用,如何声明。

当我们把焦虑从“学生用不用AI”转移到“学生诚不诚实”,就能走出当前的困境。我们不需要把AI妖魔化为“学术诚信的敌人”,而是要建立新的规范,让“人机共创”成为透明的、负责任的、可评估的学术实践。

而图书馆,作为学术诚信教育的传统守护者,在这个转型期,应该成为规范的制定者、传播者、守护者——不是用惩罚吓阻学生,而是用清晰的规则引导学生,用教育的力量,在技术洪流中,守住诚信的底线。

这才是AI时代学术诚信的正道。

留下评论