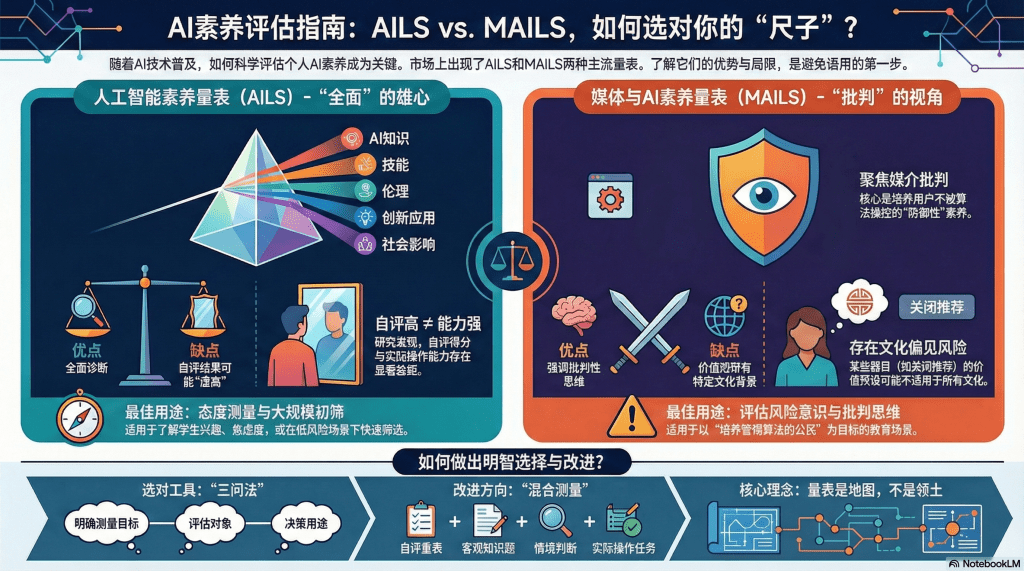

第十二篇 量表之镜:AILS与MAILS的光芒与阴影

2023年,清华大学发布了一个引发广泛关注的研究成果:人工智能素养量表(AILS)。这套量表包含72个题目,声称能全面测量一个人的AI素养水平,从“AI知识”到“AI伦理”,从“使用技能”到“创造能力”,涵盖多个维度。

几乎同一时间,德国研究团队推出了媒体与AI素养量表(MAILS),聚焦于“如何在信息洪流中保持批判性”,强调算法推荐、深度伪造等媒介素养维度。

这些量表的出现,像是在混沌的AI素养评估领域,点亮了一盏明灯——终于有了“标准化工具”。但随着全球数十个研究团队引用、使用这些量表,一些问题也逐渐浮现:量表能测什么,不能测什么?它们适合谁用?在什么场景下有效?

本文将对现有主流AI素养量表进行“验明正身”——不是要全盘否定,而是厘清它们的适用边界,帮助教育者和研究者避免“拿着锤子,把所有问题都当钉子”的误用。

AILS的解剖:一个“全面”的野心

清华的AILS量表,结构上采用了五维模型:

1.AI知识(如“什么是机器学习”)

2.AI技能(如“能否使用AI工具完成任务”)

3.AI伦理(如“对算法偏见的认知”)

4.创新应用(如“能否用AI解决新问题”)

5.社会影响认知(如“AI对就业的影响”)

每个维度下设多个子维度,用李克特量表(1-5分,从“非常不同意”到“非常同意”)让受测者自评。

AILS的优势:全面性

这套量表最大的价值在于全景式覆盖。它不像某些量表只测技术知识,而是试图捕捉AI素养的多个面向。当你用AILS对一群学生测试,能得到一个“雷达图”——每个维度的得分一目了然,哪里强、哪里弱,清清楚楚。

一个应用案例:某职业技术学院用AILS对新生进行前测,发现:

- AI知识维度:平均2.3分(较低,很多学生连基本概念都不清楚)

- AI技能维度:平均1.8分(更低,几乎没人实际用过AI工具)

- AI伦理维度:平均3.5分(中等偏上,可能因为媒体报道让大家有基本的风险意识)

这个诊断帮助学院调整了课程设计:增加动手实践环节,减少纯理论讲授。

AILS的局限:自评的“虚高”

但AILS有一个致命弱点:它测的不是实际能力,而是自我认知。

具体来说,题目类型是:“我能够使用AI工具完成复杂任务”(1-5分)——这测的是受测者觉得自己能不能,而不是真的能不能。

心理学研究早已证明:自评往往不准。尤其是:

- 达克效应(Dunning-Kruger Effect):能力低的人往往高估自己,能力高的人反而谦虚。一个从没用过AI的人,可能因为“看过几个教程”就给自己打4分;真正的高手,因为知道还有很多不懂,反而打3分。

- 社会期许偏差:受测者猜测“什么答案是‘应该’的”,然后顺着这个方向回答。比如伦理题:“我会拒绝使用可能侵犯隐私的AI”——几乎所有人都会选“非常同意”,因为这是“道德正确”答案,但实际生活中可能又是另一回事。

一个真实的对照实验:

- 用AILS测一群学生的“AI技能”维度,平均3.8分(自评“比较会用”)

- 让同一群学生完成实操任务(用ChatGPT写一份规范的读书笔记),只有40%合格

这说明:自评高≠能力强。量表测的是“自信心”和“对AI的熟悉感”,而非真实水平。

AILS适合测什么?

明白了这个局限,我们就能正确使用AILS:

- 适合:态度和意愿的测量。比如“学生对学习AI有多大兴趣”“对AI技术有多焦虑”“是否愿意在工作中尝试AI”——这些本来就是主观感受,自评是合理的。

- 适合:大规模筛查。当你有1000个学生,不可能逐个做实操测试,用量表快速识别“哪些人AI素养自评很低(可能需要额外辅导)”“哪些人自评很高(可能可以当助教)”——虽然不完全准确,但比完全不测强。

- 不适合:高风险决策。比如根据AILS分数决定谁能毕业、谁能拿奖学金——这是不负责任的,因为量表测不准实际能力。

MAILS的聚焦:媒介批判的视角

德国的MAILS量表,路径不同。它不追求“全面”,而是聚焦于“AI时代的媒介素养”。

核心维度包括:

6.算法意识(Algorithm Awareness):理解推荐系统、搜索排序的逻辑

7.批判性评估(Critical Evaluation):能否识别AI生成的虚假信息

8.数据隐私(Data Privacy):对个人数据被收集和使用的认知

9.社会影响反思(Societal Reflection):对AI加剧不平等、操控舆论等问题的思考

MAILS的优势:批判性导向

相比AILS的“中性”(既测技术能力也测伦理,但不明确倾向),MAILS有明确的价值立场——它认为AI素养的核心是“不被算法操控”。

这种立场在欧洲语境下尤其突出。欧洲社会对数据隐私、算法透明、技术监管的重视程度远超美国和中国。MAILS反映的是一种防御性素养观:在技术面前保持警惕,守护个人自主。

MAILS的典型题目:

- “我会主动关闭社交媒体的个性化推荐功能,避免被算法圈养。”(同意程度)

- “当我看到一段视频或图片,我会怀疑它可能是AI生成或篡改的。”(频率)

这些问题的设计,明显鼓励“批判性警觉”的态度。

MAILS的局限:文化特殊性

但MAILS的问题在于:它的价值预设,可能不适用于所有文化。

以“关闭个性化推荐”为例。在欧洲,这可能被视为“捍卫自主权”的积极行为;但在中国语境下,很多用户可能认为“个性化推荐很方便啊,为什么要关”——并不是他们缺乏素养,而是他们在“便利性”和“自主性”之间做了不同的权衡。

如果机械套用MAILS,可能会把“选择享受便利”的用户判定为“素养低”——这是一种文化偏见。

MAILS适合测什么?

- 适合:批判意识和风险敏感性。如果你的教育目标是“培养警惕算法的公民”,MAILS是好工具。

- 适合:欧洲或类似文化背景的人群。MAILS的题目设计,默认了一套关于“隐私”“自主”“透明”的价值观,这在某些文化中是主流,但不一定普世。

- 不适合:技能和应用能力的测量。MAILS几乎不涉及“如何用AI”,只关注“如何防AI”。如果你想知道学生会不会写提示词、能不能用AI做项目,MAILS帮不上忙。

其他量表:各有侧重的群像

除了AILS和MAILS,国际上还有多个AI素养量表,各有千秋:

AI4K12的“五大理念”框架(美国)

- 聚焦K-12教育,强调“AI是什么”“AI如何工作”的概念理解

- 优点:适合青少年,语言简单

- 局限:更像知识测试,不涉及复杂的伦理和社会议题

MIT Media Lab的“AI伦理量表”

- 聚焦算法公平、透明、问责

- 优点:深挖伦理维度,适合高阶学习者

- 局限:完全不测技能,单独使用会片面

UNESCO的“AI素养教师自评表”

- 专为教师设计,测“你能否教学生AI素养”

- 优点:针对性强

- 局限:只适合教师,不适合学生

这些量表的存在,印证了一个现实:没有一个量表能“通吃”所有场景。

量表使用的“三问法”:选对工具的艺术

当你面对五花八门的量表,如何选择?我提出“三问法”:

第一问:我想测什么?

- 如果想测态度和自信心→ AILS合适

- 如果想测批判意识和风险警觉→ MAILS合适

- 如果想测实际操作能力→ 所有现有量表都不够,必须加实操测试

- 如果想测深层伦理思考→ MIT伦理量表+开放式问答

第二问:我的对象是谁?

- 大学生 → AILS、MAILS都可用

- 中小学生 → AI4K12更合适

- 教师 → UNESCO教师自评表

- 普通公众 → 需要简化版量表,题目要通俗

第三问:我用测试结果做什么?

- 课程设计的需求分析(低风险)→ 量表够用

- 学生分班或分流(中风险)→ 量表+实操

- 毕业认证或职业资格(高风险)→ 必须多种方法组合,不能只靠量表

改进之道:从“纯自评”到“混合测量”

既然自评量表有局限,如何改进?一个方向是嵌入客观题。

改进策略1:知识锚定题

在自评题之间,穿插客观知识题。比如:

- 自评题:“我了解机器学习的基本原理。”(1-5分)

- 紧接着,客观题:“以下哪项是机器学习的必要条件?A.大量数据 B.编程能力 C.互联网连接 D.高学历”(答案:A)

如果受测者自评“非常了解”(5分),但客观题答错——这说明他高估了自己。通过对比自评和客观题的分数,可以识别“虚高”。

改进策略2:情境判断题

在态度量表之后,加入情境判断测试(SJT)。比如:

- 量表题:“我会拒绝使用侵犯隐私的AI。”(同意5分)

- 情境题:“一个APP提供免费AI功能,但需要访问你的通讯录、位置、相册。你会:A.同意并使用 B.拒绝下载 C.同意但关闭部分权限”

如果受测者量表打5分(坚决拒绝侵犯隐私的AI),但情境题选A(为了免费功能放弃隐私)——这揭示了“理想”与“现实”的差距。

改进策略3:行为数据补充

如果技术条件允许,收集实际使用行为数据。比如:

- 在量表测“AI技能”维度后,让受测者在学习平台上用AI完成一个任务(如写摘要、生成图表),系统自动记录操作时间、尝试次数、最终质量。

- 对比自评分数和行为表现,校准量表结果。

量表的未来:走向“自适应测试”

传统量表是“固定题目”——所有人答同样的题。但这有两个问题:

- 对高手来说,简单题太多,浪费时间且测不出真实水平上限

- 对新手来说,难题太多,打击信心且得到的全是低分

未来的方向是计算机自适应测试(CAT):

10.先给一道中等难度的题

11.答对了,系统自动给更难的题;答错了,给更简单的题

12.通过十几道题的动态调整,精准定位受测者的能力水平

这种技术在GRE、托福等标准化考试中已成熟应用。AI素养量表也可以借鉴:

- 如果受测者在“AI知识”维度前几题全对,后续题会深入到“解释训练数据偏差如何影响模型输出”这种高阶问题

- 如果前几题就错了,后续题会回到“什么是AI”这种基础问题

自适应测试的优势:用更少的题目,获得更高的测量精度。

结语:量表是地图,不是领土

量表是工具,是“地图”——它帮你快速了解地形,但地图不等于领土。

AILS和MAILS们,都在尝试绘制“AI素养”这片未知领域的地图。它们各有贡献:AILS画出了全景,MAILS标出了险滩。但没有一张地图是完美的——比例尺不同、投影方式不同、绘制者的视角不同,都会导致地图的局限。

作为使用者,我们的智慧在于:带着多张地图上路,根据具体地形选择参考哪张,并且永远记得——最终,你得用自己的脚去走那片土地。

量表能告诉你学生在哪个维度薄弱,但改进教学要靠你的专业判断;量表能识别出高分低能者,但如何帮助他们还得靠有针对性的指导。

理解量表的光芒,也正视量表的阴影——这才是对测量工具的尊重,也是对教育责任的担当。

留下评论