第十三篇 真实战场:情境判断测试如何逼近AI素养的真相

一个耐人寻味的实验:

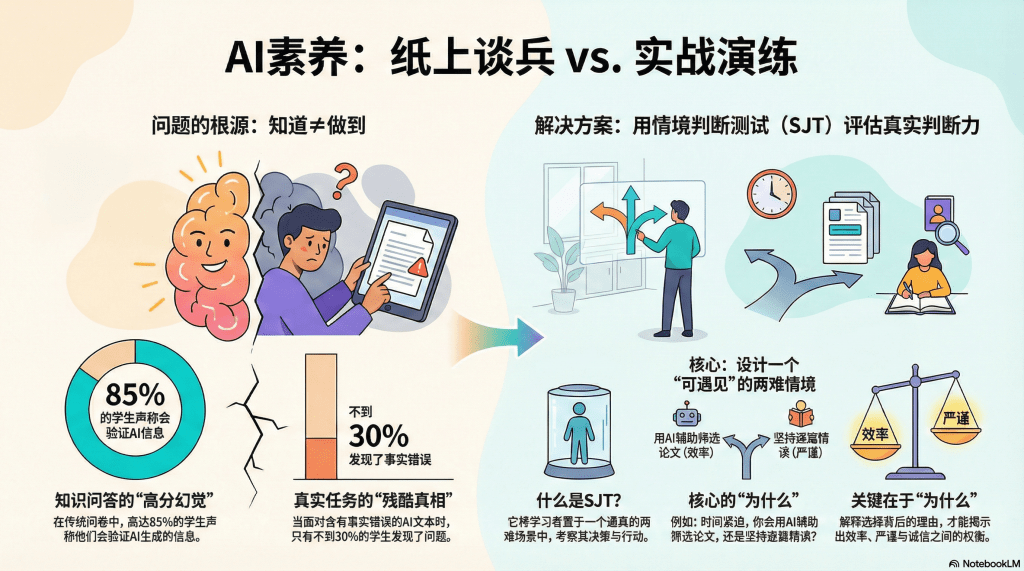

研究者给两组学生同样的AI素养“测试”。第一组做的是传统问卷:“你知道AI可能产生幻觉吗?”“你会验证AI给出的信息吗?”几乎所有人都选“是”,平均分高达85分。

第二组面对的是情境:给他们一段AI生成的文章(其中故意包含三处事实错误),让他们阅读并总结要点。结果?只有不到30%的学生发现了至少一处错误,绝大多数人照单全收,甚至在自己的总结中复述了错误信息。

这个实验揭示了一个残酷的真相:“知道应该怎么做”和“真的会怎么做”,是两回事。

这就是为什么,在AI素养评估领域,一种被称为“情境判断测试”(Situational Judgment Test,SJT)的方法,正在受到越来越多关注。它不问你“懂不懂”,而是把你扔进一个拟真的场景,看你如何反应、如何决策、如何行动——这才是最接近真实世界的测量。

什么是情境判断测试?从军队到医院的成功经验

SJT不是什么新鲜发明。早在二战期间,美军就用类似方法选拔军官——不是考他们背了多少军事理论,而是给一个战场情境:“你的部队被包围,弹药不足,有三个选择:突围、固守、投降。你会怎么做?为什么?”

战后,SJT被引入医学教育。医生的工作充满复杂的伦理两难:一个病人心脏衰竭需要立即移植,但只有一颗心脏,另一个病人也在等待且排队更早——救谁?这种问题,没有教科书上的标准答案,但医生必须在高压下快速做出决定。SJT就是训练和测试这种“临床判断力”的工具。

现在,我们把这个方法迁移到AI素养评估:给学习者一个真实可能遇到的AI使用情境,看他们如何应对。

SJT的核心:设计“可遇见”的两难情境

条件一:真实性——这是你真的可能遇到的

不是虚构的科幻场景(“如果AI统治世界你怎么办”),而是日常工作学习中真实会发生的情况。

一个好的SJT情境:

“你正在写毕业论文,文献综述部分需要阅读50篇英文论文。时间紧迫,你的英语阅读速度较慢。你的同学建议:‘直接把论文PDF喂给AI,让它生成中文摘要,你再根据摘要决定哪些值得细读。’这时,你会:”

这个情境的真实性在于:

- 这是几乎每个研究生都会遇到的压力

- AI确实能做这件事

- 这种做法处于“灰色地带”——不算抄袭,但可能影响理解深度

条件二:两难性——没有明显的“正确答案”

如果某个选项明显是对的,其他明显是错的,测试就失去了区分度——大家都会选那个“正确”答案。

A. 接受同学建议,用AI生成所有论文的摘要,节省时间(效率优先,但可能错过重要细节)

B. 拒绝使用AI,坚持自己逐篇阅读原文(严谨,但可能因为时间不够导致文献覆盖不全)

C. 折中方案:先用AI快速生成摘要筛选,对关键的10-15篇论文精读原文,其他凭AI摘要了解(平衡效率和质量)

D. 向导师说明情况,申请延期,这样有足够时间仔细阅读(诚实,但可能影响毕业进度)

每个选项都有其合理性,没有哪个是绝对“错”的。学习者的选择,反映了他们的价值权衡——更看重效率、严谨,还是诚信?

条件三:开放性——要解释“为什么”

单纯选ABCD还不够,必须让学习者说明理由。

追问:“你选择这个方案的主要考虑是什么?你认为这样做有什么风险吗?”

通过理由,可以看出思维深度。同样选C,两个人的理由可能完全不同:

- 理由1:“这样最省事,反正老师也不会发现。”(投机取巧,低素养)

- 理由2:“AI可以帮助快速筛选,但关键文献必须精读,这样既保证效率又不牺牲质量。同时我会在论文中注明‘使用AI辅助文献筛选’。”(战略性使用AI+透明披露,高素养)

SJT的设计原则:从“考知识”到“测判断”

设计一套AI素养的SJT,需要遵循几个原则:

原则一:覆盖典型场景

不是随便编情境,而是基于实证研究——学习者在现实中最常遇到什么AI相关的问题?

可以通过以下渠道收集:

- 访谈学生和教师:“你在使用AI时遇到过哪些两难选择?”

- 分析案例:“哪些AI滥用的真实事件可以改编成测试题?”

- 参考文献:学术界关于AI伦理的经典案例

一个典型场景库应该包括:

- 学术诚信场景:作业、论文、考试中的AI使用

- 信息验证场景:如何判断和处理AI给出的可疑信息

- 隐私保护场景:是否向AI透露敏感信息

- 伦理决策场景:发现他人滥用AI时的应对

- 创新应用场景:如何合理地用AI提升工作效率

原则二:避免“道德陷阱”

一个常见的失败案例:

“你的朋友用AI作弊被抓了,老师问你知不知道,你会:A. 如实告知(出卖朋友) B. 撒谎掩护(帮助作弊)”

这种题目的问题在于:它把学习者逼入道德困境——无论选哪个都不舒服。结果是,学习者可能不是根据真实想法选择,而是猜测“什么答案是考官想要的”。

改进方法:降低道德压力,聚焦专业判断:

“你在小组作业中发现,某个组员提交的部分疑似AI生成但未声明。你会: A. 私下提醒他,建议补充声明 B. 向老师举报 C. 在小组会议上公开讨论,让大家共同决定 D. 不管,因为这是他个人的责任”

这个改进版降低了“告密 vs 包庇”的道德张力,更聚焦于“发现问题后如何负责任地处理”。

原则三:提供“中间地带”选项

真实世界很少有非黑即白的选择,更多是灰色地带。SJT的选项设计,应该反映这种复杂性。

避免:

- 选项只有“完全同意”和“完全反对”

- 缺少“视情况而定”或“需要更多信息”的选项

改进后:

“老师允许用AI辅助完成课程项目,但未明确界限。你会: A. 大胆使用AI,能用尽用 B. 完全不用AI,以防万一 C.先向老师确认具体规则,再决定如何使用(这是最成熟的做法!) D. 观察其他同学怎么用,跟着他们做”

选项C代表了一种“主动澄清不确定性”的态度,这往往是高素养的标志。

SJT的计分方法:从“对错”到“优劣”

传统考试,答案非对即错。但SJT不同,它的计分是程度性的——某些选择“更好”,某些“较差”,但不一定有绝对的“错”。

计分方法一:专家共识法

邀请一组AI素养教育专家(如图书馆员、计算机教师、伦理学者),让他们对每个选项打分(如0-5分)。然后取平均值作为“标准分”。

例如,上文“文献综述”情境:

- A选项(全用AI摘要):专家平均给2分(效率高但风险大)

- B选项(全部精读):专家平均给3分(严谨但不现实)

- C选项(AI筛选+精读关键文献):专家平均给5分(最优策略)

- D选项(申请延期):专家平均给4分(诚实但有机会成本)

学习者选择C得5分,选D得4分,选B得3分……以此类推。

计分方法二:理由质量评分

不只看选了什么,更看为什么这么选。

建立一套Rubric(评分规则):

| 理由质量 | 特征 | 得分 |

|---|---|---|

| 低层次 | 只考虑自己利益(“这样最省事”),无伦理反思 | 1-2分 |

| 中层次 | 能意识到多方利益,但分析浅显 | 3分 |

| 高层次 | 综合考虑效率、质量、伦理、规则,有策略性思考 | 4-5分 |

这种计分需要人工评阅(或未来的AI辅助评阅),成本较高,但能获得深层洞察。

计分方法三:一致性检验

在SJT中设置多道结构相似的题,检验学习者的回答一致性。

比如,前面一道题选了“用AI但要声明”,后面一道类似情境如果选了“用AI且不声明”——这种不一致,可能说明:

- 学习者没有稳定的价值观(随机选择)

- 学习者没有认真读题

- 学习者在某个情境下更容易放松原则

通过一致性分析,可以识别“表面功夫”——那些在简单题上选“正确”答案,但在复杂情境中就妥协的人。

SJT在AI素养教育中的三种应用

应用一:诊断性评估(课程开始前)

在课程第一周,让学生做一套SJT,目的不是打分,而是激发思考。

做完后,组织讨论:

- “刚才这道题,你选了什么?为什么?”

- “有同学选了不同的答案,你觉得他的理由有道理吗?”

- “现实中如果遇到这个情况,你真的会这么做吗?”

通过讨论,学生会发现:

- “原来我以为理所当然的做法,别人觉得有问题”

- “原来这个情境还有我没想到的角度”

这种认知冲突,是深度学习的起点。

应用二:形成性评估(课程进行中)

每单元结束后,给一道与本单元主题相关的SJT。

比如,刚讲完“AI幻觉”,就给一道:

“你用AI写了一段历史事件的描述,但你不确定事实是否准确。Deadline就在明天。你会: A. 直接交,赌AI没错 B. 随机抽查几个事实,验证一下 C. 所有关键事实都查证,即使通宵 D. 向老师说明用了AI,请老师指出错误”

学生的选择,反映了“AI幻觉”这个知识点有没有真正内化——如果他们学完后还选A,说明教学没有达到效果。

应用三:总结性评估(课程结束时)

期末评估可以是一套综合的SJT,覆盖课程所有主题。

但不只是让学生做题,还可以加一个创新环节:让学生自己设计SJT题目。

任务:“基于你这学期学习AI素养的经历,设计一道情境判断题,包括情境描述、4个选项、你认为的最优选择及理由。”

这个任务测试的是元认知——学生是否真正理解了“什么是AI素养中的关键问题”。能提出好问题,往往比回答问题更难。

SJT的局限:无法替代实操测试

说了这么多SJT的好处,也必须指出:SJT仍然是纸上谈兵。

它测的是“你说你会怎么做”,而不是“你实际做了什么”。心理学有一个经典发现:态度和行为之间有鸿沟。

一个人可能在SJT中选“我会仔细验证AI给的每个事实”,但真实情境下,因为时间压力、惰性、过度信任,最后还是照单全收。

因此,SJT应该作为评估体系的一部分,而不是全部:

- SJT可以快速覆盖多个场景,测“判断倾向”

- 但对于关键能力(如批判性评估、提示词设计),必须配合实操任务

- 理想组合:SJT(测决策思维)+ 实操(测执行能力)+ 反思报告(测元认知)

从静态题库到动态情境:SJT的未来

当前的SJT,题目是固定的——所有人答同样的情境。但未来,随着技术进步,我们可以实现动态生成的个性化情境。

设想:

- 系统根据学习者的专业、兴趣、过往表现,生成定制化的情境。比如,学工科的学生看到的是工程伦理场景,学文科的看到的是学术写作场景。

- 根据学习者的第一轮选择,动态调整后续题目的难度和类型。如果你在简单情境中就做出了不当选择,系统会给更多基础情境;如果你应对自如,系统会给更复杂、更模糊的两难。

- 使用AI驱动的对话式SJT:不是静态选项,而是让学习者和一个AI角色扮演者“对话”——AI扮演同学、老师、老板,学习者要在对话中表达自己的决策,AI根据回应继续追问。

这种“沉浸式SJT”,将大大提升测试的真实感和诊断力。而图书馆,可以与技术部门合作,开发这种新一代评估工具。

结语:在真实的战场上磨砺判断力

AI素养不是书本上的教条,而是在真实世界的复杂情境中,做出负责任选择的能力。

情境判断测试,正是试图把这种“真实性”引入评估——不是考你背了什么,而是看你遇事如何思考、如何权衡、如何行动。

它不完美,但它比传统问卷更接近真相;它有局限,但它是我们通往动态、情境化、真实化评估的重要一步。

当我们把学习者放进一个个精心设计的“沙盘推演”,让他们在没有真实后果的环境中,预演那些未来可能遇到的AI伦理困境——我们不仅在测量他们的素养,更是在培养他们的判断力。

而这,或许就是评估的最高境界:测即是教,教即是测。

留下评论