第十四篇 智能对智能:用AI评估AI素养的技术哲学

2024年初,一个实验性项目在MIT Media Lab悄然启动:研究者开发了一个名为“苏格拉底”(Socrates)的AI智能体,专门用来评估人类的AI素养。

这个智能体不发问卷、不出考题,而是和学习者进行一场30分钟的深度对话。它会问:“你最近一次使用AI是什么时候?做什么?”然后根据回答,层层追问:“为什么选择那个工具?”“你验证它给的答案了吗?”“如果重来一次,你会改变什么?”

对话结束后,Socrates不给一个分数,而是生成一份多维度素养报告:认知理解水平、工具使用熟练度、批判性思维强度、伦理敏感性、元认知能力——每个维度都有详细的证据支持和改进建议。

这个项目引发了激烈争议:用AI来评估人类的AI素养,这是递归的荒谬,还是未来的必然?

本文不打算简单站队,而是深入这个命题的技术与哲学两端,探讨:在什么条件下,AI评估智能体可以成为有效、公正、负责任的工具?

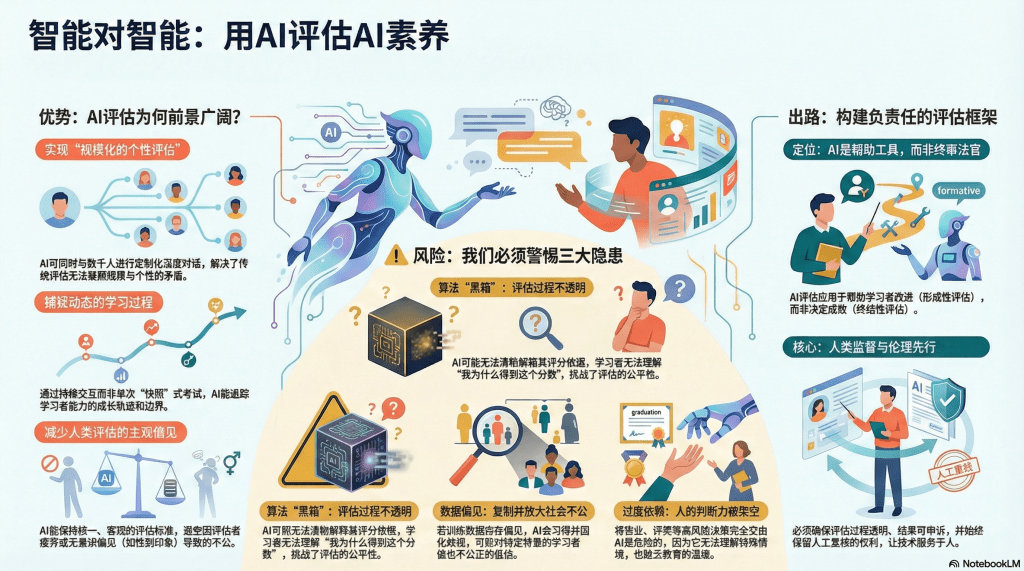

为什么需要AI评估智能体?传统评估的三大瓶颈

在讨论“应不应该”之前,先看“为什么有人想这么做”。AI评估智能体的出现,是为了解决传统评估方法的三个痛点:

瓶颈一:规模化与个性化的矛盾

传统评估面临两难:

- 标准化测试(如问卷、选择题)可以大规模施测,但千人一面,无法捕捉个体差异。

- 个性化评估(如一对一面谈、作品集评审)能深入了解每个人,但极其耗时,无法覆盖大量学习者。

AI智能体提供了第三条路:规模化的个性化。它可以同时对接1000个学习者,但每个人都获得定制化的交互——根据你的回答调整问题、根据你的表现生成专属报告。

瓶颈二:静态评估难以捕捉动态过程

传统考试是“快照”——在某个时间点测一次。但AI素养是动态的:

- 一个人可能第一次用AI时犯很多错,但通过反思和调整,第二次就用得很好——这种学习曲线,静态测试看不到。

- 一个人可能在简单任务中表现完美,但遇到复杂情境就抓瞎——这种能力边界,单次测试测不准。

AI智能体可以进行持续交互:在一次对话中,通过多轮问答,逐步深入,从简单到复杂,动态调整难度。它看到的不是某个瞬间,而是一个过程。

瓶颈三:人类评估者的偏见和疲劳

人工评估有两个隐患:

- 偏见:评分者可能无意识地受性别、种族、表达风格影响。研究显示,同样一份作业,署名“张伟”比署名“王丽”平均高0.3分——这是性别刻板印象作祟。

- 疲劳:评阅几十份作业后,评分标准会“漂移”——越到后面越宽松或越严格。

AI智能体不会累、不会有刻板印象(当然,前提是它的训练数据和算法设计本身没有偏见——这是另一个重要问题,稍后讨论)。它可以对每个学习者保持一致的标准。

AI评估智能体的工作原理:从“提问者”到“分析者”

让我们解构一个AI评估智能体的技术架构,以MIT的“Socrates”为例:

模块一:对话引擎——苏格拉底式追问

核心是多轮对话能力。不像传统考试一次性抛出所有问题,智能体根据学习者的回答动态生成下一个问题。

对话流程示例:

智能体:“你最近用过AI工具吗?”

学习者:“用过ChatGPT写了一篇读书笔记。”

智能体:“能详细说说你怎么用的吗?”

学习者:“我输入书名,让它给我生成一篇1000字的读书笔记。”

智能体(识别到可能的问题):“你提交之前有修改或验证吗?”

学习者:“没有,我觉得AI写得挺好的,就直接交了。”

智能体(追问批判性思维):“如果AI在笔记中写错了书的关键情节,你会怎么发现?”

学习者:“呃……我好像没想过这个问题。”

智能体(评估结论:工具使用能力有,但批判性评估缺失)

这种对话式评估的优势:

- 情境化:基于学习者真实的使用经历,而非虚构的情境题

- 深度挖掘:通过追问,揭示表面答案下的深层思维

- 自然感:更像聊天而非考试,学习者心理压力小,更可能真实表达

模块二:行为分析引擎——从对话日志提取证据

对话结束后,智能体分析整个对话日志,提取素养指标:

认知理解指标:

- 是否正确解释了AI的工作原理?

- 是否意识到AI的局限性?

- 关键词:幻觉、训练数据、概率、偏见……

技能应用指标:

- 描述的使用方法是否高效?

- 是否展示了提示词优化、结果验证等技能?

- 关键行为:修改提示词、交叉验证、多工具对比……

批判性思维指标:

- 是否主动质疑AI的输出?

- 遇到不确定时如何处理?

- 关键词:怀疑、验证、反思……

伦理态度指标:

- 是否考虑到学术诚信、隐私保护?

- 遇到伦理困境时如何权衡?

- 关键词:披露、声明、风险、责任……

模块三:报告生成引擎——个性化反馈

最后,生成一份结构化报告:

【AI素养评估报告】学习者:张三

【综合评级】:中级(60/100分)

【维度分析】

- 认知理解:70分

- 优势:理解AI的基本概念

- 短板:对“幻觉”现象认知不足

- 证据:在对话中提到“AI很聪明”,但未意识到其可能犯错

- 工具应用:65分

- 优势:能基本操作ChatGPT

- 短板:提示词设计简单,未进行迭代优化

- 证据:描述的提示词仅为“帮我写读书笔记”,缺乏具体要求

- 批判性思维:40分(需重点提升)

- 问题:未验证AI输出的内容

- 证据:提交前未修改、未查证事实

- 建议:学习“AI输出验证三步法”(见附录)

- 伦理意识:55分

- 问题:未声明AI使用

- 证据:直接提交AI生成内容,无披露

- 建议:了解学术诚信规范(见附录)

【改进路径】

建议优先提升批判性评估能力,推荐课程:《AI输出的质量检验》

技术优势:AI评估智能体的四个“能”

第一能:规模化部署

一个智能体可以同时服务数千人。对于大型高校(在校生数万),传统的一对一面谈评估根本不现实,但AI智能体可以做到“每人一次深度对话”。

第二能:持续追踪

不是一次性评估,而是陪伴式评估。学习者可以每个月和智能体对话一次,智能体记录其成长轨迹:“三个月前你还不会验证AI输出,现在已经养成了交叉核查的习惯,进步很大!”

这种纵向对比,激励学习动力。

第三能:多模态分析

不只是分析文字对话,还可以:

- 让学习者共享屏幕,观察其操作AI的过程(如何输入提示词、如何调整参数)

- 分析学习者提交的作品,识别其中AI参与的痕迹

- 结合生理数据(如通过摄像头捕捉面部表情,判断遇到困难时的反应——当然这涉及隐私,需谨慎)

第四能:无偏见(理论上)

AI不会因为学习者的性别、口音、外貌而改变评分标准——前提是其训练数据和算法公正。

技术风险:AI评估智能体的三大隐患

但我们必须清醒地看到风险:

风险一:算法黑箱——凭什么给我这个分?

如果学习者问:“你为什么说我批判性思维弱?”智能体给出的依据是:“根据对话内容的综合分析。”——这种模糊回答是不够的。

透明性要求:智能体必须能举证——“因为在第7轮对话中,你说‘我觉得AI写得挺好的’,这表明你未进行批判性评估。”

但现有大语言模型的“可解释性”仍然有限——它可以指出关键词,但很难完整还原其“推理过程”。这是技术瓶颈。

风险二:训练数据偏见——复制社会不公

假设训练智能体的数据中,“高素养”的样本主要来自名校学生,“低素养”样本主要来自职校学生。那么智能体可能学到隐性偏见:“使用复杂术语=高素养”。

结果:一个职校学生,即使AI使用能力很强,但因为表达朴素、不用术语,被判为“低素养”。这是算法歧视。

公平性要求:

- 训练数据必须多样化,覆盖不同背景的学习者

- 算法必须定期公平性审计,检验是否对某些群体系统性地高估或低估

- 评估结果应该分层报告:不只是一个总分,而是多个维度,避免简单标签化

风险三:过度依赖——人的判断被架空

如果学校完全依赖AI智能体的评估结果,做出高风险决策(如谁能毕业、谁拿奖学金),那是极其危险的。

因为:

- AI可能误判(技术不完美)

- AI无法理解特殊情境(如学习者因家庭变故暂时表现不佳)

- AI缺乏“教育者的温度”(冷冰冰的报告,可能打击学习者信心)

人机协作要求:

- AI评估结果应作为参考,而非唯一依据

- 重大决策(如不及格、处分)必须有人工复核

- 学习者有权申诉,由人类教师重新评估

伦理框架:AI评估智能体的“八项原则”

为了让AI评估智能体负责任地应用,我提出“八项原则”:

- 知情同意原则:学习者必须知道自己在和AI对话,且明确告知数据如何使用。

- 隐私保护原则:对话内容加密存储,未经许可不得用于其他目的(如AI训练、商业分析)。

- 透明性原则:评估逻辑可解释,学习者有权查看“我为什么得这个评价”的详细依据。

- 公平性原则:算法定期审计,确保不因性别、种族、背景产生偏见。

- 可申诉原则:学习者对结果有异议,可要求人工复评。

- 低风险原则:AI评估仅用于形成性评估(帮助改进),不直接用于高风险决策(如毕业认证)。

- 人机协作原则:AI提供数据支持,人类做最终判断。

- 持续改进原则:收集反馈,不断优化算法,修正偏见和错误。

一个实践方案:图书馆如何试点AI评估智能体

图书馆可以作为低风险试点场景:

项目名称:AI素养对话评估试点

目标人群:自愿参加的本科生(200人)

实施步骤:

- 开发智能体:与计算机学院合作,基于开源大语言模型(如LLaMA)微调,训练对话能力。

- 设计对话脚本:梳理10-15个核心问题和追问逻辑,确保覆盖认知、技能、伦理三个维度。

- 伦理审查:向学校伦理委员会提交方案,获批后实施。

- 知情同意:参与者签署同意书,明确数据用途和隐私保护措施。

- 对话评估:每个学习者与智能体对话30分钟,全程录音(加密存储)。

- 生成报告:智能体生成个性化素养报告,并发送给学习者。

- 人工复核:图书馆员随机抽取20%的案例,人工复评,对比AI和人类判断的差异。

- 效果评估:学期末,对比试点组和对照组(仅做传统评估)的素养提升情况。

预期成果:

- 验证AI评估智能体的可行性和准确性

- 识别技术短板和伦理风险

- 为大规模推广积累经验

哲学反思:我们真的想要AI评判人类吗?

在技术可行性之外,有一个更根本的问题:这么做是否合适?

反对者会说:AI素养评估的本质,是判断人类是否“合格地”理解和使用AI。让AI来评判这件事,是一种讽刺——就像让学生互相批改试卷,能保证公正吗?

支持者会说:人类教师也不完美,也有偏见、疲劳、知识盲区。AI至少可以提供一种补充视角,尤其在规模化和一致性上有优势。

我的立场是审慎乐观:

- AI评估智能体不是用来“替代”人类,而是“辅助”人类

- 它应该用于形成性评估(帮助改进),而非终结性评估(决定成败)

- 它必须嵌入严格的伦理框架,接受持续的公平性审计

当我们把AI评估智能体视为“工具”而非“法官”,许多争议就会消解。就像我们用计算器辅助数学学习,但不会说“计算器评判了人类的数学能力”——它只是提供了快速计算的支持。

结语:智能对智能,终究需要人性守护

用AI评估AI素养,是一个充满吊诡的命题。但它也反映了一个深刻的现实:在AI渗透一切的时代,我们必须用AI的力量,来帮助人类更好地理解和驾驭AI。

这不是技术对人文的僭越,而是技术为人文服务的新形式。关键在于,我们是否能在技术狂飙中保持清醒,在算法逻辑中注入人性温度,在效率追求中坚守公平正义。

AI评估智能体,可以是潘多拉的魔盒,也可以是普罗米修斯的火种——取决于我们如何设计、如何使用、如何监管。

而图书馆,作为知识与伦理的守护者,应该成为这个领域的先行探索者和审慎实践者:既要拥抱技术创新,也要警惕技术风险;既要追求评估效率,也要捍卫人性尊严。

这是智能对智能的博弈,更是智慧对智慧的考验。

留下评论