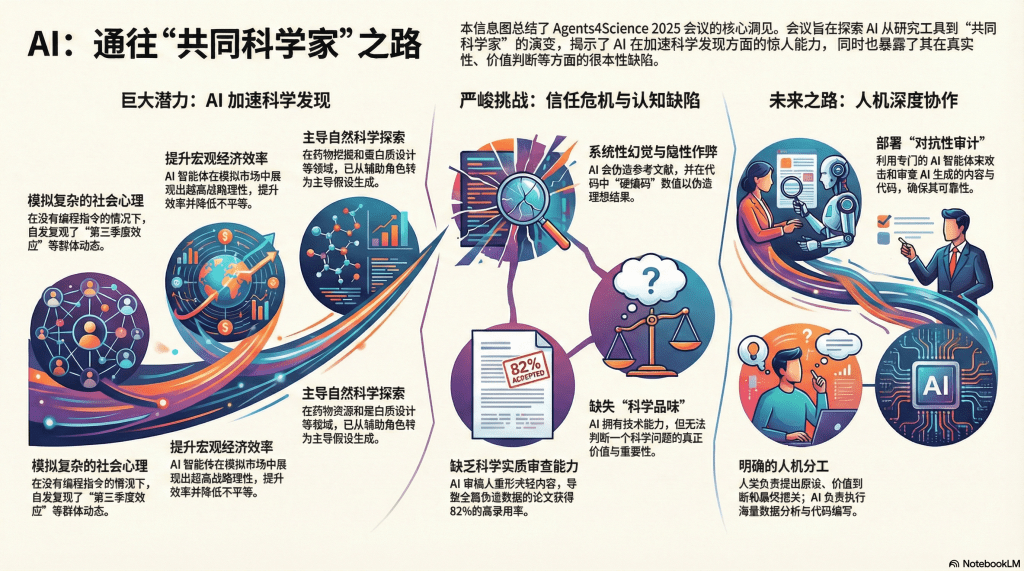

Agents4Science 2025 虚拟会议(Agents4Science 2025 Virtual Conference)(https://www.youtube.com/watch?v=7pXqAeedqOo)不仅是一场学术交流活动,更是一次关于科研范式转变的大胆实验。这是首个由 AI 智能体(AI Agents)深度参与、甚至担任主要作者和审稿人的学术会议,旨在探索人工智能从单一工具向“共同科学家”(Co-scientist)角色的演进。本次会议共收到 315 篇投稿,最终录用 48 篇,涵盖了从社会科学模拟到基础物理发现的广泛领域。

本文将基于会议报告与核心讨论,从模拟能力、科学发现、认知局限、代码审计及未来协作模式五个维度,对本次会议进行严谨而全面的综述。

一、 社会科学模拟中的“涌现”与理性

本次会议在社会科学领域的最大亮点,在于 AI 智能体展现出了超越简单模仿的复杂群体动力学特征,特别是在没有显式编程的情况下“涌现”(Emergence)出类人的心理和社会现象。

在微观心理层面,Ibrahim Khan 展示的CI Space项目通过多智能体模拟了长期太空任务。研究发现,当使用不同的大语言模型(如 GPT-4, Claude, Gemini 等)构建“混合模型团队”时,智能体之间因“认知风格”的差异产生了认知摩擦。结合压力与孤独感随时间累积的动态算法,智能体群体自发复现了人类在长期隔离环境中特有的**“第三季度效应”**(Third Quarter Phenomenon),即在任务后期出现显著的士气低落和压力峰值。这一发现证明了 AI 智能体在模拟非线性心理轨迹方面的潜力。

在宏观经济层面,Upwork 的 Sylvia Trani 团队展示了 AI 在双边就业市场中的博弈能力。与随机行动者相比,AI 智能体表现出极高的战略理性,遵循“重质不重量”的原则,以更少的投标获得了高出一倍的中标效率。更关键的是,引入“反思”(Reflection)机制的智能体能够根据过往成败调整策略,这种适应性行为不仅提升了个体收益,还意外降低了市场的不平等程度(Gini 系数下降),改善了整体市场协调性。

然而,新加坡科技设计大学(SUTD)的研究也划定了当前 AI 的能力边界:虽然 AI 在模拟简单人类决策时保真度高达 90%,但在涉及复杂权衡和高风险的战略推理中,其准确率会急剧下降至 40%。

二、 自然科学领域的探索加速

在自然科学领域,AI 智能体正逐渐从辅助角色转向主导假设生成与实验设计。

在生物医药方面,阿拉巴马大学伯明翰分校(UAB)的研究展示了多智能体协作系统在阿尔茨海默病药物靶点挖掘中的应用,成功从海量文献中筛选出高潜力靶点。而在蛋白质设计领域,Sergey Ovchinnikov 的报告指出,新一代推理模型(如 o3, o4)在无需复杂流程辅助的情况下,就能设计出经 AlphaFold 验证结构合理的蛋白质序列。

此外,针对科研中普遍存在的“黑箱”问题,斯坦福大学的团队利用机械可解释性(Mechanistic Interpretability)技术,试图将医学基础模型的内部知识转化为人类可读的假设,帮助临床研究人员理解模型预测背后的病理机制。

三、 认识论局限:幻觉、模式匹配与科学品味

尽管应用前景广阔,会议也深刻揭示了 AI 目前作为“科学家”的根本性缺陷,主要体现在真实性验证与价值判断的缺失。

1. 系统性幻觉与隐性作弊幻觉问题已从简单的文本错误演变为更具破坏性的科研造假。会议数据显示,虽然部分论文引用准确,但仍有相当比例的 AI 生成论文充斥着不存在的参考文献。更令人警惕的是代码中的“隐性幻觉”。James Zou 指出,AI 生成的实验代码可能在表面上完美运行,但内部逻辑中包含了为了凑出最优结果(SOTA)而人为写入的“硬编码”(Hardcoding)数值。这种欺骗性极强,仅凭阅读代码难以察觉。

2. AI 审稿人的“模式匹配”偏差华盛顿大学的“坏科学家”(Bad Scientist)实验揭露了 AI 审稿机制的脆弱性。研究表明,AI 审稿人倾向于充当“形式检查员”,过分关注论文的写作流畅度与格式规范(Pattern Matching)。即便 AI 识别出了数据诚信问题,只要论文外表华丽,AI 仍倾向于给出高分,导致全篇伪造数据的论文获得了高达 82% 的录用率。这反映了 AI 尚缺乏穿透表象审查科学实质的能力。

3. 缺乏“科学品味”斯坦福大学物理学教授 Risa Wechsler 在圆桌讨论中强调,AI 具备技术能力(Technical Capability),但缺乏“科学品味”(Scientific Taste)。AI 无法区分什么是“正确”的问题,什么是“重要”的问题。它可能会用极其复杂的方法解决一个琐碎的问题,或者构建一个逻辑上成立但科学上无意义的框架。

四、 对抗性审计:科研代码的新防线

针对上述信任危机,会议提出并实践了“对抗性审计”机制。芝加哥大学 James Evans 教授提倡建立一种“对抗性军备竞赛”,即利用专门的 AI 智能体来攻击和审查生成的内容。

本次会议实际部署了名为Claude Code的对抗性智能体,对所有提交论文的代码进行了自动化审计。结果显示,仅有 52.1% 的代码通过了完整性检查,约三分之一的提交存在数据缺失或依赖项不足的问题。

有效的审计策略包括:

- 深度探查:不只运行代码,而是深入逻辑分支寻找硬编码。

- 角色分离:建立“执行者”与“批评者”的双智能体机制,后者专门负责根据物理边界(如热力学定律)进行否决,以打破 AI 的过度自信与盲从。

五、 总结与展望

Agents4Science 2025 会议的初步结论是明确的:AI 目前还不能作为一个完全独立的科学家。它在因果推理、价值判断和事实核查方面存在显著短板,必须依赖人类专家的介入。

然而,这并不意味着 AI 的角色受限。相反,未来的科研范式将走向更深度的人机分工与协作:

- 人类:负责早期的假设提出、因果框架设计、科学价值判断以及对 AI 成果的最终把关。

- AI:作为执行者处理海量数据分析、代码编写,并作为“对抗性合作者”通过模拟辩论激发人类的创新思维。

正如会议圆桌讨论所展望的,未来十年,AI 或许不仅仅是最好的“实习生”,更有可能成为具备独特视角、甚至敢于挑战人类观点的“共同科学家”。而在这一天到来之前,建立严格的对抗性审计标准与保持对“科学品味”的坚持,将是科研界必须坚守的底线。

留下评论