从AI输出到AI话语:批判转向的方法论创新

文章核心观点概述

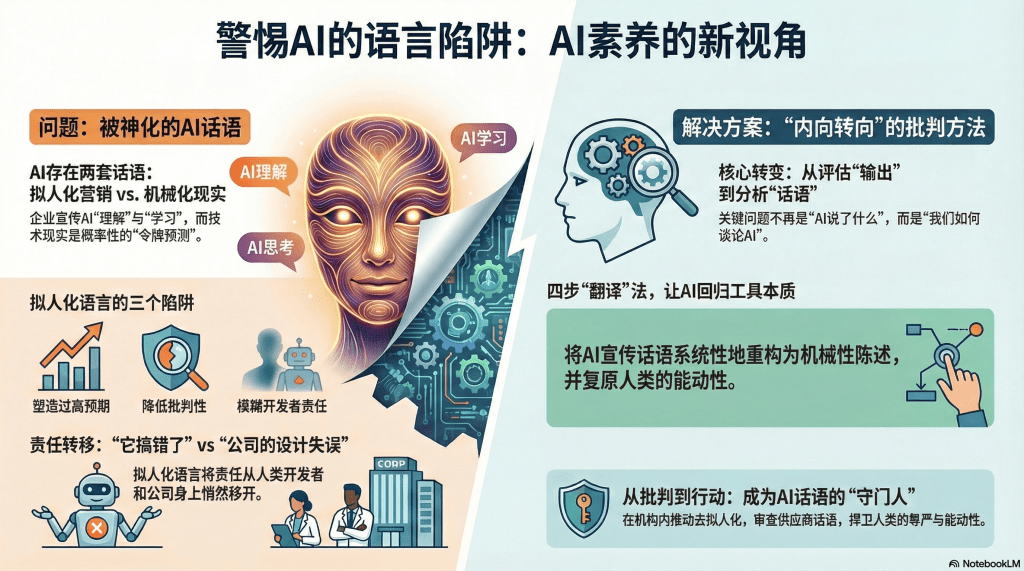

威廉玛丽学院Troy Davis在《内向转向:从AI输出到AI话语》中,提出AI素养教育的根本性方法论转向:从评估AI生成的内容,转向批判性分析描述AI的语言本身。

核心论点:

第一,存在两套话语体系。企业博客充斥拟人化表述(系统“理解”、模型“学习”、助手“知道”),而技术文章使用概率分布、令牌预测等机械性描述。“两套话语体系,同一种技术。那个差距……是一个经典的信息素养问题。”

第二,“AI素养”术语可能是问题的一部分。它将AI自然化为需要专门知识的连贯类别,可能让从业者感到“我还不够格”。

第三,图书馆员已拥有所需技能。“我们不需要新的素养。我们有我们已经实践的。”ACRL框架完全适用于分析AI话语。

第四,Discourse Depot项目示范了去拟人化方法。系统性地将拟人化表述重新框定为:机械性陈述、技术现实核查、人类能动性复原。

“内向转向”的理论意义

这不是简单的研究对象转换,而是认识论层面的范式转变:

传统AI素养:评估输出准确性、偏见、引文。

“内向转向”后:分析话语——我们用什么语言谈论AI?这种语言建构了怎样的权威?拟人化修辞服务于谁的利益?

理论意义:AI不仅是技术对象,更是话语对象。我们对AI的理解,不仅取决于AI“实际上是什么”,更取决于“被描述成什么”。

这呼应了批判话语分析核心洞察:语言不是中立描述工具,而是权力运作场所。

乔治城大学案例的启示

乔治城大学隐私与技术中心意识到“他们自己的语言正在削弱他们的批判使命”,应对不是“学习工具”,而是四项自律原则:对技术功能保持具体、承认企业不透明性、指明负责公司、将能动性归于人类。

启示:即使批判性机构,也会不经意间被主流话语俘获。图书馆员进行AI素养教育时,必须首先审视自己是否在复制拟人化话语。

Discourse Depot的方法论价值

四步分析框架:原始拟人化表述→机械性重构→技术现实核查→人类能动性复原。

例如,将“AI可以作为对话伙伴,解释概念”重构为“该界面允许用户迭代查询模型……生成与训练数据中‘解释’模式统计相关的文本”,指出“模型不会‘作为伙伴’”,归因于“谷歌开发了这个界面……鼓励用户提供更多数据”。

价值:不只是批判,更是建构——建构替代性的、去魅的AI话语。

对教育的启示:让学生练习“翻译”AI宣传材料——识别拟人化表述、用机械性语言重述、分析谁从中受益。

拟人化话语的权力效应

拟人化不是无害修辞,而是“塑造预期、校准信任、模糊问责”的策略:

塑造预期:期待类人智能而非统计匹配,导致过度信任。

校准信任:拟人化建立情感连接,降低批判性。

模糊问责:“它搞错了”vs“开发公司设计失误”——能动性语言转移责任。

关键洞察:上游(话语层面)的uncritical采用,影响下游(实践层面)的一切——政策制定、法律责任、教育目标。

中国语境下的话语批判

复杂性:中国传统“物我交融”哲学、科幻文化影响(《三体》)、中文语言结构(“它”无性别区分)。

紧迫性:“AI老师/医生/法官”称谓泛滥、智能音箱拟人化命名、政策话语(“AI向善”)预设道德能动性。

借鉴行动:分析科大讯飞/百度AI宣传、对比新闻报道中“AI诊断”vs“算法辅助诊断”、探讨中文特有拟人化表述。

从批判到行动:倡导角色

图书馆员不应止于教育,还应倡导话语改变:

- 推动本机构去拟人化政策

- 审查供应商话语

- 参与公共讨论普及去拟人化观点

这不是“吹毛求疵”,而是通过语言斗争捍卫人类能动性。

批判的边界

Davis的立场不是拒绝AI技术,而是拒绝对AI的神秘化和主体化。

去拟人化是让AI回归其本来面目:强大但有限的工具。只有停止把AI想象为“智能主体”,才能清醒评估其能力和局限,更好地使用它、规制它、超越它。

结语:语言的批判,就是思想的解放

最深刻的批判不是指向技术本身,而是指向我们谈论技术的方式。

当我们停止说“AI理解”,开始说“系统生成统计上可能的输出”;停止说“AI决定”,开始说“算法设计者的价值判断被编码进系统”——我们就完成了一次思想解放。

这种解放让我们在清醒中使用AI,在批判中塑造AI,在警惕中保持人类尊严。

图书馆员,作为批判性信息素养教育的专业群体,天然是这场“语言解放运动”的领导者。我们不需要成为AI工程师,但可以、也应当成为——AI话语的守门人和批判者。

留下评论