架构解密——灵活的模型调用与技能生态

引言:庖丁解牛,游刃有余

《庄子·养生主》记载庖丁为文惠君解牛的故事:"彼节者有间,而刀刃者无厚;以无厚入有间,恢恢乎其于游刃必有余地矣。"这个故事比喻对事物肌理的深刻理解和运用自如的技艺。用来形容OpenClaw的架构设计,颇为贴切——它没有创造新的"刀"(底层模型),而是找到了现有技术之间的"间隙"(模型不可知、可插拔技能),以精巧的工程设计实现了"游刃有余"的灵活性。

在前几篇文章中,我们讨论了OpenClaw的现象、创新和争议。但要真正理解这个产品的独特性,必须深入其技术架构的核心:它如何实现多模型的无缝切换?3000多个技能如何协同工作?这种"瑞士军刀"式的设计哲学有何优势和局限?对于考虑构建类似系统的图书馆和研究机构来说,这些技术细节不仅是学习的对象,更是决策的依据。

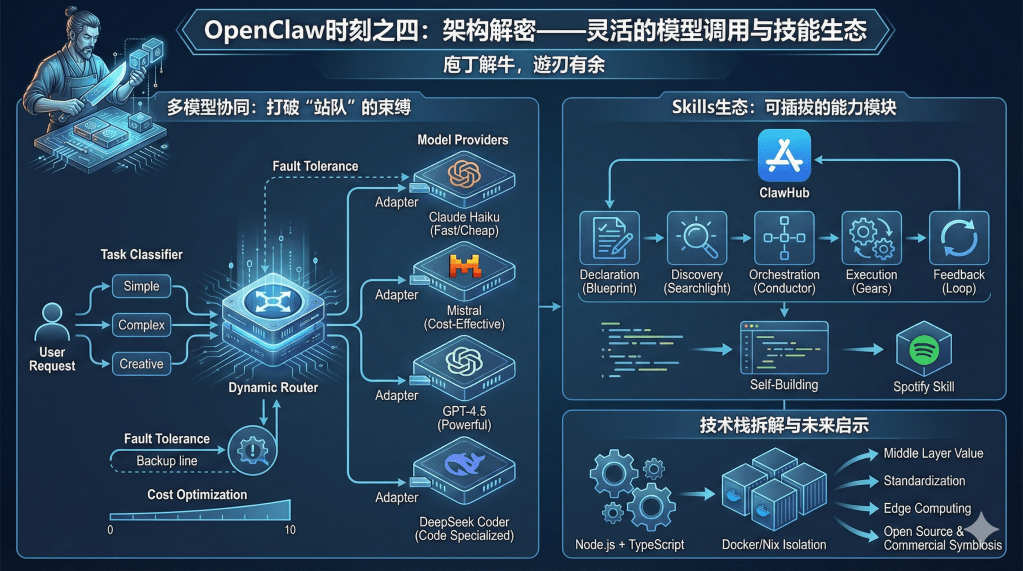

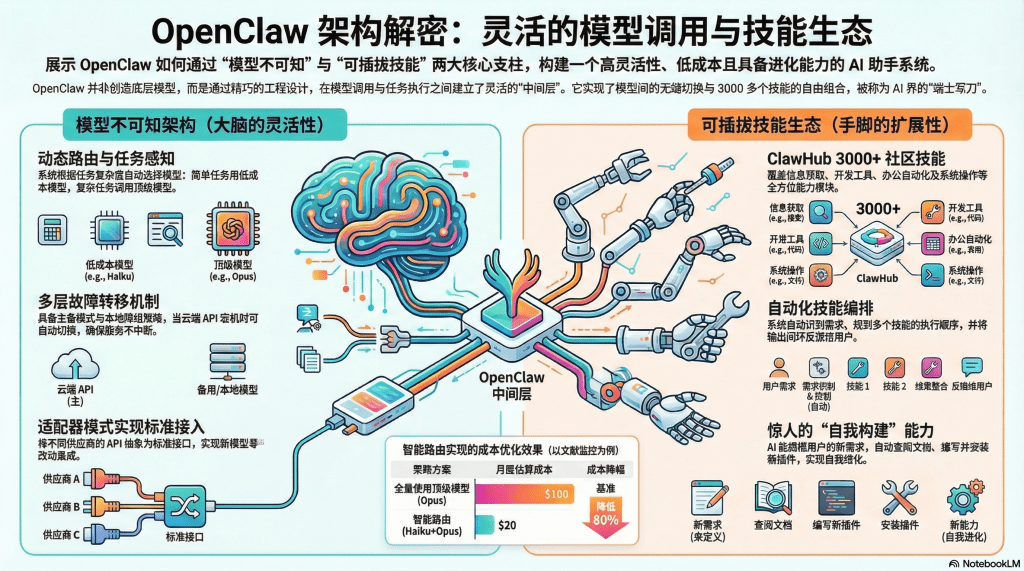

多模型协同:打破"站队"的束缚

OpenClaw最引人注目的技术特性之一,是它的"模型不可知论"(Model-Agnostic Architecture)。这不仅是一个技术选择,更是一种哲学立场——拒绝被任何单一模型供应商绑架,通过灵活的路由机制实现"各取所长"。

动态路由:任务感知的模型选择

在传统AI应用中,开发者通常在项目初期就选定一个模型(如OpenAI的GPT或Anthropic的Claude),然后所有任务都交给这个模型处理。这种做法简单直接,但缺乏灵活性:顶级模型处理简单任务是资源浪费,便宜模型处理复杂任务则力不从心。

OpenClaw采用了一种更聪明的策略:根据任务的性质和复杂度,动态选择最合适的模型。这个机制由两部分组成:

任务分类器:系统首先分析用户的请求,判断它属于哪种类型——是简单的信息提取(如"总结这篇文章的要点")、中等复杂度的推理(如"比较两个算法的优劣")、还是高难度的创造性工作(如"设计一个新的数据库架构")。

模型路由表:配置文件中预先定义了不同任务类型与模型的映射关系。例如:

- 简单任务 → Claude Haiku(速度快、成本低)

- 中等任务 → Kimi K2.5 或 Mistral(性价比高)

- 复杂任务 → Claude Opus 或 GPT-4.5(能力强)

- 代码任务 → DeepSeek Coder(专门优化)

这种路由不是静态的,而是可以根据实际效果动态调整。如果发现某个便宜模型在特定任务上表现出人意料的好,系统会记录这个"发现",未来自动使用它。这就像一个经验丰富的项目经理,知道哪个团队成员擅长什么,从而实现"人尽其才"。

故障转移:不把鸡蛋放在一个篮子里

模型不可知的另一个关键优势是容错能力。现实中,API服务经常出现各种问题:配额耗尽、网络超时、服务器维护、账号被封。如果应用只依赖单一模型,这些问题会导致服务完全中断。

OpenClaw内置了多层故障转移机制:

主备模式:为每个任务类型配置主力模型和备用模型。当主力模型调用失败时,自动切换到备用模型继续执行。

降级策略:如果所有云端模型都不可用,可以回退到本地模型(虽然能力较弱,但至少能保持基本功能)。

智能重试:对于临时性错误(如网络抖动),系统会采用"指数退避"策略重试——第一次等待1秒,第二次等待2秒,第三次等待4秒,以此类推。这样既能应对短暂故障,又不会过度消耗资源。

这种设计让OpenClaw具备了远超单一模型应用的鲁棒性。用户不必担心因为Anthropic服务器宕机就无法工作——系统会悄无声息地切换到GPT或其他备选方案,保持服务的连续性。

成本优化:花钱要花在刀刃上

模型不可知还带来了成本控制的灵活性。不同模型的定价差异巨大:Claude Opus的Token价格可能是Haiku的10倍以上。通过合理的任务分配,可以在保证质量的前提下显著降低成本。

一个真实案例:某位研究者使用OpenClaw监控学术文献更新。如果每次检查都用Opus,每天会消耗数千Token;但实际上,90%的检查结果是"没有更新",这种简单判断完全可以交给Haiku。只有当发现新文献时,才调用Opus进行深度分析和总结。通过这种分层策略,他将每月API费用从100美元降到了20美元,节省了80%。

对于图书馆等机构用户来说,这种成本优化尤为重要。假设一个图书馆要为1000名用户提供AI助手服务,如果每个用户每月产生50美元的API费用,总成本将高达5万美元——这对大多数图书馆来说是不可承受的。但通过智能路由,将大部分简单任务(如馆藏检索、续借提醒)交给便宜模型,只有复杂的学科咨询才用顶级模型,成本可以降到原来的1/5甚至更低。

技术实现:接口抽象的艺术

在代码层面,模型不可知是通过"适配器模式"(Adapter Pattern)实现的。OpenClaw定义了一组标准接口,所有模型调用都通过这个接口进行。当需要集成新模型时,只需编写一个适配器,将新模型的API转换为标准格式,而不需要修改核心逻辑。

以下是简化的示意(实际代码要复杂得多,但原理相同):

// 标准接口定义

interface ModelProvider {

async generate(prompt: string): Promise<string>;

async stream(prompt: string): AsyncGenerator<string>;

}

// Claude 适配器

class ClaudeAdapter implements ModelProvider {

async generate(prompt: string): Promise<string> {

// 调用 Anthropic API

return await callClaudeAPI(prompt);

}

}

// GPT 适配器

class GPTAdapter implements ModelProvider {

async generate(prompt: string): Promise<string> {

// 调用 OpenAI API

return await callOpenAIAPI(prompt);

}

}

// 路由器根据策略选择模型

const model = selectModel(taskType);

const response = await model.generate(prompt);

这种设计的优雅之处在于,它将"变化"(不同模型的具体实现)与"不变"(应用的核心逻辑)分离。当新模型出现时,应用可以零改动地集成;当某个模型被弃用时,只需移除对应的适配器。这种"面向接口编程"的思想,在软件工程中是经典范式,但在AI应用领域却长期被忽视。OpenClaw的成功再次证明,扎实的工程基础比炫酷的技术更重要。

Skills生态:可插拔的能力模块

如果说模型不可知解决了"大脑"的问题,那么Skills系统则赋予了OpenClaw"手脚"——让它能够与外部世界交互、完成实际任务。

ClawHub:技能的"应用商店"

OpenClaw的技能系统借鉴了现代操作系统的"插件"思想。就像智能手机可以通过安装App扩展功能,OpenClaw可以通过加载Skill扩展能力。ClawHub是这个生态的中心枢纽,相当于AI Agent的"App Store"。

截至2026年初,ClawHub已经收录了超过3000个社区贡献的技能,覆盖范围令人惊叹:

信息获取类:

- Exa神经搜索:使用语义理解而非关键词匹配来搜索网页

- Google Scholar集成:检索学术文献并提取引用信息

- RSS监控:订阅新闻源和博客更新

- 天气预报、股票行情、加密货币价格等实时数据

开发工具类:

- GitHub PR管理:自动审查Pull Request,提出修改建议

- 代码审查:检测潜在Bug和安全漏洞

- 文档生成:根据代码自动生成API文档

- 测试用例生成:为函数自动生成单元测试

办公自动化类:

- 邮件处理:自动分类、总结、起草回复

- 日程管理:解析自然语言创建日历事件(如"下周三下午和李教授讨论课题")

- 文档转换:PDF转Word、Markdown转PPT等

- 数据可视化:将Excel数据转为图表

系统操作类:

- 文件管理:批量重命名、整理、备份

- 屏幕截图:定时截图记录工作状态

- 系统监控:CPU、内存、磁盘使用率告警

- 脚本执行:运行Shell命令、Python脚本等

创意内容类:

- 图像生成:调用DALL-E、Midjourney等工具

- 音乐创作:生成MIDI或调用AI作曲API

- 视频剪辑:自动生成字幕、剪辑片段

- 翻译润色:多语言翻译和文本优化

这种丰富的生态使得OpenClaw从一个"聊天机器人"变成了真正的"数字员工"——它不仅能够理解你的意图,还能够采取行动来实现这些意图。

技能的工作机制:从声明到执行

每个Skill本质上是一个模块化的代码包,定义了特定的功能和调用接口。它们的工作流程大致如下:

声明阶段:Skill在安装时向系统注册自己的能力,包括:

- 能够处理什么类型的任务(如"搜索学术文献")

- 需要什么参数(如"关键词""发表年份")

- 预期的输出格式(如"JSON格式的文献列表")

发现阶段:当用户提出请求时,OpenClaw会分析这个请求需要调用哪些Skill。例如,用户说"帮我找一下2023年关于图神经网络的综述文章,并总结前三篇",系统会识别出需要两个Skill:

- Google Scholar搜索(查找文献)

- 文本总结(处理内容)

编排阶段:如果任务涉及多个Skill,系统会规划执行顺序和数据流。就像乐队指挥协调不同乐器,系统确保各个Skill按正确的顺序执行,前一个的输出成为后一个的输入。

执行阶段:实际调用Skill的代码,处理可能的错误,收集结果。

反馈阶段:将结果整合后呈现给用户,并根据用户的反馈(满意/不满意)调整未来的执行策略。

这种机制的关键在于"解耦"——每个Skill只负责一件事,彼此独立。这样,如果某个Skill出现问题,不会影响其他功能;如果需要升级某项能力,只需替换对应的Skill而不必重构整个系统。

"自我构建"的涌现能力

OpenClaw最令人惊叹的特性之一,是它可以"自己给自己写插件"。由于核心是大语言模型,它具备代码生成能力。当用户提出一个现有Skill无法满足的需求时,OpenClaw可以:

- 分析需求,设计技术方案

- 编写代码实现这个功能

- 测试代码是否工作

- 将新Skill安装到系统中

- 未来遇到类似需求时直接调用

一个真实案例:某用户希望OpenClaw能够监控Spotify播放列表的更新,并在有新歌加入时通知他。虽然ClawHub当时没有Spotify相关的Skill,但用户只需描述需求,OpenClaw就自己查阅了Spotify API文档、编写了集成代码、完成了测试,最终实现了这个功能。整个过程用户只做了两件事:提需求和确认安装。

这种"自举"能力模糊了"工具"与"创造者"的边界。传统上,工具是被动的——锤子不会自己变成螺丝刀。但OpenClaw可以根据需要"长出"新功能,这使得它具备了某种"进化"的特质。从长远看,这可能预示着未来软件开发的新模式:用户不再需要学习编程,只需清晰地描述需求,AI会自动生成所需的工具。

架构的优势与局限:辩证的审视

OpenClaw的"瑞士军刀"式架构并非完美无缺。在享受灵活性的同时,也必须承担复杂性的代价。

优势:灵活、可扩展、社区驱动

灵活性是最明显的优势。用户可以根据自己的需求、预算和风险偏好,自由组合模型和Skill。不喜欢某个云端模型?换一个。需要新功能?装个Skill。这种自主权在传统软件中很难实现。

可扩展性得益于模块化设计。随着AI技术的快速演进,新模型层出不穷,新应用场景不断涌现。OpenClaw的架构可以轻松吸纳这些变化——今天加入GPT-5的支持,明天集成最新的多模态模型,后天扩展到物联网设备控制,都不需要推倒重来。

社区驱动带来了创新的多样性。3000多个Skill不是一个公司的产品经理能想出来的,而是全球开发者集体智慧的结晶。这种分布式创新的效率,远超任何中心化组织。而且,社区会自然地淘汰低质量Skill、推广优秀Skill,形成一种自组织的质量控制机制。

局限:复杂性、碎片化、质量参差

但这种灵活性也带来了复杂性的负担。普通用户面对数千个Skill,很难判断哪个适合自己、如何配置参数、怎样组合使用。这就像进入一个巨大的五金店,货架上摆满了各种工具,但如果你不是专业人士,根本不知道该选什么。

技术门槛是真实存在的。虽然OpenClaw的理想是"人人可用",但实际上,要充分发挥它的能力,用户需要具备相当的技术素养——理解API配置、阅读文档、调试错误。这限制了它在非技术人群中的推广。

碎片化风险也不容忽视。由于Skill是社区贡献的,质量和风格千差万别。有的Skill文档详尽、代码规范,有的则粗制滥造、缺乏维护。用户安装了一堆Skill后,可能发现它们之间存在冲突,或者某个关键Skill突然不更新了。这种生态的不稳定性,对于需要可靠服务的机构用户来说是一个顾虑。

安全隐患在前文已经讨论,但在Skill层面尤为突出。每个Skill都是一段代码,理论上可以做任何事情——包括窃取数据、破坏系统。虽然OpenClaw有一定的沙盒机制,但社区贡献的代码难以逐一审查。如果安装了恶意Skill,后果可能很严重。这就像Android早期的应用市场,充满了恶意软件和山寨App。

与封闭生态的对比:HomeKit vs. 开源智能家居

OpenClaw的开放生态与苹果HomeKit等封闭生态形成了鲜明对比,这种对比在智能家居领域已有先例。

HomeKit模式:苹果严格控制生态,所有接入的设备必须通过MFi认证,所有应用必须遵守严格的审核标准。这带来了高度的统一性、安全性和易用性——用户不必担心兼容性问题,不必担心隐私泄露。但代价是选择有限、创新受限、成本较高。

开源智能家居模式(如Home Assistant):任何人都可以开发插件,支持数千种设备和服务。用户拥有完全的控制权和自定义能力。但配置复杂、稳定性不佳、需要较强的技术能力。

OpenClaw更接近后者。它为技术爱好者和专业用户提供了无限可能,但对普通用户来说门槛较高。未来,可能会出现一种"混合模式":官方维护一个经过审核的"推荐Skill"列表(类似HomeKit),同时保留社区自由贡献的"实验性Skill"(类似Home Assistant)。用户可以根据自己的风险承受能力选择不同的信任层级。

技术栈拆解:Node.js生态的福音

从实现技术来看,OpenClaw选择了Node.js + TypeScript的组合,这在AI应用中并不常见(大多数项目使用Python),但却是一个巧妙的选择。

为什么选择Node.js?

异步IO的天然优势:OpenClaw需要同时处理多个IM平台的消息、调用多个模型的API、执行多个Skill的任务。这种高并发场景正是Node.js的强项。其事件驱动的非阻塞架构,可以轻松应对数千个并发连接,而不需要复杂的多线程编程。

丰富的npm生态:Node.js拥有全球最大的包管理库npm,包含超过200万个模块。无论是IM集成(如WhatsApp Web.js)、数据库连接(如SQLite3)、还是HTTP客户端(如Axios),都有成熟的解决方案。OpenClaw的83.5% TypeScript代码中,大量使用了这些现成的轮子。

跨平台兼容性:Node.js可以无缝运行在Windows、macOS、Linux上,这对于一个开源项目至关重要。用户不必因为操作系统不同而放弃使用。

TypeScript的类型安全:虽然JavaScript足够灵活,但在大型项目中容易出错。TypeScript通过静态类型检查,可以在编译阶段发现大量潜在Bug,大大提高了代码质量。对于社区协作开发来说,类型定义也是重要的文档和接口契约。

Docker/Nix隔离部署

为了应对执行Shell命令带来的安全风险,OpenClaw支持两种隔离部署方式:

Docker容器化:将OpenClaw运行在独立的Docker容器中。即使AI执行了危险命令(如rm -rf /),受损的也只是容器内的虚拟环境,宿主机不受影响。容器销毁后重新创建即可恢复。

Nix环境:Nix是一种"函数式"包管理器,可以创建完全隔离、可复现的运行环境。使用Nix部署OpenClaw,可以确保所有依赖都在特定版本,避免"在我的机器上能跑"的经典问题。

这些隔离技术虽然增加了部署的复杂度,但对于安全敏感的用户(如图书馆、研究机构)来说是必要的。它们在灵活性和安全性之间找到了一个可接受的平衡点。

对未来AI生态的启示

OpenClaw的架构创新,不仅仅是一个具体产品的成功,更为整个AI应用生态提供了重要的启示。

"中间层"的价值:AI行业目前呈现"哑铃型"结构——一端是少数大厂垄断的基础模型,另一端是海量碎片化的终端应用,中间几乎是空白。OpenClaw的模型不可知架构,实际上是在构建一个"中间层":它向下对接多个模型供应商,向上支持各种应用场景。这种中间层可以大大降低应用开发的难度,也能削弱单一模型厂商的垄断力量。

标准化的必要性:OpenClaw的成功依赖于各大模型厂商的API相对标准化(都基于HTTP RESTful风格)。但目前仍有许多细节差异(如参数命名、错误处理)需要手动适配。如果未来能形成行业标准(类似HTML之于网页、SQL之于数据库),模型切换将更加无缝,生态将更加繁荣。这可能需要IEEE、W3C这样的标准化组织介入。

边缘计算的趋势:OpenClaw的本地部署模式,与当前云计算主导的潮流有所不同,但它可能预示了未来的方向。随着硬件算力的提升(如Mac M系列芯片、边缘AI加速器)和模型压缩技术的进步(如量化、蒸馏),越来越多的AI推理会回到本地进行。这不仅是隐私和成本的考虑,也是低延迟、离线可用的需求。OpenClaw的架构天然适应这个趋势。

开源与商业的共生:OpenClaw是开源的,但它依赖商业公司的API(Anthropic、OpenAI)。这种关系既有合作(开源生态为商业模型带来流量和收入),也有张力(开源工具挑战商业公司的应用层垄断)。未来可能形成一种新的平衡:基础模型商业化,应用层开源化。就像Linux操作系统(开源)与云服务(商业)的关系一样。

结语:百川汇海,各取所需

OpenClaw的技术架构如同"百川汇海"——它汇聚了多个模型的智慧、数千个Skill的能力、无数开发者的贡献,形成了一个丰富多样的生态系统。这种"各取所需"的灵活性,正是它区别于封闭产品的最大优势。

对于图书馆和研究机构来说,这种架构提供了一个重要的启示:构建AI服务不必从零开始,可以基于开放标准和模块化组件。与其花费巨资自研一个大而全的系统,不如学习OpenClaw的思路:定义清晰的接口,集成优秀的开源模块,根据实际需求灵活配置。

当然,开放架构也意味着需要更强的技术治理能力——如何选择可信的Skill、如何审核代码安全、如何培训用户、如何应对技术支持的复杂性。这些都是机构决策者需要权衡的问题。但可以确定的是,随着AI技术的不断成熟,这种模块化、标准化的架构模式将越来越成为主流。

在下一篇文章中,我们将聚焦OpenClaw最具创新性的组件——数字记忆系统。它如何实现跨对话的连续记忆?Markdown文件的"白盒"设计有何独特价值?混合检索策略如何平衡语义理解与精确匹配?敬请期待。

【下期预告】数字记忆——让AI拥有连续的"过去"。我们将深入剖析OpenClaw记忆系统的三层架构、混合检索的技术细节、透明化设计的哲学意义,以及这种创新对学术AI工具的重要启示。

留下评论