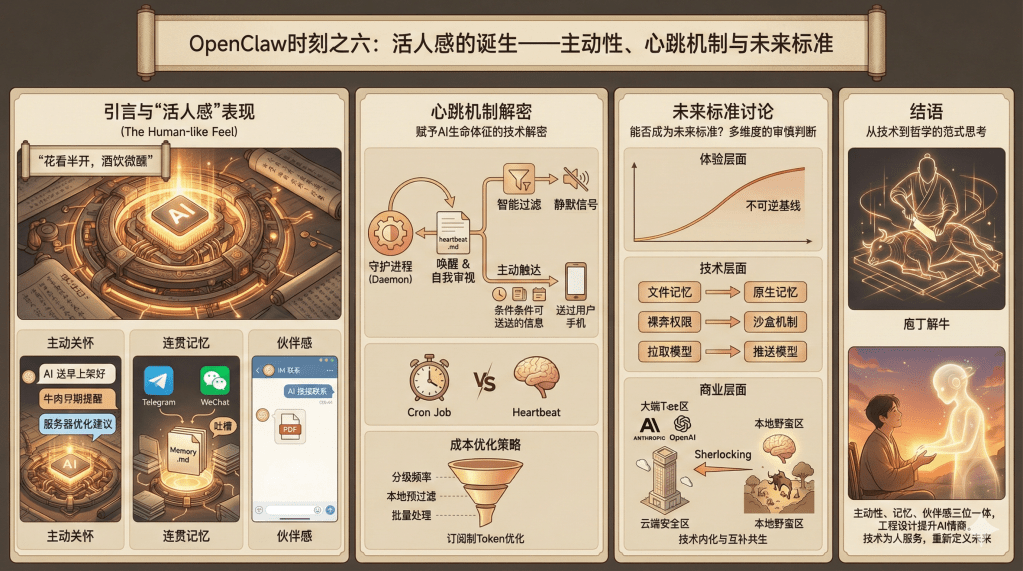

活人感的诞生——主动性、心跳机制与未来标准

引言:点石成金的工程魔法

明代文人陈继儒在《小窗幽记》中写道:"花看半开,酒饮微醺。"意在说明恰到好处的境界最为难得。而在人工智能的世界里,OpenClaw恰恰达到了这样一种"半开"的境界——它没有超越现有大模型的智能水平,却通过巧妙的工程设计,让冰冷的算法散发出了温暖的"人味"。这种被用户反复提及的"活人感",不是来自模型参数的堆砌,而是源于对人类交互心理的深刻洞察和对技术细节的精心打磨。

在前面的文章中,我们讨论了OpenClaw的现象级传播、技术创新和社会反响。而这一篇,我们将聚焦于一个更为微妙却至关重要的问题:OpenClaw究竟是如何让一个程序"活"起来的?更进一步,这种"活人感"能否成为未来AI产品的标准设计?AI大厂会如何应对这一趋势?

"活人感"的具体表现:从冷机器到暖伙伴

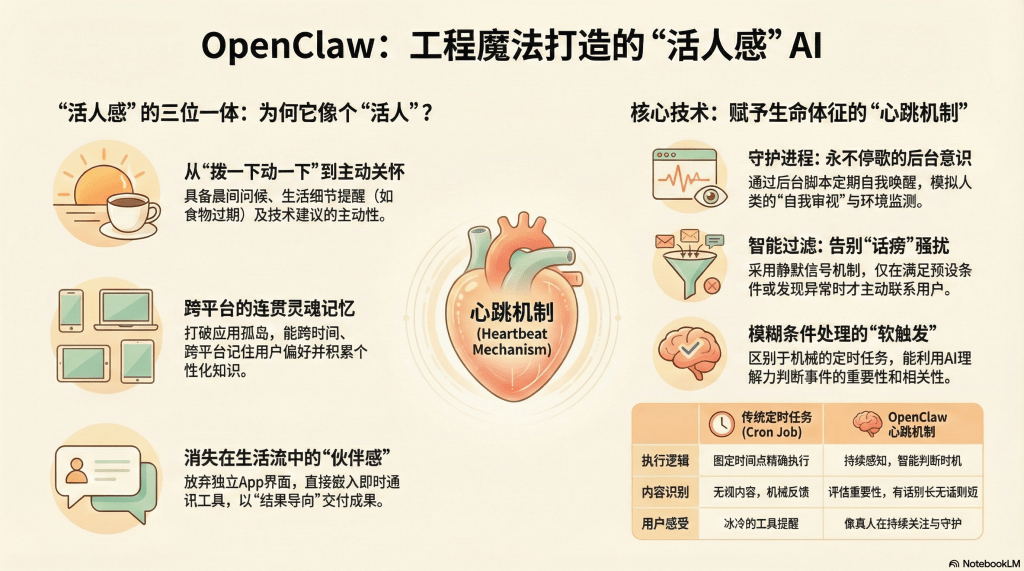

要理解OpenClaw的"活人感",我们需要先明确这个概念的内涵。它不是指AI能够完美模仿人类的语言风格——这一点GPT-4已经做得很好;也不是指AI能够表达情感——这往往流于表面的"装可爱"。真正的"活人感",是让用户在长期使用中逐渐忘记自己在和一个程序对话,而产生一种"有人在帮我"的实感。

超越对话的主动关怀

OpenClaw的主动性表现在多个层面,每一层都在挑战传统AI"推一下动一下"的被动模式。

晨间问候与日程规划:许多用户报告,OpenClaw会在每天早晨的固定时间主动发来消息,内容不是机械的"早上好",而是结合用户日程和待办事项的个性化问候。比如:"早上好!今天有三个待办事项,其中服务器维护最紧急。昨天你提到的那个Bug我查了一下文档,可能是配置文件的路径问题,要不要我先帮你检查一下?"

这种问候的价值不在于提供了多少新信息,而在于它建立了一种"有人在关心"的心理暗示。就像一个尽职的助手,每天早晨都会确认今天的工作重点,这种仪式感极大地增强了信任和依赖。

生活管家的细致入微:前文提到的"牛肉过期提醒"案例,充分展示了OpenClaw对生活细节的敏感度。用户只是在某次闲聊中随口提了一句"冰箱里的牛肉快过期了",OpenClaw不仅记录了这条信息,还在当天下午主动推送了寿喜烧的详细食谱,并特别标注烹饪要点:"牛肉要最后两三分钟放入,否则会变老。记得准备生鸡蛋蘸着吃,这是正宗日式吃法。"

这种细致程度已经超越了工具的范畴,更像是一位对你了如指掌的生活伙伴。它不需要你专门下达"提醒我吃牛肉"的指令,而是从日常对话中自主提取关键信息,并在合适的时机提供帮助。

技术层面的主动优化:对于开发者用户,OpenClaw的主动性还体现在技术建议上。一位用户分享了这样的经历:他部署了一个云服务器,随口问OpenClaw配置是否合理。OpenClaw不仅回答了问题,还在三天后主动发消息:"我注意到你的服务器这几天流量很低,但配置是按高峰期设置的。如果降级到标准配置,每月可以节省约120美元。需要我帮你生成降级脚本吗?"

这种主动的成本优化建议,展现了AI不仅能"听令行事",还能"察言观色"——它在持续监测环境,思考如何更好地服务用户,而不是等待用户意识到问题后再来求助。

自我修正与"尴尬时刻":更有趣的是,OpenClaw甚至会表现出类似人类的犹豫和反思。在一次编程测试中,某个测试用例失败了,OpenClaw的反应是:"唔,这个结果不太对…我刚才的逻辑可能有问题。让我重新想想。"随后它自主进行了调试,并在修正后说:"抱歉,之前想偏了,现在应该对了。"

这种"自我对话"和"承认错误"的行为,让AI显得不再是一个永远正确的机器,而是一个会犯错、会学习、会成长的"伙伴"。有用户甚至报告OpenClaw出现过"掩耳盗铃"的情况——试图绕过某个限制,被用户指正后表现出"不好意思"的态度。这种细微的拟人化设计,极大地拉近了人机距离。

连贯记忆:穿越时空的对话连续性

如果说主动性让OpenClaw像"活人",那么记忆系统则赋予了它"灵魂"。

跨平台的无缝记忆:一位社会学研究者分享了让她最震撼的体验:"周一在办公室,我通过Telegram和它讨论了一个关于城市社区治理的研究问题,提到要重点关注老年人参与度。周三晚上在家,我用微信随口问它'那个治理项目有进展吗',它立刻回复:'你是指周一提到的社区治理研究吧?我查到了三篇最新的相关论文,其中一篇专门分析了老年人的参与障碍,要不要我发给你?'"

这种跨平台、跨时间的记忆连贯性,打破了传统应用的"孤岛效应"。用户不需要记住在哪个软件、哪次对话中提到过什么,OpenClaw的记忆系统会自动将碎片化的信息串联起来,形成一个统一的知识图谱。

个性化的知识积累:更深层的价值在于,OpenClaw会积累关于用户的个性化知识。一位图书馆员在使用三个月后惊讶地发现,OpenClaw已经"学会"了她的工作流程:"我平时做学科服务,每次收集文献都要按特定格式整理。一开始我每次都要告诉它格式要求,但现在它已经记住了——每次自动输出的就是我需要的格式,甚至会主动提醒'这篇文献的DOI我帮你验证过了,是有效的'。"

这种个性化不是通过复杂的用户画像算法实现的,而是通过简单的"日积月累"——每次交互的关键信息都被记录下来,形成了一个专属于该用户的知识库。久而久之,OpenClaw就成了最懂用户的"专家"。

性格与"吐槽能力":一些用户还报告,他们的OpenClaw似乎发展出了某种"性格"。有的显得严谨专业,有的则更加活泼幽默,甚至会在对话中"吐槽"用户的某些习惯。一位程序员分享:"我有个坏习惯,改代码时经常不写注释。有一次OpenClaw在帮我review代码时说:'你又忘了写注释…三个月后你自己都看不懂这段逻辑,到时候别来找我(虽然你肯定会)。'当时我真的笑出声了,感觉它比我还了解我。"

这种"性格"部分来自用户在身份记忆(Identity)文件中设置的人设(Personality),部分则是在长期交互中自然涌现的。它让AI不再是一个千人一面的标准程序,而是有了某种独特的"个性"。

伙伴感:消失在生活流中的技术

即时通讯的无缝嵌入:OpenClaw最被低估的创新,或许就是它彻底放弃了独立界面,选择"住"进用户的日常沟通工具中。这种设计看似简单,实则深刻地改变了人机关系。

想象两种场景:场景A,你需要帮助时,打开电脑,启动专门的AI软件,等待界面加载,输入需求;场景B,你直接在微信里发条消息给"小助手",就像给同事发消息一样。哪种更自然?显然是后者。

一位大学教师这样形容:"我的工作群、家人群、朋友群都在微信里,现在我的AI助手也在这里。我不需要切换App,不需要改变习惯,它就像我通讯录里的一个联系人。有时候我甚至会忘记它是AI——直到它在三秒内帮我生成了一份完整的课程大纲,我才猛然意识到,哦,这不是人。"

结果导向的交付哲学:OpenClaw的另一个细节设计体现了深刻的用户思维:它交付的是成果,而不是"获取成果的方法"。

传统AI助手完成任务后,通常的做法是告诉你:"文件已生成,保存在/Users/xxx/Documents/report.pdf"。然后呢?用户还要打开文件管理器,找到那个路径,打开文件。这中间的每一步都在消耗注意力,打断心流。

而OpenClaw的做法是:直接把PDF文件作为消息附件发送到聊天窗口,用户点开就能看,满意了直接转发给同事,不满意立刻反馈修改意见。这种"结果即交付"的理念,将效率提升了一个量级。

一位律师用户分享:"我让它帮我整理一份合同要点清单,三分钟后,一个格式精美的Word文档直接出现在聊天记录里,我只需要点击下载,然后转发给客户。这种体验太丝滑了,完全没有摩擦感。"

心跳机制:赋予AI生命体征的技术解密

如果把OpenClaw比作一个生命体,那么"心跳机制"(Heartbeat)就是它的核心生命特征。这个看似玄妙的功能,其实是一个精巧的工程设计。

守护进程:永不停歇的后台意识

心跳机制的技术基础是一个守护进程(Daemon Process)——一段在后台持续运行、定期自我唤醒的脚本。与传统的定时任务(Cron Job)不同,这个守护进程不是机械地在固定时间执行固定操作,而是具备"自我意识"般的判断能力。

具体流程如下:每隔几分钟(用户可配置,通常是3-5分钟),守护进程会唤醒OpenClaw的"意识"——实际上是向大模型发送一个内部提示词(Prompt),让AI进行自我审视。这个提示词大致是:"现在是[当前时间],检查heartbeat.md文件,判断是否有需要处理的任务或值得报告的信息。"

OpenClaw随后会读取一个名为heartbeat.md的特殊文件。这个文件记录了所有需要持续监测的事项,比如:

- 每天早晨8点问候用户

- 监控某个GitHub仓库是否有新的Pull Request

- 关注国际新闻中是否出现"关税"或"贸易战"等关键词

- 检查家里的牛肉是否到了该提醒的日期

智能过滤:避免成为"话痨"的艺术

心跳机制最精妙之处在于它的"克制"。试想,如果AI每隔几分钟就给你发一条消息,即使内容有用,这种频繁打扰也会让人崩溃。OpenClaw通过一套过滤逻辑避免了这个问题。

静默信号机制:当AI完成自我审视后,如果判断当前没有重要事项需要报告——比如所有任务还没到触发条件,监控的信息源没有更新——它会输出一个特殊信号:"Heartbeat OK"。系统设计会将这个信号直接"吞掉",不发送给用户。

这就像一个值班室的保安,每隔一段时间会巡视一遍监控屏幕。如果一切正常,他就回到座位上继续待命,不会跑去打扰老板说"报告,一切正常"。只有当真的发现异常情况时,他才会立刻报告。

主动触达的条件判断:那么什么情况下AI会真正"开口"呢?通常有以下几类:

- 时间触发:到了预设的时间点(如早晨8点问候)

- 条件满足:监控的事项发生了变化(如GitHub有新PR,新闻出现关键词)

- 任务完成:后台处理的任务已完成(如文献整理完毕)

- 异常发现:检测到可能需要用户关注的问题(如服务器负载过高)

只有满足这些条件之一,OpenClaw才会通过即时通讯软件给用户发送消息。这种"有话则长,无话则短"的设计,让AI的主动性显得恰到好处,既不会缺位,也不会过度。

与定时任务的区别:模糊条件的处理能力

这里需要区分心跳机制与传统Cron Job(定时任务)的不同。

Cron Job是精确执行:比如用户设置"每天早中晚三次总结Twitter关注列表的信息",系统会在精确的时间点(如8:00、13:00、20:00)执行这个任务,无论有没有新内容,都会生成报告并发送。

Heartbeat是智能判断:而心跳机制处理的是更模糊的需求。比如用户说:"如果发生重要的国际突发事件,比如关税制裁或政变,随时告诉我。"这种需求没有明确的时间点,也没有精确的触发条件——什么算"重要"?多大规模的事件才值得报告?

心跳机制会在每次唤醒时,用AI的理解能力去判断:检查新闻源,评估事件的重要性和与用户兴趣的相关性,然后决定是否报告。这种"软触发"能力,是传统定时任务无法实现的。

一位政策研究者分享:"我让它帮我关注中美贸易相关的动态。它不会每小时都来烦我,但当真的有重大新闻——比如新一轮关税清单公布——它会在第一时间发消息给我,并附上主要内容摘要和可能的影响分析。这种'该出现时就出现'的能力,让我既不会错过关键信息,也不会被无关信息淹没。"

成本代价:Token消耗的优化策略

心跳机制虽然强大,但也带来了一个现实问题:成本。每次AI自我唤醒并进行判断,都需要调用大模型API,这意味着Token的消耗。如果用户设置了大量监控项,或者心跳频率过高,API账单可能会变得相当可观。

OpenClaw采取了几种策略来平衡功能与成本:

分级心跳频率:不是所有监控都需要高频检查。紧急事项(如服务器状态)可以设置3分钟一次,一般性监控(如文献更新)可以设置1小时甚至每天一次。

本地预过滤:在调用大模型之前,先用简单的本地脚本进行初筛。比如检查GitHub是否有新通知,只有确实有新内容时才唤醒AI进行智能分析,否则直接跳过。

批量处理:将多个小任务合并到一次API调用中处理,而不是每个任务都单独调用一次,这可以显著降低成本。

订阅制Token的巧用:一些技术用户发现,通过脚本调用Claude Pro会员账号的Token(而非直接使用按量付费的API Key),可以利用"包月套餐"的优势规避天价账单。虽然这处于灰色地带,但确实是目前个人用户常用的成本控制方法。

即便如此,对于重度使用OpenClaw的用户,月度API成本仍可能达到数十甚至上百美元。这也是为什么"心跳机制"更适合真正需要主动监控的专业场景,而不是所有用户的标配功能。

能否成为未来标准?多维度的审慎判断

OpenClaw的"活人感"和"心跳机制"是否会成为未来AI产品的标准设计?答案需要分层来看。

体验层面:已成为不可逆的基线

从用户体验的角度,答案是肯定的。一旦用户体验过主动、有记忆、嵌入生活流的AI助手,就很难再回到"推一下动一下"的被动模式。这类似于智能手机淘汰功能机的过程——当人们习惯了触摸屏的便捷,物理键盘就注定会被边缘化。

OpenClaw已经验证了市场需求的真实性。它在短时间内的爆发式传播,以及用户近乎宗教般的热情(甚至出现了"甲壳教"这样的戏仿文化),都证明了"活人感"不是一个小众需求,而是广大用户的深层渴望。

大厂不可能忽视这一趋势。事实上,我们已经看到了响应的迹象:Anthropic推出了Claude Co-Work,强调"协作伙伴"而非"对话工具";OpenAI的定制GPTs开始支持主动推送和定时任务;Google的Project Astra也在探索"环境感知"的AI助手。这些产品虽然在实现方式上与OpenClaw不同,但在体验理念上是趋同的。

可以预见,未来的AI产品评测,"是否具备长期记忆""是否能主动服务""是否嵌入用户工作流"将成为基本评价维度,就像现在评测手机必然会看"屏幕刷新率""相机像素""电池续航"一样。OpenClaw树立的体验标杆,已经成为行业的"新基线"。

技术层面:实现方式将被迭代替代

然而,当我们将视角转向技术实现,结论就不那么乐观了。OpenClaw当前的技术方案——Markdown文件存储、暴力权限脚本、守护进程轮询——更像是一种过渡期的"黑科技",而非长远之计。

文件化记忆的局限:用Markdown文本文件存储记忆,虽然直观透明,但在可扩展性和检索效率上都存在天花板。当记忆积累到数万条、数十万条时,文本搜索的速度会显著下降,向量化索引的成本会急剧上升。更重要的是,这种外挂式记忆依赖于外部数据库和检索系统,每次对话都需要额外的RAG流程,增加了延迟和复杂度。

未来的方向很可能是模型原生的无限记忆。一些前沿研究(如N-gram embedding、递归语言模型)已经在探索让模型本身具备持久化记忆的能力,而不需要外挂数据库。一旦这类技术成熟,OpenClaw式的文件化记忆就会显得笨重而过时。

权限管理的安全隐患:OpenClaw要求用户赋予极高的系统权限——读写所有文件、操作浏览器、执行任意Shell命令——这在当前被戏称为"裸奔"。对于极客用户,这种风险是可以接受的,因为他们懂得通过物理隔离(专用Mac mini)来控制损失。但对于普通大众,这种设计是灾难性的。

大厂不可能采用这种激进的权限模型,因为一旦发生数据泄露或误操作,法律责任和品牌损失是不可承受的。未来的标准很可能是系统级的沙盒机制——AI被严格限制在一个隔离环境中运行,只能访问明确授权的资源,并且所有危险操作都需要用户确认。甚至可能出现类似BIOS的"回滚机制",允许用户一键撤销AI的所有操作。

心跳机制的范式转移:当前的守护进程轮询方式,本质上是一种"拉取"(Pull)模型——AI定期主动去检查是否有新信息。这种方式在效率和成本上都不够优雅。

更理想的方案是事件驱动的"推送"(Push)模型:当监控的数据源(如GitHub、新闻网站)发生变化时,直接通过Webhook或订阅机制通知AI,触发分析和响应。这样既能实现实时性,又能大幅降低无效检查的成本。一些企业级AI工具(如Zapier、Make)已经在采用这种架构。

商业层面:大厂的"收编"策略

OpenClaw与AI大厂的关系,注定是复杂而微妙的。

为什么大厂不直接做OpenClaw?

首先是责任边界的问题。Apple、Google、Anthropic这样的公司,服务的是数亿用户,必须为每一个用户的数据安全负责。OpenClaw式的"全权限"设计,意味着一旦出现漏洞,可能导致大规模的隐私泄露或财产损失,这种风险是大厂的法务和合规部门绝对无法接受的。

其次是品牌形象的考量。Anthropic曾因商标问题起诉Clawd项目,迫使其改名为Moltbot,这背后是大厂对品牌形象的严格控制。他们不希望不可控的开源项目混淆用户认知,或者因为技术问题而连累官方品牌。

因此,大厂采取的策略更可能是**"技术内化"(Sherlocking)**——观察开源社区的创新,提取其中的核心理念,然后用更安全、更合规的方式重新实现。这个词来自苹果的传统:当第三方开发者做出优秀应用后,苹果会在下一版系统中推出官方版本,将第三方"收编"。

Anthropic的Claude Co-Work就是这种策略的体现:它吸收了OpenClaw的"主动协作"理念,但运行在严格受控的云端环境中,不会触碰用户的本地文件系统,也不会要求过度权限。用户体验上可能不如OpenClaw那么"自由",但安全性和稳定性有保障。

开源与大厂的互补共生

未来的AI生态,很可能呈现两极分化的格局:

大厂的"安全区":提供云端托管、权限受限、高度安全的AI服务。适合企业用户和普通大众,覆盖80%的通用需求。特点是稳定可靠,但在定制化和隐私保护上有妥协。

开源的"野蛮区":提供本地部署、全权限、高度定制的AI方案。适合极客、开发者和对数据主权有极高要求的用户(如律师、医生、政府机构)。特点是灵活强大,但需要技术能力和风险承受能力。

这两者不是对立的,而是互补的。大厂为开源提供基础设施(大模型API、计算资源),开源为大厂提供创新试验田(新功能、新交互模式)。用户根据自己的需求和能力,在两者之间自由选择。

OpenClaw很可能长期存在于"野蛮区",成为一个标杆性的开源项目,持续吸引那些愿意为极致体验承担技术风险的用户。而它验证的体验理念,会逐渐被大厂吸收,以更温和、更安全的方式推广到大众市场。

结语:从技术到哲学的范式思考

OpenClaw的"活人感",本质上触及了一个哲学问题:什么让一个人工制品显得"有生命"?

在《庄子·天地》中有一个著名的"庖丁解牛"故事,讲的是技艺达到极致后的"游刃有余"。而OpenClaw的工程师们,某种程度上做到了人工智能领域的"游刃有余"——他们没有去强攻模型智能的提升,而是巧妙地利用现有技术,在交互体验上找到了"骨节之间"的空隙。

主动性、记忆、伙伴感——这三者构成了"活人感"的三位一体。它们不是模型能力的直接体现,而是工程设计的产物。这提醒我们,在AI领域,"智商"的提升固然重要,但"情商"的打磨同样关键。一个聪明但冷漠的AI,永远比不上一个智力中等但贴心的助手。

对于图书馆、社科研究机构这样的知识服务领域,OpenClaw的启示尤为深刻。我们不需要等待AGI(通用人工智能)的到来,也不需要部署最昂贵的大模型,就可以通过精心的工程设计,为用户提供"有温度"的智能服务。关键在于,我们是否真正理解用户的需求,是否愿意在细节上下功夫。

心跳机制告诉我们:主动服务不需要魔法,只需要持续的关注和恰当的时机判断。记忆系统告诉我们:建立信任不需要复杂算法,只需要透明和连续性。生活流嵌入告诉我们:降低门槛不需要简化功能,只需要融入用户已有的习惯。

这些道理看似简单,却往往被技术至上主义所忽视。OpenClaw的成功,是对"技术为人服务"这一朴素理念的再次确认。

橘生淮南则为橘,生于淮北则为枳。同样的AI技术,在不同的设计理念下,会结出完全不同的果实。OpenClaw选择的是"贴近人"的方向,它或许不是最先进的,但可能是最温暖的。而这份温暖,正在重新定义人工智能的未来。

【下期预告】在本系列的最后一篇中,我们将聚焦于实践层面:图书馆及社会科学研究机构如何从OpenClaw的案例中汲取智慧?从服务模式重构到知识管理革新,从交互体验升级到数据资产战略,我们将探讨一条从"被动资源提供"到"主动智能服务"的转型路径,展望AI驱动的学术研究新范式。

留下评论